简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

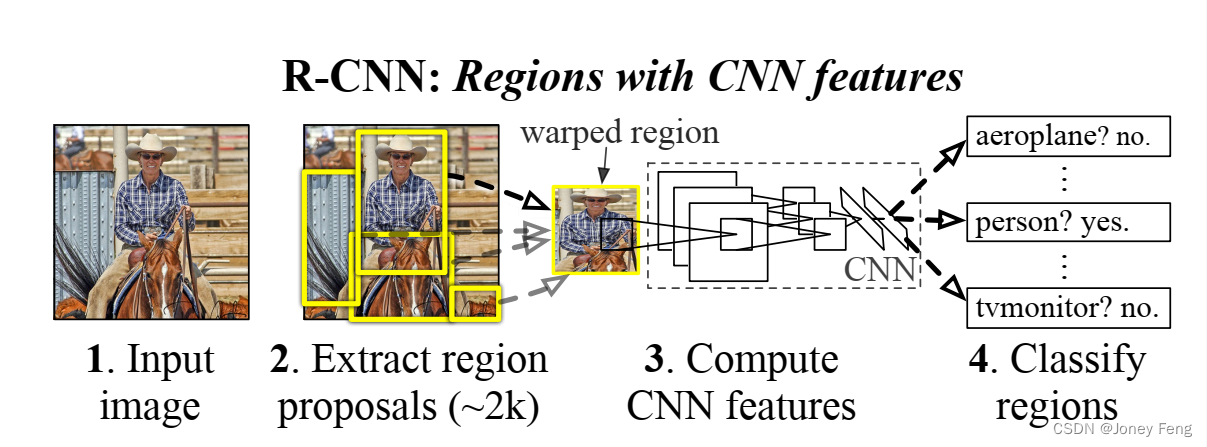

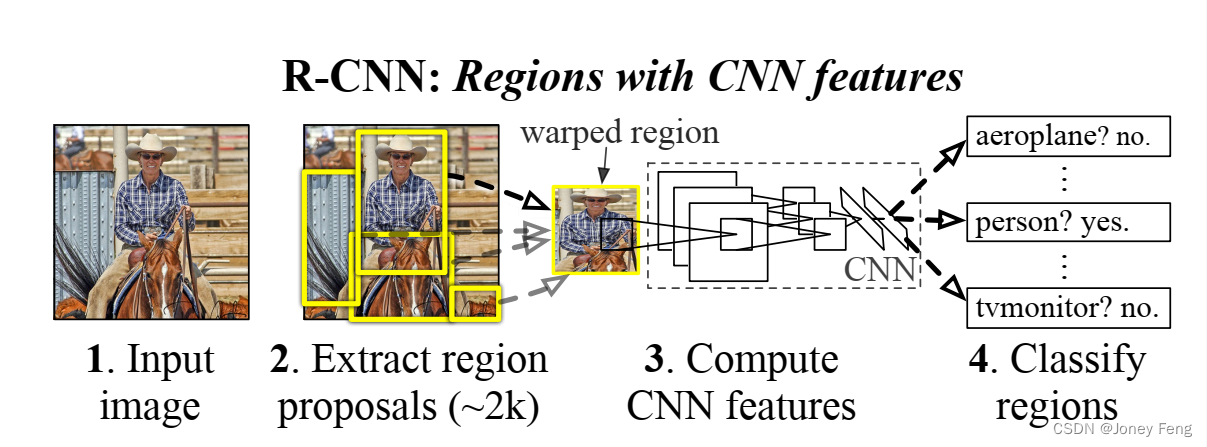

特征很重要。过去十年在各种视觉识别任务上取得的进展主要基于SIFT [29]和HOG [7]的使用。但是如果我们看一下在经典的视觉识别任务PASCAL VOC目标检测 [15]上的表现,普遍认为在2010年至2012年期间进展缓慢,只通过构建集成系统和使用成功方法的轻微变体获得了小幅增益。SIFT和HOG是基于块状方向直方图的表示方法,我们可以将其粗略地与灵长类动物视觉通路中的V1区的复杂细胞相关

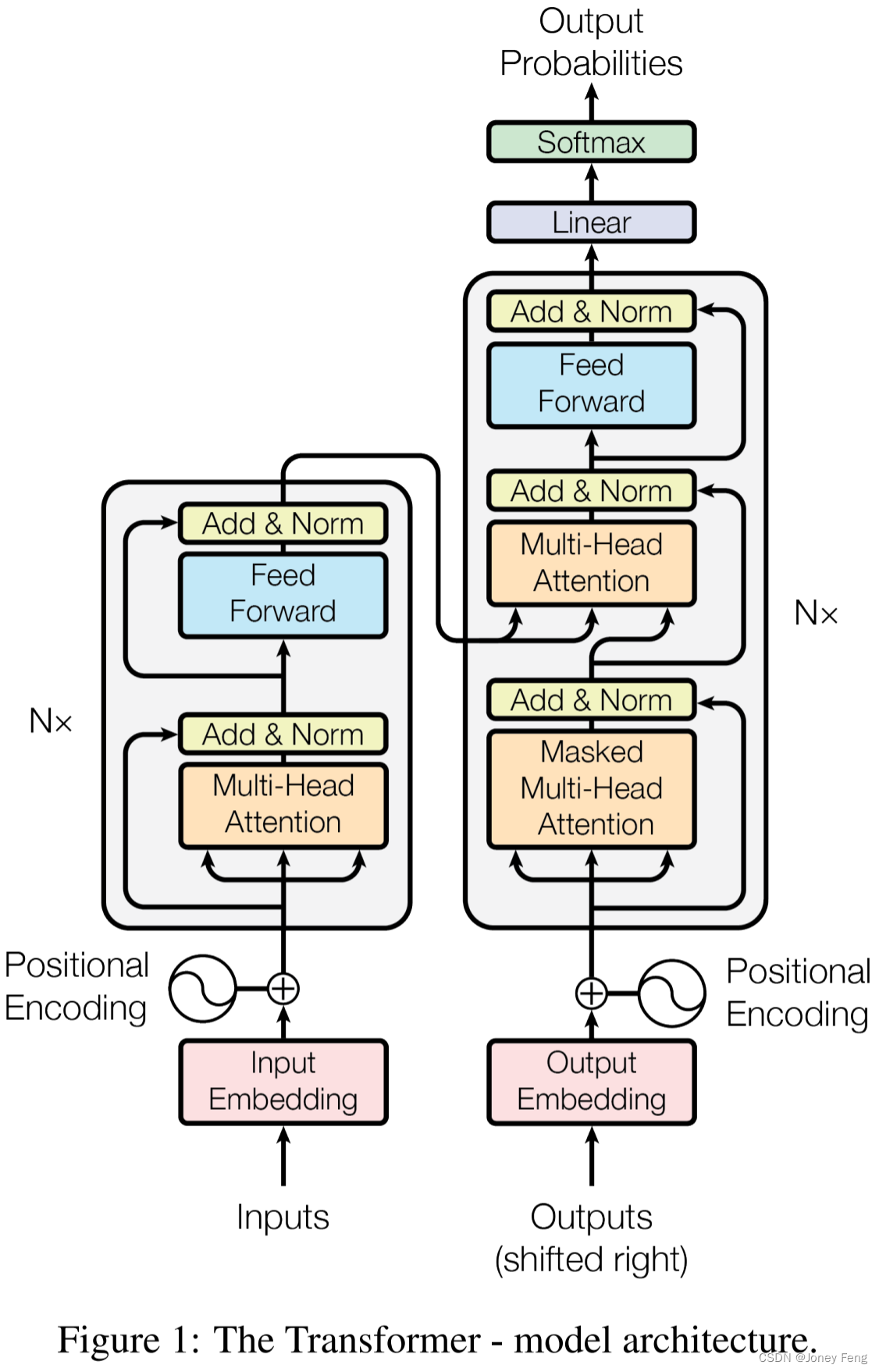

主导的序列转换模型基于包含编码器和解码器的复杂递归或卷积神经网络。表现最好的模型还通过注意机制将编码器和解码器连接起来。我们提出了一种新的简单网络架构——Transformer,仅基于注意机制,完全放弃了递归和卷积。在两个机器翻译任务上的实验表明,这些模型在质量方面更优秀,同时更具并行性,需要的训练时间显著减少。在WMT 2014英德翻译任务中,我们的模型达到了28.4 BLEU分数,比现有最佳结

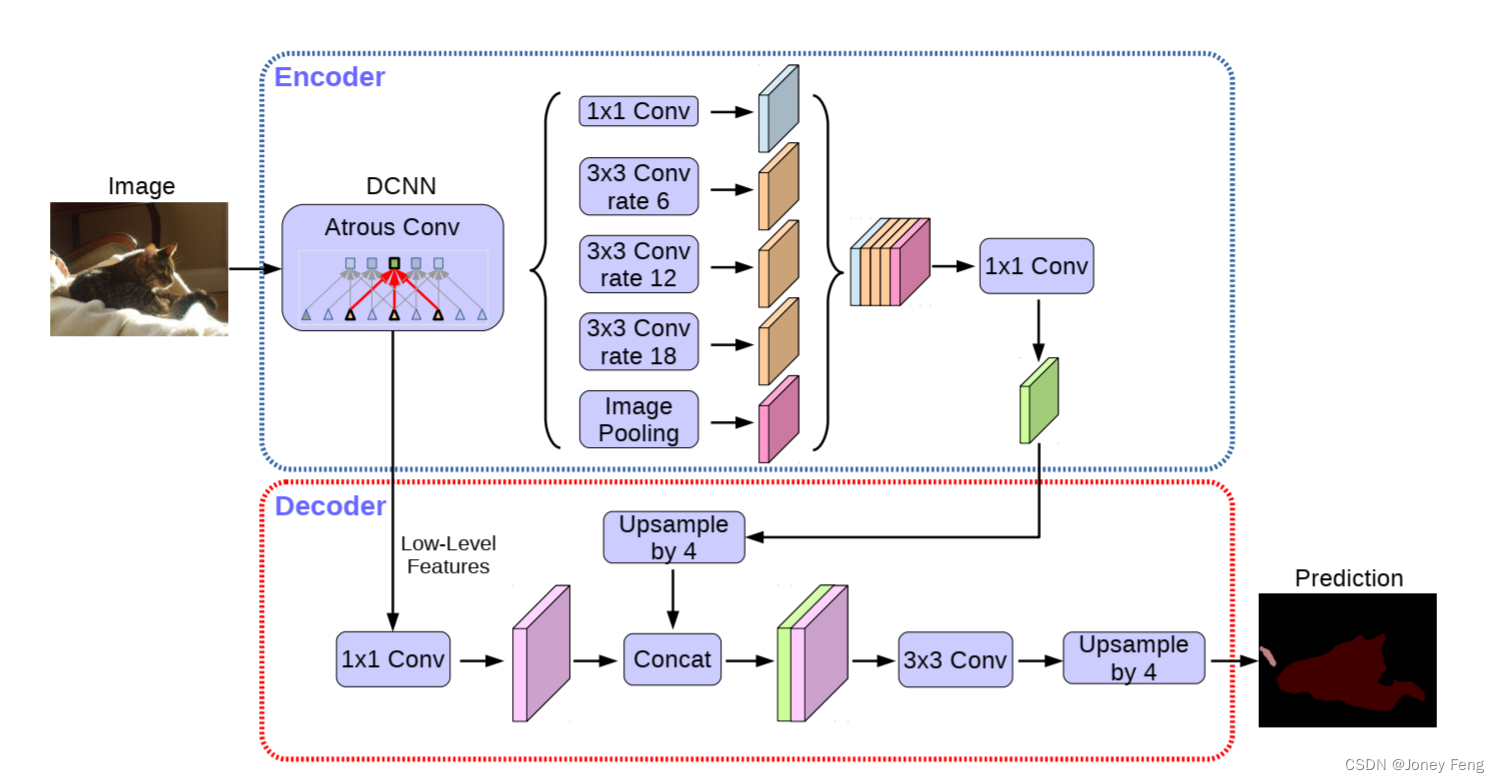

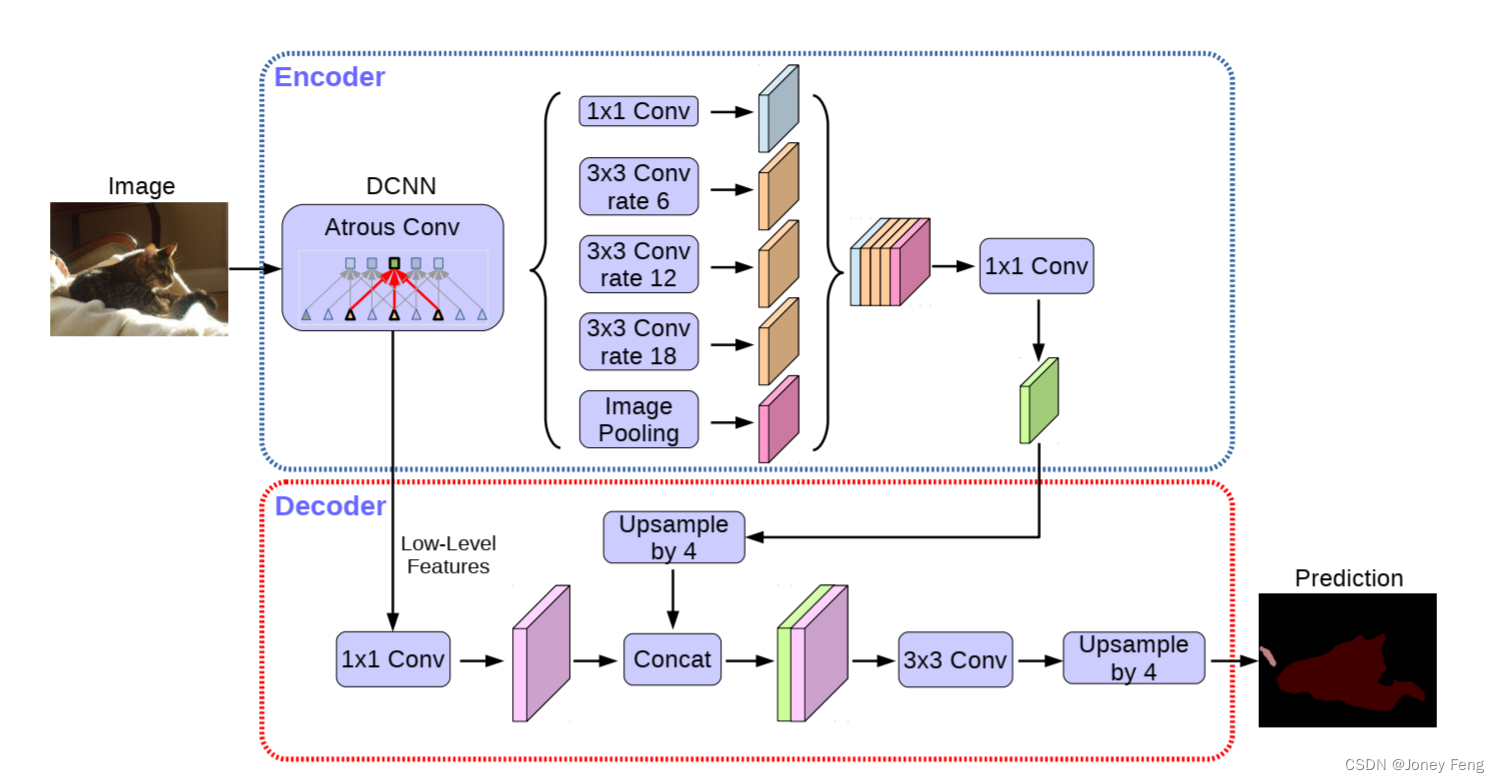

在深度神经网络中,空间金字塔池化模块或编码-解码结构被用于语义分割任务。前者通过在多个速率和多个有效视野下使用滤波器或池化操作来编码多尺度的上下文信息,而后者则通过逐渐恢复空间信息来捕捉更清晰的物体边界。在本文中,我们提出将两种方法的优点相结合。具体而言,我们提出的模型DeepLabv3+在DeepLabv3的基础上添加了一个简单但有效的解码器模块,以改进分割结果,特别是沿着物体边界的部分。

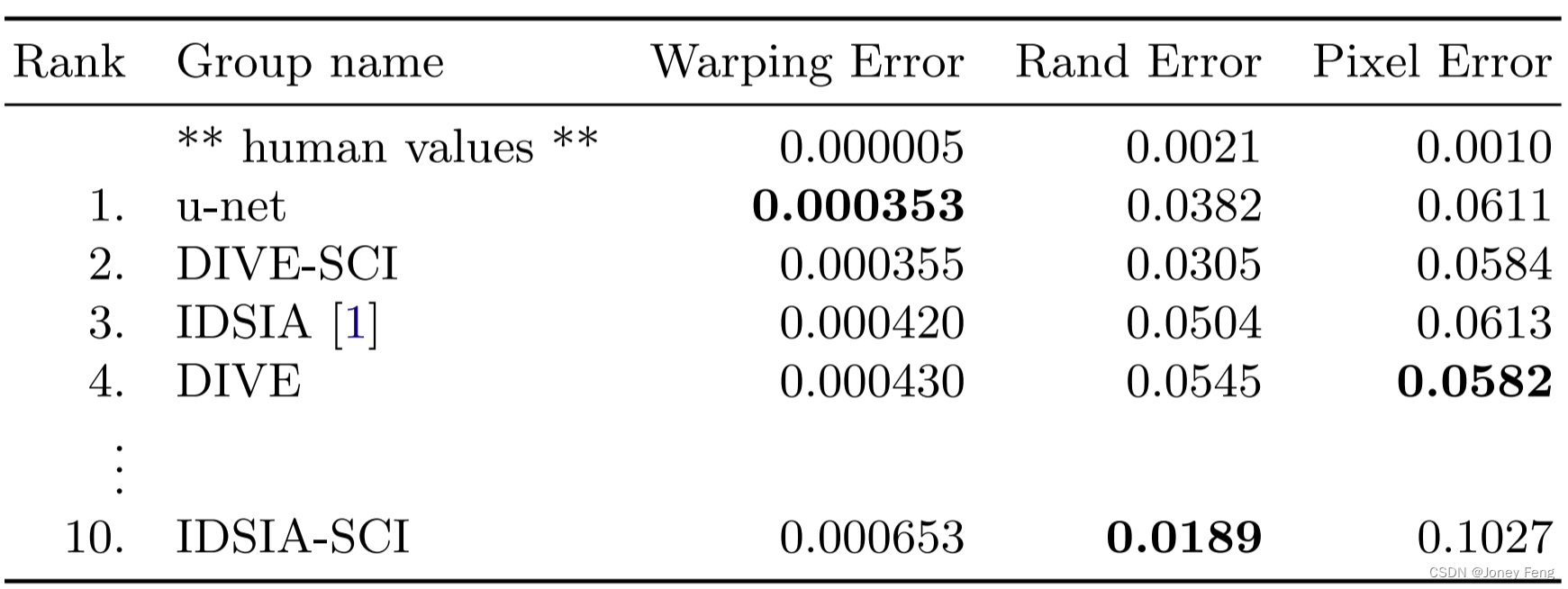

大多数人都认为成功训练深度网络需要成千上万个注释训练样本。在本文中,我们提出了一种网络和训练策略,依靠强大的数据增强来更有效地利用现有的注释样本。该架构由一个收缩路径和一个对称扩展路径组成,收缩路径用于捕捉上下文信息,扩展路径用于精确定位。我们证明,这样的网络可以从很少的图像进行端到端的训练,并在ISBI挑战中对电子显微镜堆栈中神经结构分割的先前最佳方法(滑动窗口卷积网络)进行了超越。

特征很重要。过去十年在各种视觉识别任务上取得的进展主要基于SIFT [29]和HOG [7]的使用。但是如果我们看一下在经典的视觉识别任务PASCAL VOC目标检测 [15]上的表现,普遍认为在2010年至2012年期间进展缓慢,只通过构建集成系统和使用成功方法的轻微变体获得了小幅增益。SIFT和HOG是基于块状方向直方图的表示方法,我们可以将其粗略地与灵长类动物视觉通路中的V1区的复杂细胞相关

在深度神经网络中,空间金字塔池化模块或编码-解码结构被用于语义分割任务。前者通过在多个速率和多个有效视野下使用滤波器或池化操作来编码多尺度的上下文信息,而后者则通过逐渐恢复空间信息来捕捉更清晰的物体边界。在本文中,我们提出将两种方法的优点相结合。具体而言,我们提出的模型DeepLabv3+在DeepLabv3的基础上添加了一个简单但有效的解码器模块,以改进分割结果,特别是沿着物体边界的部分。

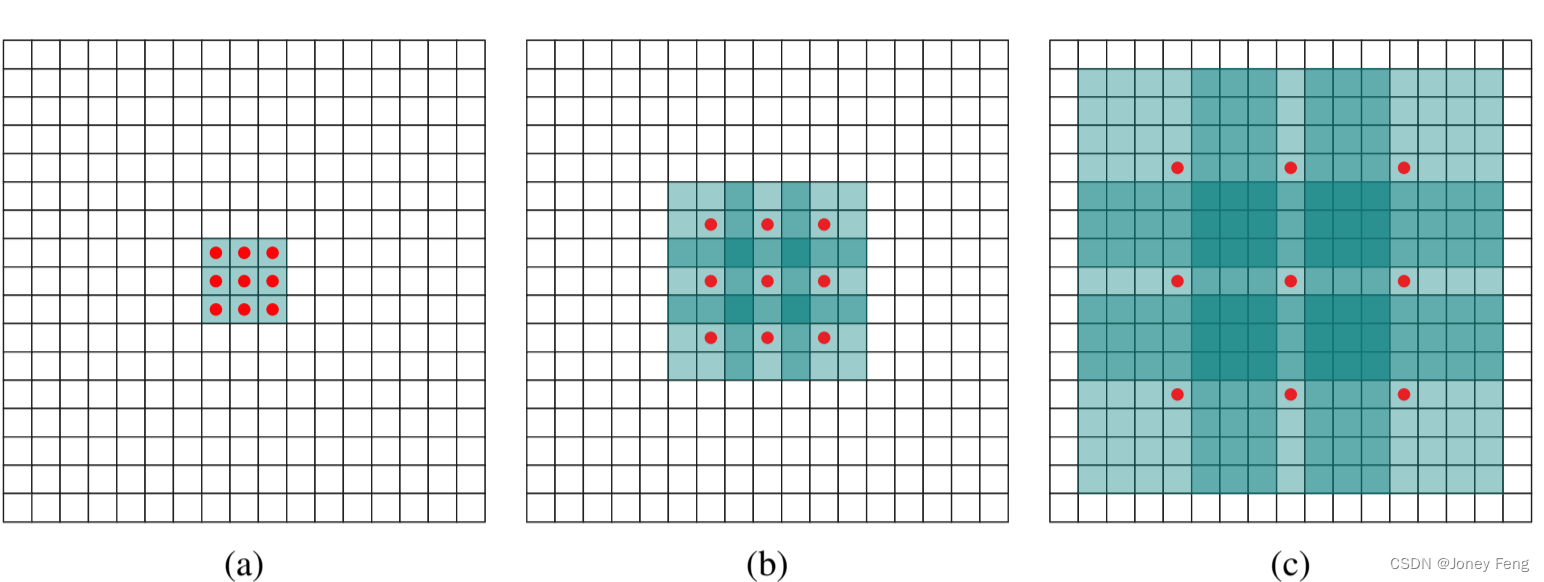

目前用于语义分割的先进模型是基于最初设计用于图像分类的卷积网络的改进。然而,像语义分割这样的密集预测问题在结构上与图像分类不同。在这项工作中,我们开发了一个专门为密集预测设计的新的卷积网络模块。所提出的模块使用膨胀卷积来系统地聚合多尺度的上下文信息,而不会丢失分辨率。该架构基于膨胀卷积支持对感受野的指数级扩展,同时不会丢失分辨率或覆盖范围。我们证明了所提出的上下文模块可以提高最先进的语义分割系统的

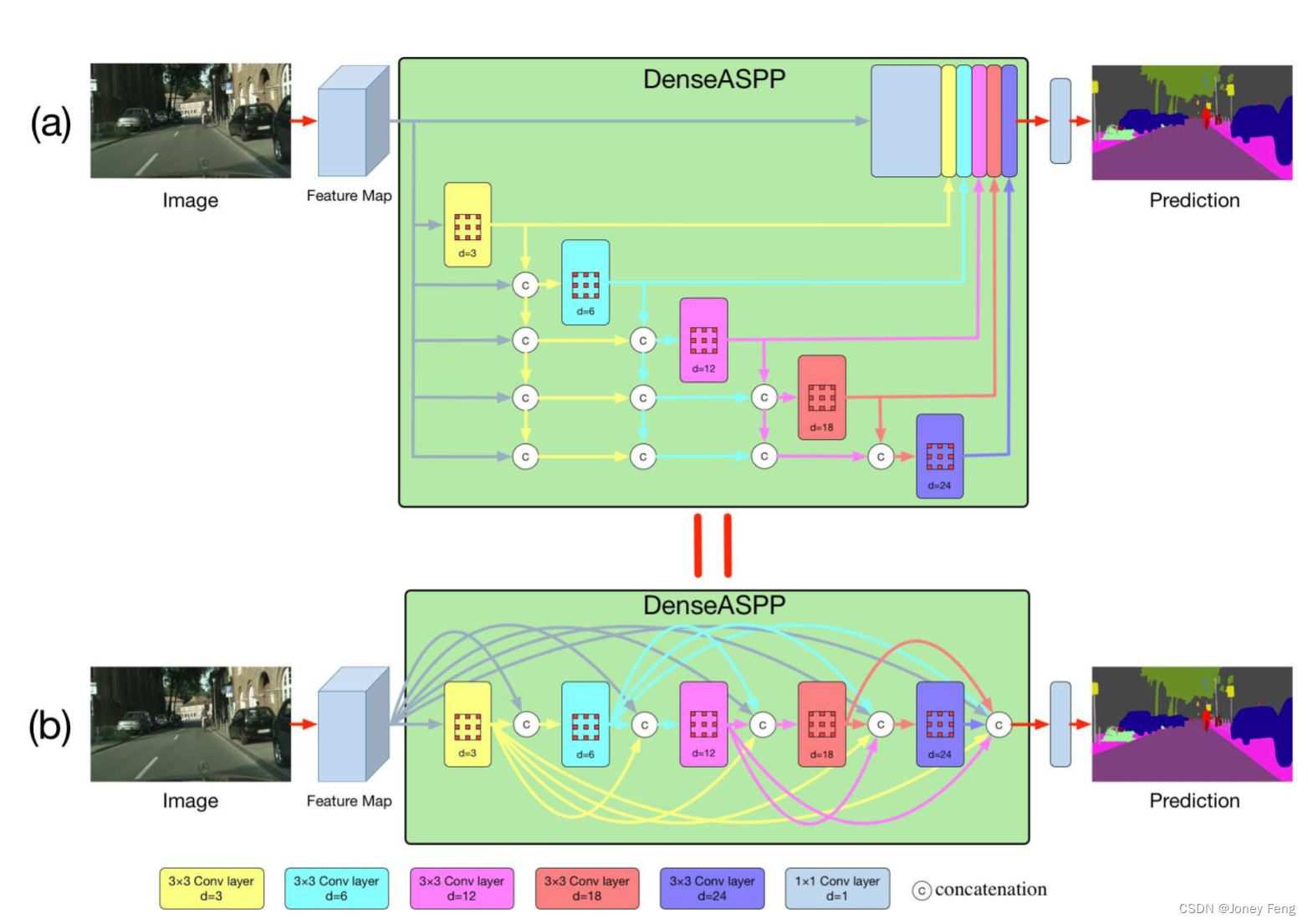

语义图像分割是自动驾驶中的基本街景理解任务,在这个任务中,高分辨率图像中的每个像素被归类为一组语义标签。与其他场景不同,自动驾驶场景中的物体呈现出非常大的尺度变化,这给高级特征表示带来了巨大挑战,因为必须正确地编码多尺度信息。为了解决这个问题,引入了扩张卷积[14],可以在不损失空间分辨率的情况下生成具有更大感受野的特征。基于扩张卷积,提出了扩张空间金字塔池化(ASPP)[2],将使用不同扩张率的

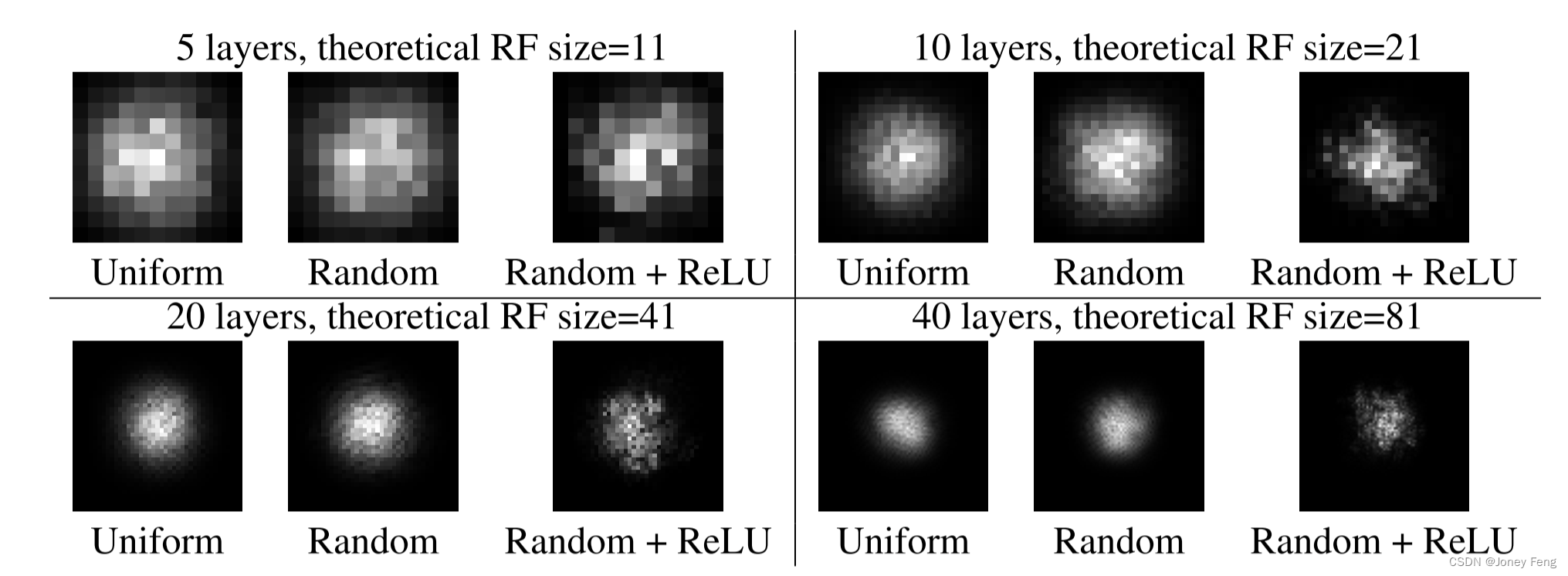

在本文中,我们仔细研究了深度CNN中的感受野,并建立了关于有效感受野大小的一些令人惊讶的结果。特别是,我们已经证明了感受野内的影响分布渐近地呈高斯分布,而有效感受野只占据了理论感受野的一部分。实证结果与我们建立的理论相吻合。我们相信这只是对有效感受野研究的一个开端,它提供了一种理解深度CNN的新角度。未来,我们希望进一步研究实践中影响有效感受野的因素,以及如何更好地对其进行控制。

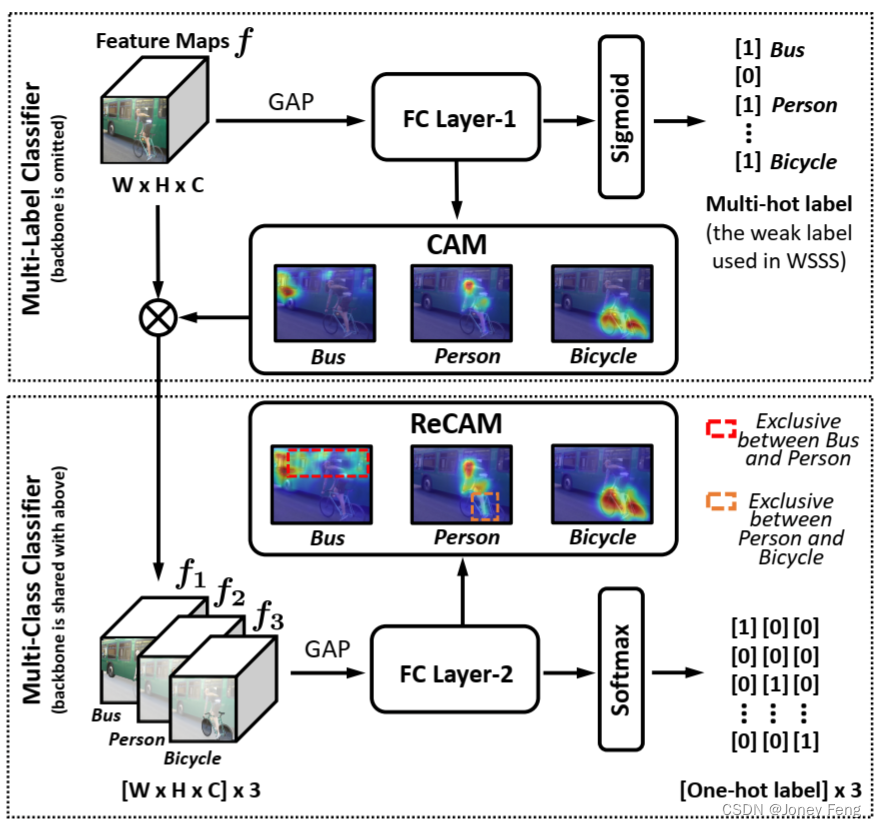

提取类别激活图(CAM)可以说是生成弱监督语义分割(WSSS)伪掩码的最常用步骤。然而,我们发现导致伪掩码不理想的关键在于广泛使用的二元交叉熵损失(BCE)在CAM中的应用。具体而言,由于BCE的类别求和池化特性,CAM中的每个像素可能对同一感受野中出现的多个类别都有响应。结果就是,对于给定的类别,其热点CAM像素可能错误地侵占了属于其他类别的区域,或者非热点像素实际上可能是该类别的一部分。为此,