简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

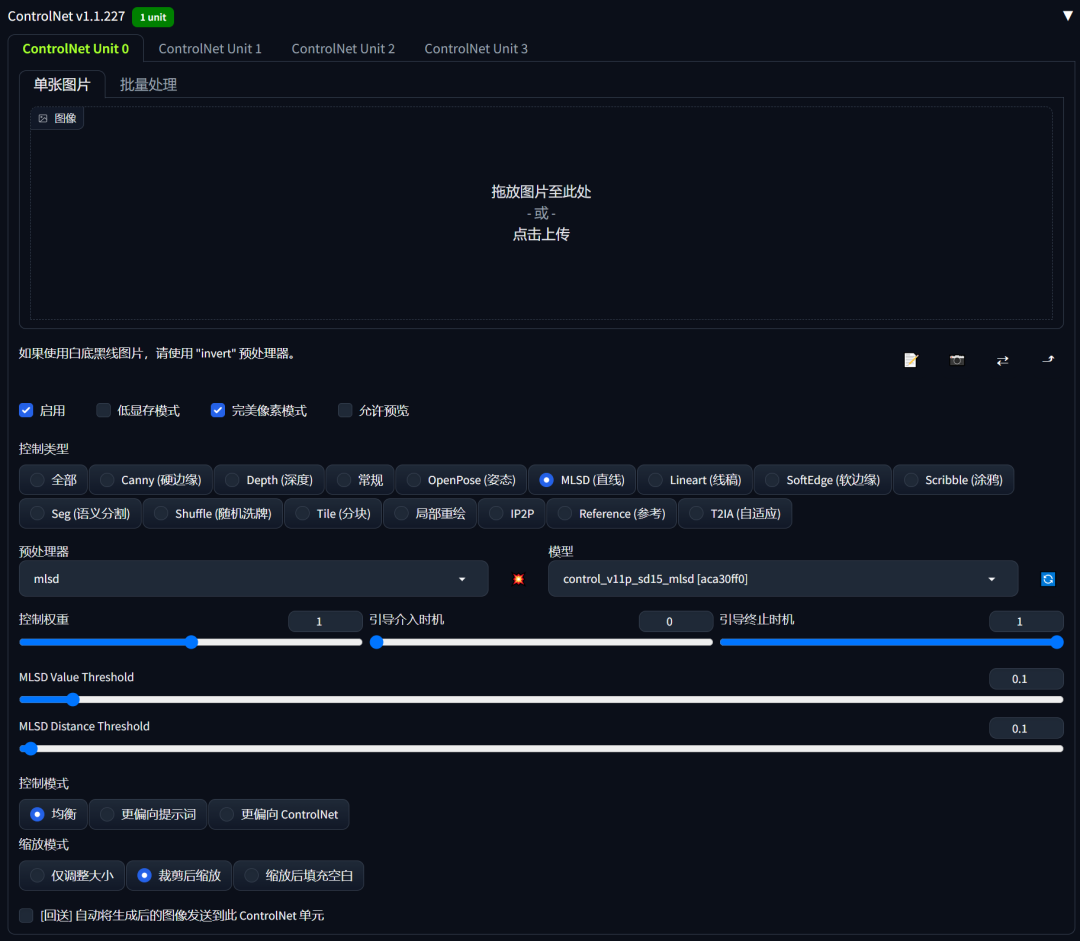

你是否已经厌倦了传统的室内设计方式,想探索新方法来增强作品设计感?本期小编就同大家分享一个新武器,用Stable Diffusion的ControlNet来打造一个室内设计全新工作流。无论你是经验丰富的室内设计师还是初学小白,都将使你的日常工作如虎添翼、告别爆肝,焕发出令甲方爸爸们赞叹的设计感。ControlNet将毛坯房照片转换为高清室内装饰效果图ControlNet是一种通过添加额外条件来控制

共同研发的的网安视频教程,内容涵盖了入门必备的操作系统、计算机网络和编程语言等初级知识,而且包含了中级的各种渗透技术,并且还有后期的CTF对抗、区块链安全等高阶技术。聚焦安全产品和工具的开发,比如防火墙、WAF、漏洞扫描工具等,核心技术栈包括 Python、C/C++、GoLang 等编程语言,以及内核开发、分布式架构等知识。技术层面,云原生、AI、物联网的普及催生了云安全、AI 攻防、工业控制系

FLUX.1 是由 Black Forest Labs 推出的文本到图像生成模型,已成为 AI 绘画领域的高品质模型。该模型由 Stability AI 的前核心成员开发,具备强大的生成能力和高质量的图像输出。Flux & AE 模型:https://huggingface.co/black-forest-labs/FLUX.1-devCLIP 模型:https://huggingface.co/

ComfyUI 现已支持 Stable Diffusion 3.5 Medium!人人都能轻松上手的图像生成利器大家翘首以盼的Stable Diffusion 3.5 Medium模型终于来了!就在今天,Stability AI 正式推出了这款“亲民版”平衡模型,让创作者们得以在消费级 GPU 上体验到AI图像生成的最新黑科技。本文将带你深入了解这个全新模型的优势和使用指南,让你轻松上手并创作出惊

在数字经济加速渗透的今天,数据已成为企业核心生产要素,但随之而来的是数据泄露、滥用等安全风险,以及日趋严格的监管合规要求。从《网络安全法》《数据安全法》《个人信息保护法》的全面实施,到2025年底国家网信办《网络数据安全风险评估办法(征求意见稿)》的发布,我国数据安全合规体系已进入“精细化监管”阶段。对于企业而言,数据安全不再是“可选项”,而是“生存底线”;合规也不再是“被动应付”,而是“主动驱动

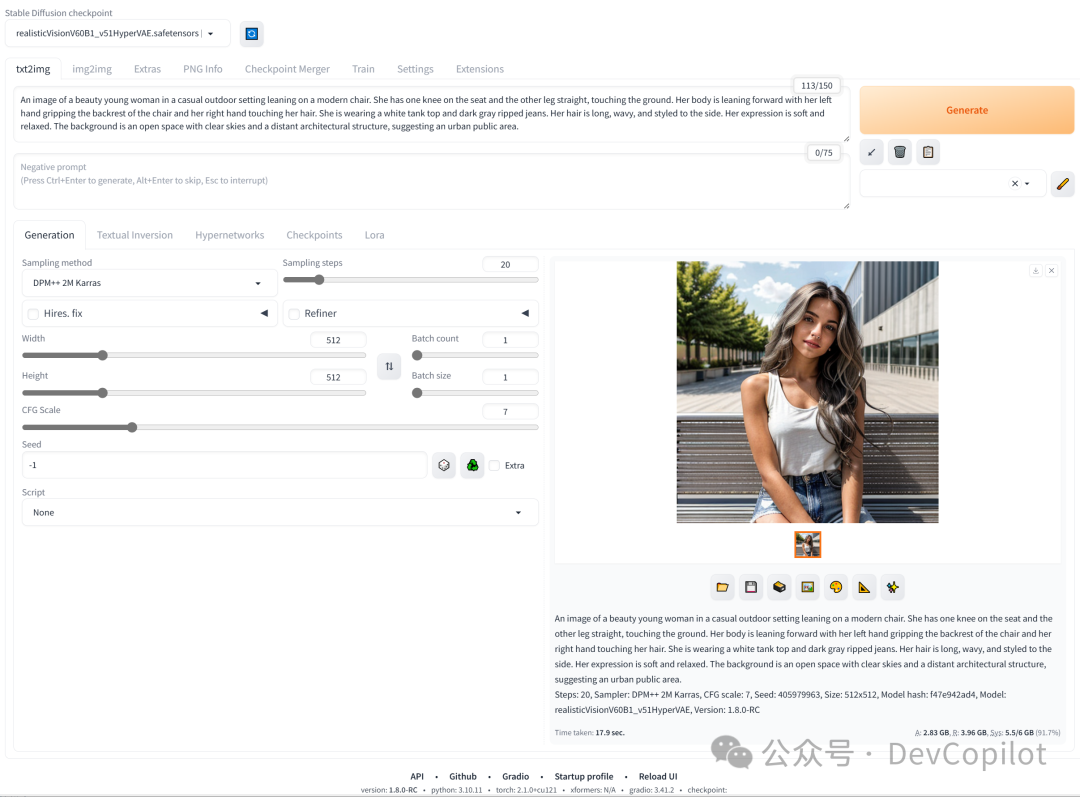

Stable Diffusion 是一种深度学习模型,用于生成高质量的图像。它基于一种名为扩散过程的生成方法,能够在给定条件的情况下生成具有丰富细节的图像。看看本文的搭建步骤,成功部署 Stable Diffusion 模型,文生图从此不求人,不用找各种代理和第三方付费的资源了。

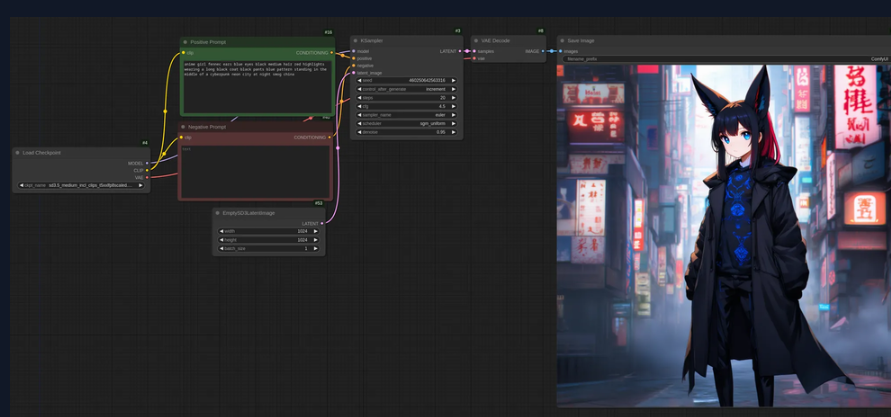

今天花时间试了试怎么用 ComfyUI,今天晚上就来介绍一下,怎么简单使用。上面是用 comfyUI 生成的视频。

ComfyUI作为一款基于Stable Diffusion的节点式操作界面,为用户提供了一个更加灵活和高效的文生图(文本生成图像)创作环境。本篇博客将详细介绍如何使用ComfyUI进行文生图操作,无论你是初学者还是有一定基础的用户,都能够通过本指南快速上手。书接上文,香型大家已经完成了Stablle Difution comfyui的安装。接下来我们通过流程、节点操作等方面。讲解如何利用comfy

初识ComfyUI的工作界面,是一个非常朴素的工作场景,它的工作区域被几个用不同颜色连接起来的功能组件占据,这些组件就是”节点“。按住鼠标左键可以对场景进行平移,滚动滑轮可以对场景进行缩放。下面我来一步一步学习如何用 ComfyUI进行AI绘画。一、我们先来回顾一下用 StableDiffusion webUI 进行AI绘图时的工作流程。1、首先选择一个风格模型,接着在提示词框内输出相应的提示词2

本文介绍了两种LORA模型训练方法,重点推荐朱尼酱的赛博丹炉工具。赛博丹炉1.4版本提供双语TAG编辑、自定义参数、分层训练等功能,支持二次元与真人图像处理。教程详细讲解了从模型准备、素材预处理到参数设置的完整流程,包括自动TAG反推、学习率调整等关键步骤。同时对比了秋叶启动器的训练方式,指出赛博丹炉在训练效果上的优势。最后提供了模型测试建议,推荐在不同训练阶段选取模型验证效果。全文以实际操作为例