简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

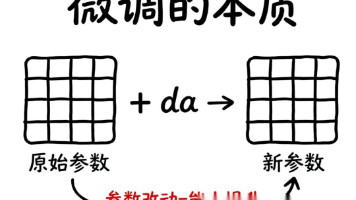

LoRA技术通过矩阵分解原理,将微调参数量减少96%以上,仅需学习两个小矩阵而非全部参数,大幅降低显存需求和训练成本。该方法既避免了灾难性遗忘,又保持了接近全量微调的效果,使个人开发者也能负担大模型微调。LoRA还具有可插拔优势,支持同一基础模型快速切换不同任务技能,是参数高效微调(PEFT)的重要技术之一。

本文介绍了当前主流的LLM推理框架及其适用场景:vLLM以高显存利用率和并发处理见长;SGLang凭借Radix树实现5倍吞吐提升;TensorRT-LLM提供NVIDIA硬件级优化;Ollama适合个人开发者轻量部署;XInference专注企业级分布式方案;LightLLM以轻量化设计适配边缘计算;LMDeploy则为国产芯片提供优化支持。文章还提供了大模型学习路径,涵盖系统设计、提示工程到行

文章盘点了AI大模型领域的10个热门高薪岗位,包括AI系统架构师、NLP专家、AI产品经理等,薪资范围从60万到200万不等。同时提供了系统学习AI大模型的资源,包括成长路线图、书籍、视频教程、项目实战和面试题等,帮助小白和程序员掌握大模型技术,抓住AI时代的职业发展机遇。

AI行业目前处于就业低谷期,但未来前景广阔。大模型相关岗位薪资普遍达40W+,远高于行业平均水平。作者分享全套AI学习资源,包括学习路线、报告合集、PDF书籍和商业化方案。入局大模型时代需持续学习实践,提升技能与认知,同时保持责任感和伦理意识,为AI健康发展贡献力量。

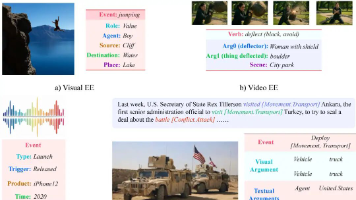

本文提出事件抽取在大模型时代应作为"认知脚手架"而非简单任务,通过结构约束、推理中介、图检索和智能体记忆四种能力,为LLM提供可靠中间表示和外部记忆。系统梳理了事件抽取的任务分类、方法演进、解码范式和应用场景,指出它正从静态预测任务演变为支持开放世界系统的结构化组件,为智能体提供感知与记忆层,增强系统可靠性、可推理性和长期记忆能力。

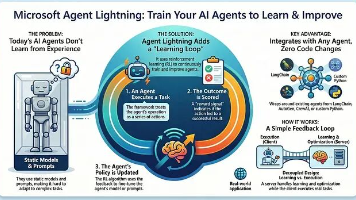

Agent Lightning是框架无关的强化学习包装层,赋予现有智能体在线学习能力。其核心特性包括框架无关性和执行训练解耦,由Runner、Trainer、LightningStore和VERL四个组件构成。该框架无需重构现有逻辑,通过统一接口接入训练流程,实现智能体持续优化。文章通过自修复SQL智能体项目演示完整训练流程,展示如何通过强化学习让智能体自动改进提示词和行为策略。

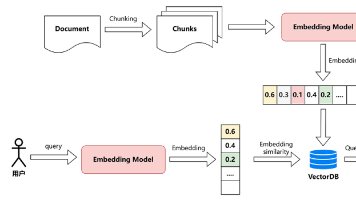

本文详解检索增强生成(RAG)技术,通过将大模型与外部知识库结合,解决知识过期、私有数据不可用等痛点。深入解析RAG与Embedding的协同原理,介绍索引、检索、生成三大核心流程,并通过Spring AI+智普AI实现本地知识库检索的完整案例,帮助开发者掌握无需微调即可扩展大模型能力的方法,为构建生产级RAG应用奠定基础。

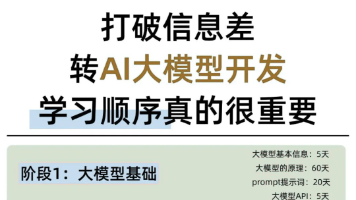

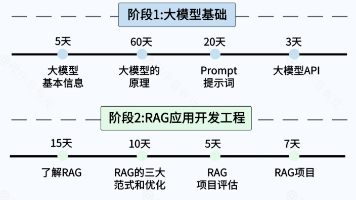

文章提供了AI大模型应用开发的四阶段学习路径:基础概念与Prompt、RAG应用开发、Agent架构设计、微调与私有化部署。针对后端开发者,强调转型AI应用开发无需重新学习数学基础,而是将现有工程思维迁移到AI领域,将大模型视为强大API,通过提示词工程和业务逻辑组织实现功能。提供丰富学习资源,帮助读者系统入门并掌握AI应用开发核心技能。

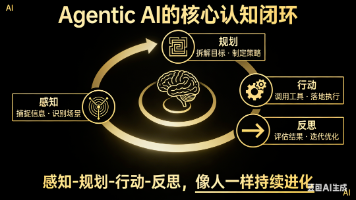

文章解析了Agentic AI的"感知-规划-行动-反思"核心认知闭环。感知环节构建情境理解,规划环节制定行动方案,行动环节落地创造价值,反思环节评估学习实现自我迭代。这四个环节形成动态循环系统,使智能体不仅能完成任务,还能在执行中持续进化,实现"越做越好"的智能成长。

本文详细介绍了程序员转型大模型应用开发的四阶段学习路径:大模型基础、RAG应用开发、Agent应用架构及微调与私有化部署。文章指出,随着阿里云、字节跳动等企业全面布局AI,大模型应用开发岗位将迎来爆发式增长,程序员掌握正确学习顺序对成功转型至关重要,并提供了配套学习资源供免费领取。