简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

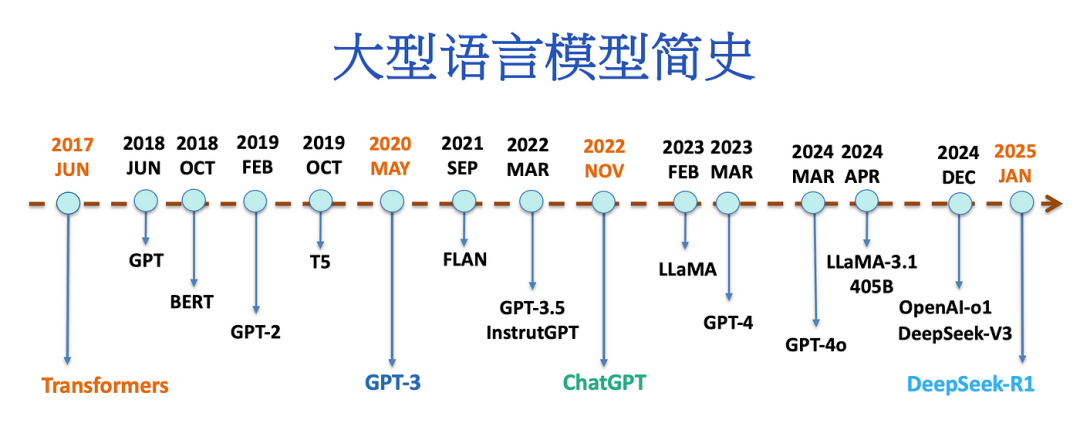

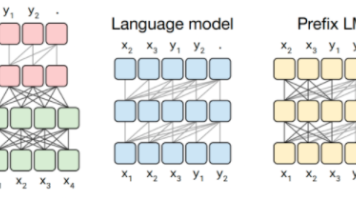

语言模型」是一种「人工智能系统」,旨在处理、理解和生成类似人类的语言。它们从大型数据集中学习模式和结构,使得能够产生连贯且上下文相关的文本,应用于翻译、摘要、聊天机器人和内容生成等领域。

DeepSeek系列模型包括R1(数学、代码及推理领域开源大模型,回答全面详实)、V3(自研MoE模型,性能顶尖且性价比极高)、VL(视觉与语言理解开源多模态模型)、V2(创新架构,推理成本低廉)、R1-Zero(强化学习预模型,独特优势)、以及蒸馏版Qwen和Llama小模型(从R1数据蒸馏,表现优异)。DeepSeek-R1的技术创新在于开发了GRPO算法以优化策略网络,避免了高计算开销,同时

比如我们假设某个任务 T 有 5 个子任务 Sub-T 构成,每个 sub-T 随着模型增长,指标从 40% 提升到 60%,但是最终任务的指标只从 1.1% 提升到了 7%,也就是说宏观上看到了涌现现象,但是子任务效果其实是平滑增长的。优点:相比于 Post-LN,Pre-LN 在深层的梯度范式近似相等,所以使用 Pre-LN 的深层 transformer 训练更稳定,可以缓解训练不稳定问题。

举个例子,看这张图。看这张图,向前传播时,由于 s 是多个 z 共同决定的,所以需要求出 s 对所有 z 的导数,以 s1 为例,前向传播求梯度的时候,需要求出 s1 对 z1,z2,z3…这是阿里的一份大模型算法面经,可以看到,面试官避开了 rag,agent 这些热门考点,转而对大模型训练中的损失函数进行了深挖,很好的考察到了候选人的基本功。所以我们最后求偏导的时候,需要计算 i=j 和 i≠

是不是每次找资料都像在“垃圾场”淘宝,翻得手忙脚乱还一无所获?别担心,今天我教你用DeepSeek和Cherry Studio打造专属知识库,小白也能秒变资料管理大师!

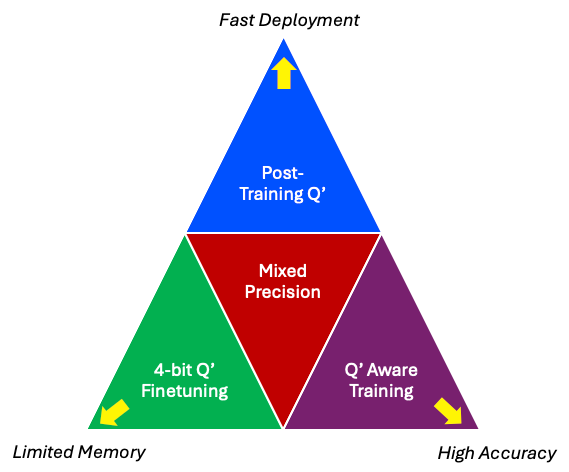

在大模型时代,量化技术已经成为AI工程师的必备技能,就像摄影师必须掌握光线调节一样重要。量化技术全景图技术适用场景优势代价训练后量化(PTQ)快速原型开发 临时部署即时生效 零训练成本精度损失较大量化感知训练(QAT)高精度需求 医疗/金融场景保持95%+原模型精度需要重新训练4位量化微调边缘设备 移动端应用75%内存节省 QLoRA恢复性能微调数据依赖混合精度异构计算平台 实时系统智能资源分配

是时候准备春招和实习了。节前,我们邀请了一些互联网大厂朋友、今年参加社招和校招面试的同学。针对新手如何入门算法岗、该如何准备面试攻略、面试常考点、大模型技术趋势、算法项目落地经验分享等热门话题进行了深入的讨论。面试公司:腾讯岗位:大模型算法。

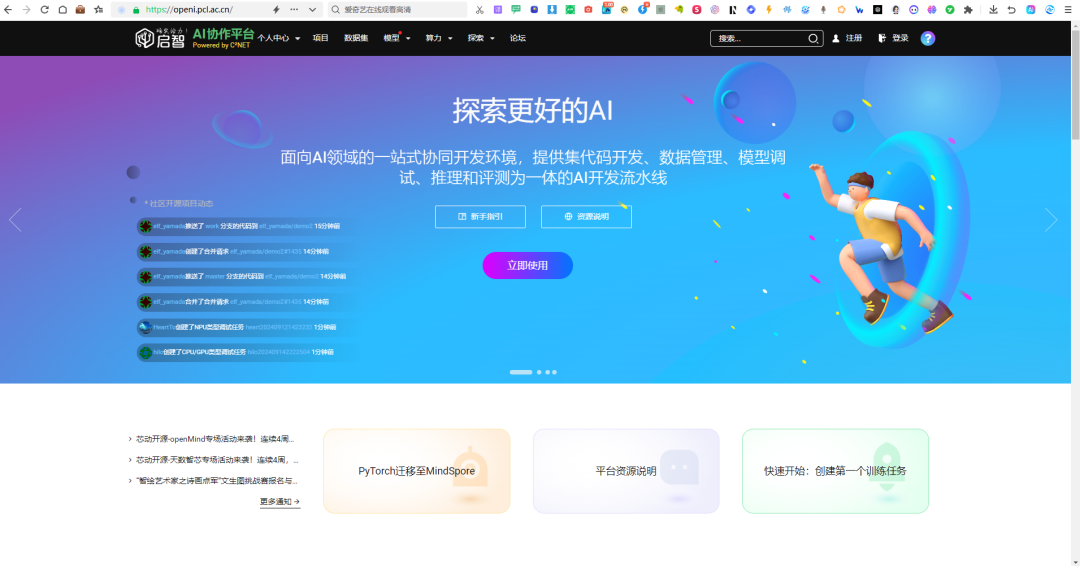

考虑到 LMDeploy 并不是每个模型都是支持的,我们在官方的列表中找到支持的模型 https://lmdeploy.readthedocs.io/en/latest/supported_models/supported_models.html。好在启智平台提供了昇腾NPU 运行环境,不过这里我们需要注意:虽然启智平台提供了昇腾 NPU 运行环境,但是 不是每个镜像都能很顺利地跑完,我花了些时间

针对新手如何入门算法岗、该如何准备面试攻略、面试常考点、大模型技术趋势、算法项目落地经验分享等热门话题进行了深入的讨论。节前,我们邀请了一些互联网大厂朋友、今年参加社招和校招面试的同学。是时候准备春招和实习了。

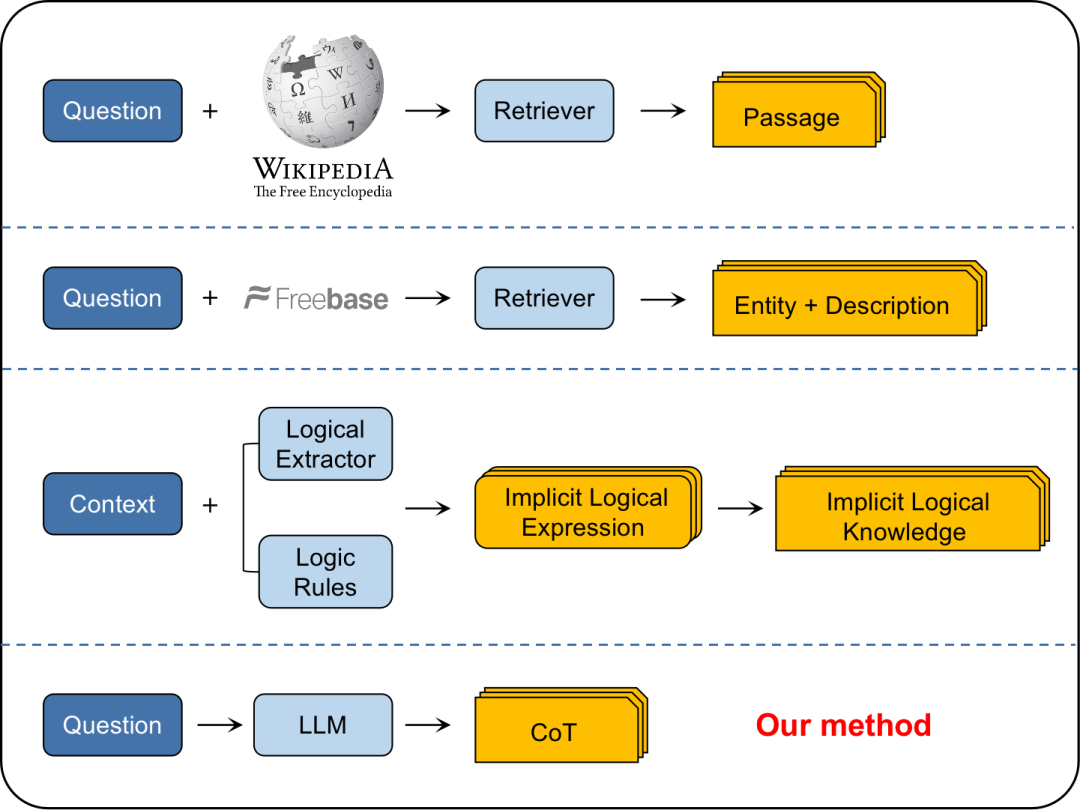

在这种方法中,基本提示指令通过添加医学术语定义得以增强,基于这样一种假设,即添加这些定义将帮助LLM在回答查询时获得更多上下文。但结果显示,这些术语定义并没有真正起作用,可能是因为它们的知识范围狭窄,可能与LLM的更大知识库相冲突。