GLM-4.6大模型评测:代码能力提升30%,上下文达200K,国产芯片适配新突破!

智谱发布GLM-4.6大模型,代码能力与Claude Sonnet 4基本对齐,上下文长度提升至200K,实现国产芯片适配。GLM-4.6在编程场景表现优异,Token消耗减少30%,成本更低,且可在Claude Code等工具中直接替换使用。虽然与国际顶尖模型仍有差距,但国内厂商迭代速度加快,差距逐渐缩小,为开发者提供了高性价比的编程选择。

简介

智谱发布GLM-4.6大模型,代码能力与Claude Sonnet 4基本对齐,上下文长度提升至200K,实现国产芯片适配。GLM-4.6在编程场景表现优异,Token消耗减少30%,成本更低,且可在Claude Code等工具中直接替换使用。虽然与国际顶尖模型仍有差距,但国内厂商迭代速度加快,差距逐渐缩小,为开发者提供了高性价比的编程选择。

本来昨儿都计划好今天一早趁着人少,开车回老家。没想到,从晚上 6 点多开始,AI 圈子里的重磅新闻就不断,我给大家梳理下:

1、DeepSeek-V3.2-Exp 发布。

它最大的亮点是引入了全新的稀疏注意力机制,大幅压缩了推理成本。也因此,DeepSeek 的输出价格直接下调了 75%。

2、Anthropic 发布 Claude Sonnet 4.5,重点仍然是 Coding 场景。

相比 Opus 4.1,它明显更快,更便宜。官方表示,在实际的任务中,4.5 最长可以运行 30 小时。

3、智谱发布 GLM-4.6,代码能力对齐 Claude Sonnet 4,并且把上下文长度提升到了 200K。

并且,GLM-4.6 已经国产芯片上实现 FP8+Int4 混合量化部署,这也是一个重要的里程碑。

有种时代浩浩荡荡的感觉。Anthropic 离上次发布模型,也才两个月时间,大家的节奏越来越快。而且国内的模型追得也很紧,没有任何一个模型能够持续领先。

DeepSeek 今年过年时凭借 R1 一鸣惊人,然后智谱我觉得从 GLM-4.5 开始,也已经越过山丘。

从最近他们的发布策略来看,我感觉智谱的模型应该是奔着 Anthropic 方向去了,把重心瞄向 Coding 场景。

至少从 Token 的使用量上看, GLM-4.5 已经是国内第一大 Coding 模型了。

上个月,Claude 断供之后,我身边很多工程师都开始用 GLM-4.5 平替。

GLM 在 API 层面做了兼容,像在 Claude Code 里,只需要几行简单的命令,就能把 Claude 的 API 替换为 GLM。

实际用下来,大家普遍觉得 GLM 还挺给力的,在 Coding 里至少能顶上 Claude 的九成功力。

更关键的是,便宜。Claude 虽然最近降了点价,但之前真是贵得离谱。

很多工程师跟我说,反正写代码不是一锤子买卖,天天都要跑。

Claude 用起来心里肉疼,GLM 就踏实多了,用起来没什么心理负担。久而久之,大家自然也就切过去了。

这次 GLM-4.6,真的是够拼。不知道是巧合,还是故意瞄着打,反正 Claude 4.5 一出来,GLM 马上跟上。

我觉得也没必要吹嘘说国产模型有多么厉害,和 Claude 最新的旗舰版本肯定还有差距,人家能一口气跑 30 小时的复杂任务,这个 OpenAI 也做不到。

但说回来,这次 GLM-4.6 也有很多重要的突破:

第一,代码能力确实往前走了一步。GLM-4.6 在一系列权威基准上和 Sonnet 4 基本对齐,更关键的是在真实场景下的表现。

根据官方针对七十多个编程场景的测试结果,GLM-4.6 已经能够胜任日常开发中复杂的 Coding 任务。

第二,上下文长度提升到 200K,这个也追平了 Claude 4 的水准。

200K tokens 大约相当于 15 万个英文单词,意味着整个仓库(尤其是中小型项目)可以一次性加载进去,模型能同时掌握全局逻辑和局部细节。期待 GLM 下次能跨入 1M 时代。

第三,和国产芯片的适配是一个信号。GLM-4.6 已经在寒武纪芯片上完成了 FP8+Int4 的部署,这说明国产芯片在大模型推理上的可行性正在被验证。

与此同时,GLM-4.6 也能在摩尔线程的新一代 GPU 上稳定运行 FP8 精度。

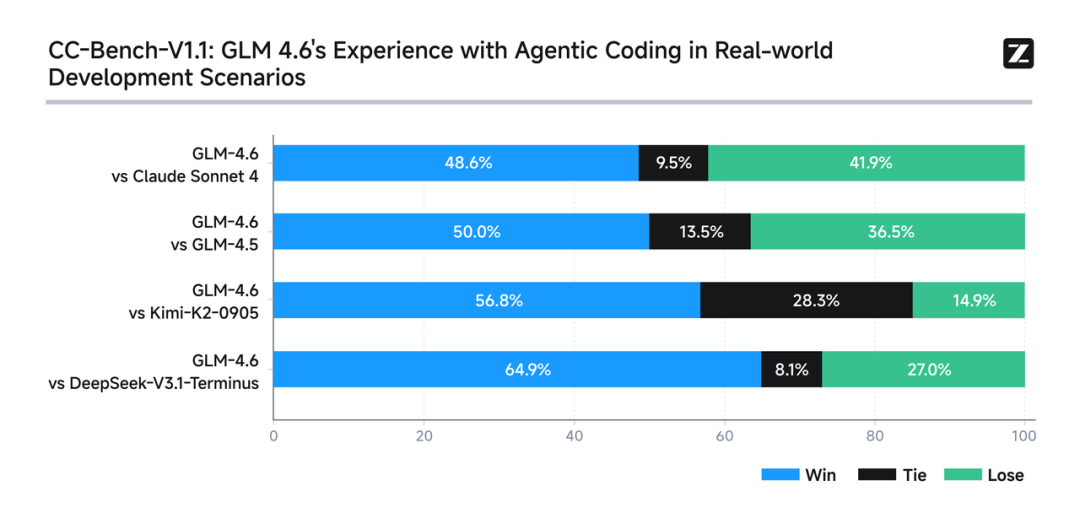

下面这张图是智谱自己的 BenchMark 数据。在真实的研发场景中,GLM 4.6 的表现也比较扎实。

考虑到大家可能关心评测的真实性,智谱已经把完整的测试题和轨迹公开在 Hugging Face,任何人都可以下载复现,自己验证结果。

https://huggingface.co/datasets/zai-org/CC-Bench-trajectories

GLM-4.6 还有一个值得注意的细节:在平均 Token 消耗上,比 GLM-4.5 少了 30% 以上,在同类模型里也算比较低的。

任务完成质量相近的情况下,Token 更少,就代表同样的问题能用更短的时间和更少的开销完成。

对企业来说,调用次数动辄成千上万,30% 的差距累积起来就是一笔实实在在的成本。

并且,Token 也直接关系到速度。消耗更少,推理过程就更快,延迟更低。在复杂的编程任务里,这种差别会让使用体验完全不同。

从实际测试看,GLM-4.6 的回答比 4.5 更紧凑,少了一些冗余解释,更快切入问题本身。这大概也是 Token 消耗下降的原因。

AI大模型学习和面试资源

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献88条内容

已为社区贡献88条内容

所有评论(0)