【强化学习】PPO算法原理及其Python实现

PPO(近端策略优化)算法是强化学习领域的重要突破,通过引入裁剪代理目标函数和重要性采样机制,有效解决了传统策略梯度方法训练不稳定和样本利用率低的问题。本文系统介绍了PPO算法的核心原理、数学基础、实现流程及Python代码示例,并分析了其在游戏AI、机器人控制和自然语言处理等领域的典型应用。文章还探讨了PPO算法的局限性及改进方向,如动态调整裁剪范围、解耦策略更新等前沿优化方法,展望了其在离线学

目录

一、PPO 算法的基本概念

在人工智能的广阔领域中,强化学习作为一个重要的分支,正逐渐崭露头角,被广泛应用于机器人控制、自动驾驶、游戏 AI 等多个领域。简单来说,强化学习是一种让智能体(Agent)通过与环境进行交互,不断试错并学习最优行为策略的机器学习方法。它就像是一个探索者在未知的世界中摸索,通过不断尝试不同的行动,根据环境给予的奖励或惩罚反馈,逐渐学会如何做出最优决策 ,以最大化长期累积奖励。

举个简单的例子,假设你训练一个机器人玩游戏,机器人就是智能体,游戏环境就是它所处的世界。机器人在游戏中会不断尝试各种操作(即动作),比如前进、跳跃、攻击等,每做出一个动作,游戏环境会根据这个动作的结果给予机器人相应的奖励(比如得分增加)或惩罚(比如生命值减少)。机器人通过不断地与游戏环境交互,学习到哪些操作能够带来更多的奖励,从而逐渐掌握游戏的最优策略,成为游戏高手。

而近端策略优化(Proximal Policy Optimization,PPO)算法,正是强化学习领域中一颗耀眼的明星,它由 OpenAI 于 2017 年提出,旨在解决传统策略梯度方法中训练不稳定、样本利用率低等问题。PPO 算法通过巧妙的设计,在保证策略更新稳定性的同时,显著提高了训练效率,使得智能体能够更快、更有效地学习到最优策略,在实际应用中展现出了强大的优势和潜力。接下来,让我们深入探索 PPO 算法的核心原理和实现细节。

二、PPO 算法的核心原理

(一)背景与问题引出

在 PPO 算法诞生之前,传统的策略梯度方法在强化学习中占据着重要地位。这些方法通过直接计算策略的梯度来更新策略参数,以最大化累积奖励。然而,传统策略梯度方法存在一些显著的弊端 ,严重限制了其在实际应用中的效果和效率。

其中一个主要问题是对更新步长非常敏感。更新步长过大时,策略参数可能会发生剧烈变化,导致策略崩溃,智能体的性能急剧下降;而更新步长过小时,算法的收敛速度会变得极为缓慢,需要大量的训练时间和样本才能达到较好的效果 。这就好比你在驾驶一辆汽车,方向盘转动的角度过大,汽车可能会失控;而转动角度过小,又难以快速到达目的地。

另一个突出问题是样本利用率低。传统策略梯度方法通常需要与环境进行大量的交互,采集大量的样本数据来估计策略梯度。而且,这些方法往往只能使用最新采集到的样本数据进行一次策略更新,之后这些数据就被丢弃,无法再次利用,这无疑是对宝贵样本资源的极大浪费。在复杂的实际应用场景中,获取样本数据往往需要耗费大量的时间、计算资源和成本,样本利用率低的问题严重制约了传统策略梯度方法的应用范围和效果。

为了解决这些问题,研究人员不断探索和创新,PPO 算法应运而生。它旨在克服传统策略梯度方法的局限性,通过一系列巧妙的设计,实现更加稳定、高效的策略优化。

(二)核心设计思想

PPO 算法的核心设计思想围绕着几个关键的概念,这些概念相互配合,有效地解决了传统算法的痛点。

首先是 Clipped Surrogate Objective(裁剪代理目标函数)。PPO 通过引入这个特殊的目标函数,限制了策略更新的幅度,确保新策略与旧策略之间的差异在一个可控的范围内。具体来说,它通过对新旧策略的概率比进行裁剪操作,将其限制在一个预设的区间内,防止策略发生突变。这种方式就像是给策略更新加上了一个 “安全带”,使得策略的更新更加平稳和安全,避免了因策略更新过大而导致的训练不稳定问题。

重要性采样(Importance Sampling)也是 PPO 算法的一个重要思想。通过重要性采样,PPO 能够复用旧策略采集的数据,而不仅仅依赖于新策略实时采集的数据。这大大提高了样本的利用率,使得算法可以在有限的样本数据上进行更有效的学习。简单来说,重要性采样允许我们使用旧策略生成的数据来训练新策略,就好像我们可以从过去的经验中不断学习和改进,而不必每次都从头开始收集新的经验。

此外,PPO 算法还采用了自适应惩罚项的设计,来替代传统算法中复杂的约束优化过程,从而降低了计算成本,提高了算法的效率和实用性。

(三)数学原理与目标函数

- 策略梯度基础

策略梯度方法的目标是最大化累积奖励的期望,其目标函数可以表示为:\( J(\theta) = \mathbb{E}_{\tau \sim \pi_{\theta}} \left[ \sum_{t=0}^{\infty} \gamma^t r_t \right] \)

其中,\( \theta \) 是策略 \( \pi_{\theta} \) 的参数,\( \tau \) 是从策略 \( \pi_{\theta} \) 生成的一条轨迹,\( \gamma \) 是折扣因子,用于衡量未来奖励的当前价值,\( r_t \) 是在时间步 \( t \) 获得的奖励。

为了计算策略梯度,我们引入优势函数 \( A(s,a) \),它衡量了在状态 \( s \) 下采取动作 \( a \) 相对于平均动作价值的优势,即:\( A(s,a) = Q(s,a) - V(s) \)

其中,\( Q(s,a) \) 是状态 - 动作值函数,表示在状态 \( s \) 下采取动作 \( a \) 后获得的累积奖励的期望;\( V(s) \) 是状态值函数,表示在状态 \( s \) 下遵循当前策略所能获得的累积奖励的期望。优势函数的作用是帮助我们更准确地评估每个动作的相对价值,从而指导策略的更新。

- PPO 目标函数

PPO 的目标函数引入了重要性采样比 \( r_t(\theta) \),它定义为新策略 \( \pi_{\theta}(a_t|s_t) \) 与旧策略 \( \pi_{\theta_{old}}(a_t|s_t) \) 在状态 \( s_t \) 下选择动作 \( a_t \) 的概率比值,即:\( r_t(\theta) = \frac{\pi_{\theta}(a_t|s_t)}{\pi_{\theta_{old}}(a_t|s_t)} \)

PPO 通过 Clip 机制来限制策略的更新幅度,具体做法是将重要性采样比 \( r_t(\theta) \) 限制在区间 \( [1 - \epsilon, 1 + \epsilon] \) 内(通常 \( \epsilon = 0.2 \) )。这样,PPO 的目标函数可以表示为:\( L^{CLIP}(\theta) = \mathbb{E}_t \left[ \min \left( r_t(\theta) A_t, \text{clip}(r_t(\theta),1 - \epsilon, 1 + \epsilon) A_t \right) \right] \)

其中,\( A_t \) 是优势函数的估计值。这个目标函数实际上包含了两个部分:\( r_t(\theta) A_t \) 和 \( \text{clip}(r_t(\theta),1 - \epsilon, 1 + \epsilon) A_t \),并取两者的最小值。这种双重目标的设计确保了优化方向的保守性,避免新策略过度偏离旧策略,从而保证了训练的稳定性。

- 优势估计技术

在 PPO 算法中,常用广义优势估计(Generalized Advantage Estimation,GAE)来计算优势值。GAE 的计算公式如下:\( A_t^{GAE(\gamma, \lambda)} = \sum_{l=0}^{\infty} (\gamma \lambda)^l \delta_{t + l} \)

其中,\( \delta_{t + l} = r_{t + l} + \gamma V(s_{t + l + 1}) - V(s_{t + l}) \) 是 TD 误差项,\( \gamma \) 是折扣因子,\( \lambda \) 是一个超参数,用于控制偏差 - 方差的权衡。

\( \lambda \) 的取值对 GAE 的性能有着重要影响。当 \( \lambda \) 接近 0 时,GAE 更倾向于使用短期的 TD 误差来估计优势,此时偏差较大,但方差较小;当 \( \lambda \) 接近 1 时,GAE 会更多地考虑长期的回报信息,偏差较小,但方差较大。通过调整 \( \lambda \) 的值,我们可以在偏差和方差之间找到一个合适的平衡点,从而提高优势估计的准确性,进而提升 PPO 算法的性能。

三、PPO 算法流程

(一)伪代码解析

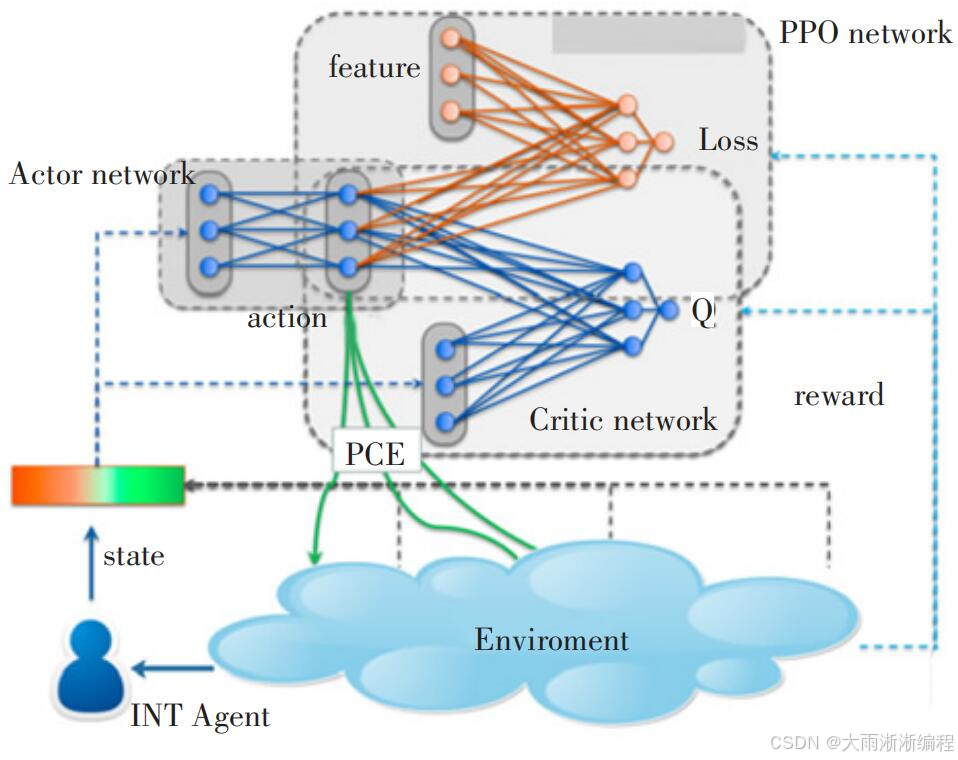

PPO 算法通常基于 Actor - Critic 架构实现,下面是其伪代码形式:

# 初始化策略网络 π_θ 和价值网络 V_φ

# 设定超参数:折扣因子 γ,优势估计参数 λ,裁剪参数 ϵ,优化步数 K,批量大小 batch_size

for epoch in range(num_epochs):

# 1. 收集数据

for t in range(T):

# 使用当前策略 π_θ_old 与环境交互

s_t = env.get_state() # 获取当前环境状态

a_t, log_prob_t = π_θ_old(s_t) # 根据策略选择动作及计算对数概率

r_t, s_t_plus_1, done = env.step(a_t) # 执行动作,获取奖励、下一状态及是否结束

# 存储数据

store(s_t, a_t, r_t, log_prob_t, s_t_plus_1, done)

if done:

break

# 2. 计算优势与回报

# 计算每个时间步的优势值 A_t 和回报 G_t

advantages = calculate_advantages(rewards, values, γ, λ)

returns = advantages + values

# 3. 优化策略

for k in range(K):

# 随机采样一个 batch 数据

batch = sample_batch(data, batch_size)

s_batch, a_batch, old_log_prob_batch, adv_batch, ret_batch = batch

# 计算重要性采样比

log_prob_new_batch = π_θ.log_prob(s_batch, a_batch)

r_t = torch.exp(log_prob_new_batch - old_log_prob_batch)

# 计算 clipped 目标函数

surr1 = r_t * adv_batch

surr2 = torch.clamp(r_t, 1 - ϵ, 1 + ϵ) * adv_batch

J_CLIP = -torch.min(surr1, surr2).mean()

# 更新策略网络参数 θ 以最大化 J^CLIP

optimizer_actor.zero_grad()

J_CLIP.backward()

optimizer_actor.step()

# 更新价值网络参数 φ 以最小化 (V_φ(s_t) - G_t)^2

values_pred = V_φ(s_batch)

value_loss = torch.nn.functional.mse_loss(values_pred, ret_batch)

optimizer_critic.zero_grad()

value_loss.backward()

optimizer_critic.step()

- 初始化部分:首先初始化策略网络 \( \pi_{\theta} \) 和价值网络 \( V_{\varphi} \),它们通常是神经网络。同时设定一系列超参数,如折扣因子 \( \gamma \) 用于衡量未来奖励的现值,优势估计参数 \( \lambda \) 控制偏差 - 方差权衡,裁剪参数 \( \epsilon \) 限制策略更新幅度,优化步数 \( K \) 决定每次收集数据后进行参数更新的次数,批量大小 \( batch\_size \) 表示每次随机采样用于参数更新的数据量。

- 数据收集循环:在每个训练周期 \( epoch \) 内,智能体使用当前策略 \( \pi_{\theta_{old}} \) 与环境进行交互。在每一步 \( t \) 中,智能体获取当前环境状态 \( s_t \),根据策略选择动作 \( a_t \) 并计算该动作的对数概率 \( log\_prob_t \),执行动作后从环境中获得奖励 \( r_t \)、下一状态 \( s_{t+1} \) 以及是否到达终止状态的标志 \( done \)。将这些数据存储起来,用于后续的计算。如果到达终止状态,则结束当前周期的数据收集。

- 优势与回报计算:根据收集到的奖励 \( rewards \) 和价值网络预测的状态值 \( values \),使用广义优势估计(GAE)方法计算优势值 \( advantages \),公式为 \( A_t^{GAE(\gamma, \lambda)} = \sum_{l=0}^{\infty} (\gamma \lambda)^l \delta_{t + l} \),其中 \( \delta_{t + l} = r_{t + l} + \gamma V(s_{t + l + 1}) - V(s_{t + l}) \) 是 TD 误差项。回报 \( returns \) 则通过优势值加上状态值得到,即 \( returns = advantages + values \)。

- 优化策略循环:在每个优化步骤 \( k \) 中,从存储的数据中随机采样一个批量的数据 \( batch \)。根据新策略 \( \pi_{\theta} \) 计算采样数据中动作的对数概率 \( log\_prob\_new\_batch \),进而计算重要性采样比 \( r_t \)。通过重要性采样比和优势值计算裁剪后的目标函数 \( J^{CLIP} \),它由两个部分 \( surr1 \) 和 \( surr2 \) 的最小值组成,用于限制策略更新的幅度,防止策略变化过大。通过反向传播和优化器(如 Adam 优化器)更新策略网络的参数 \( \theta \),以最大化裁剪后的目标函数 \( J^{CLIP} \)。同时,计算价值网络预测值 \( values\_pred \) 与实际回报 \( ret\_batch \) 之间的均方误差损失 \( value\_loss \),通过反向传播和优化器更新价值网络的参数 \( \varphi \),以最小化价值损失。

(二)具体步骤说明

- 收集数据

-

- 策略执行:智能体使用当前策略 \( \pi_{\theta_{old}} \) 与环境进行交互。在每个时间步 \( t \),智能体根据当前环境状态 \( s_t \),通过策略网络 \( \pi_{\theta_{old}} \) 输出的动作概率分布,采用某种采样方法(如对于离散动作空间,可根据概率分布进行随机抽样;对于连续动作空间,可通过策略网络输出的均值和标准差,从正态分布中采样)选择动作 \( a_t \)。

-

- 数据记录:执行动作 \( a_t \) 后,环境返回奖励 \( r_t \)、下一状态 \( s_{t + 1} \) 以及一个表示是否到达终止状态的标志 \( done \)。同时,记录下当前动作 \( a_t \) 在策略 \( \pi_{\theta_{old}} \) 下的对数概率 \( log\_prob_t \)。将这些数据 \( (s_t, a_t, r_t, log\_prob_t, s_{t + 1}, done) \) 存储起来,形成一条经验轨迹。这个过程不断重复,直到满足某个停止条件(例如达到最大时间步数 \( T \) 或者环境进入终止状态),收集到足够多的经验数据用于后续的计算和策略更新。例如,在一个机器人行走的任务中,机器人每走一步,就记录下当前的位置、姿态(状态 \( s_t \)),执行的动作(如腿部关节的角度变化 \( a_t \)),获得的奖励(如行走的距离奖励 \( r_t \)),动作的对数概率 \( log\_prob_t \),以及下一步的位置、姿态(状态 \( s_{t + 1} \)),如果机器人摔倒或者达到目标位置,就标记为终止状态 \( done = True \)。

- 计算优势与回报

-

- 优势计算:使用广义优势估计(GAE)来计算每个时间步的优势值 \( A_t \)。GAE 综合考虑了当前步的奖励和未来状态的价值估计,能够更准确地评估一个动作的优劣。首先计算 TD 误差 \( \delta_t = r_t + \gamma V(s_{t + 1}) - V(s_t) \),其中 \( V(s_t) \) 和 \( V(s_{t + 1}) \) 分别是状态 \( s_t \) 和 \( s_{t + 1} \) 的价值估计,由价值网络 \( V_{\varphi} \) 输出。然后,优势值 \( A_t \) 通过对 TD 误差进行加权求和得到,即 \( A_t^{GAE(\gamma, \lambda)} = \sum_{l = 0}^{\infty} (\gamma \lambda)^l \delta_{t + l} \)。当 \( \lambda \) 取值较小时,优势估计更依赖于当前步和近几步的 TD 误差,偏差较大但方差较小;当 \( \lambda \) 取值较大时,优势估计会考虑更长远的未来信息,偏差较小但方差较大。通过调整 \( \lambda \) 的值,可以在偏差和方差之间找到合适的平衡,使优势估计更准确。

-

- 回报计算:回报 \( G_t \) 表示从时间步 \( t \) 开始到未来所有时间步获得的累积奖励。可以通过优势值和状态值来计算,即 \( G_t = A_t + V(s_t) \)。另一种常见的计算方法是直接从后往前累加奖励, \( G_t = r_t + \gamma r_{t + 1} + \gamma^2 r_{t + 2} + \cdots + \gamma^{T - t} r_T \),其中 \( T \) 是终止状态的时间步。在实际计算中,由于未来的奖励是不确定的,通常会在到达终止状态或者达到一定的时间范围后停止累加,并使用价值网络对剩余的未来奖励进行估计。例如,在一个游戏任务中,智能体在某一时刻获得的奖励是 10 分,下一时刻的状态价值估计为 50 分,折扣因子 \( \gamma = 0.9 \),TD 误差 \( \delta = 10 + 0.9\times50 - V(s_t) \),通过 GAE 计算出优势值 \( A_t \) 后,回报 \( G_t = A_t + V(s_t) \)。

- 优化策略

-

- 数据采样:从收集到的经验数据中随机采样一个批量的数据 \( batch \),每个批量包含状态 \( s\_batch \)、动作 \( a\_batch \)、旧策略下动作的对数概率 \( old\_log\_prob\_batch \)、优势值 \( adv\_batch \) 和回报 \( ret\_batch \)。随机采样可以增加数据的多样性,避免模型在更新时过度依赖某些特定的数据,从而提高模型的泛化能力。

-

- 重要性采样比计算:对于采样得到的批量数据,根据新策略 \( \pi_{\theta} \) 计算每个动作的对数概率 \( log\_prob\_new\_batch \),然后计算重要性采样比 \( r_t(\theta) = \frac{\pi_{\theta}(a_t|s_t)}{\pi_{\theta_{old}}(a_t|s_t)} = \exp(log\_prob\_new - log\_prob\_old) \)。重要性采样比衡量了新策略相对于旧策略在当前状态下选择该动作的概率变化。

-

- 裁剪目标函数计算:PPO 算法通过引入裁剪机制来限制策略更新的幅度。计算裁剪后的目标函数 \( J^{CLIP} \),它由两个部分组成: \( surr1 = r_t(\theta) A_t \) 和 \( surr2 = \text{clip}(r_t(\theta),1 - \epsilon, 1 + \epsilon) A_t \),然后取两者的最小值,即 \( J^{CLIP} = \mathbb{E}_t \left[ \min \left( r_t(\theta) A_t, \text{clip}(r_t(\theta),1 - \epsilon, 1 + \epsilon) A_t \right) \right] \)。其中 \( \text{clip}(r_t(\theta),1 - \epsilon, 1 + \epsilon) \) 是裁剪函数,将重要性采样比 \( r_t(\theta) \) 限制在区间 \( [1 - \epsilon, 1 + \epsilon] \) 内,防止策略更新过大导致模型性能不稳定。例如,如果 \( r_t(\theta) \) 大于 \( 1 + \epsilon \),则 \( surr2 \) 使用 \( (1 + \epsilon) A_t \),这样就限制了策略更新的幅度,避免新策略过度偏离旧策略。

-

- 参数更新:通过反向传播算法计算裁剪目标函数 \( J^{CLIP} \) 关于策略网络参数 \( \theta \) 的梯度,并使用优化器(如 Adam 优化器)更新策略网络的参数,以最大化裁剪目标函数,使策略朝着获得更高奖励的方向优化。同时,计算价值网络预测值 \( V_{\varphi}(s_t) \) 与实际回报 \( G_t \) 之间的均方误差损失 \( (V_{\varphi}(s_t) - G_t)^2 \),通过反向传播计算该损失关于价值网络参数 \( \varphi \) 的梯度,并使用优化器更新价值网络的参数,使价值网络能够更准确地估计状态的价值。这个过程不断重复多次(由优化步数 \( K \) 决定),以充分利用收集到的数据进行策略和价值网络的更新,提高智能体的性能。

四、PPO 算法的 Python 代码实现

(一)环境搭建与准备

在实现 PPO 算法之前,我们需要搭建相应的 Python 环境并准备好所需的库。主要用到的库是 PyTorch,它是一个广泛应用于深度学习的开源框架,提供了丰富的工具和函数来构建和训练神经网络。此外,还需要安装 OpenAI Gym,它是一个用于开发和比较强化学习算法的工具包,提供了各种模拟环境,方便我们进行算法测试。

安装 PyTorch 可以根据自己的 CUDA 版本和操作系统在 PyTorch 官网(https://pytorch.org/get-started/locally/ )找到对应的安装命令。例如,如果你使用的是 CUDA 11.7,并且是 Python 3.8 以上版本,可以使用以下命令安装:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu117

安装 OpenAI Gym 可以使用以下命令:

pip install gymnasium

在代码中,我们需要导入这些库以及一些其他必要的库,示例代码如下:

import torch

import torch.nn as nn

import torch.optim as optim

import gymnasium as gym

import numpy as np

(二)定义模型

- Actor 网络

Actor 网络的作用是根据当前环境状态输出动作的概率分布。以下是一个简单的 Actor 网络定义代码示例:

class Actor(nn.Module):

def __init__(self, state_dim, action_dim):

super(Actor, self).__init__()

self.fc1 = nn.Linear(state_dim, 64)

self.fc2 = nn.Linear(64, 64)

self.fc3 = nn.Linear(64, action_dim)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

action_probs = torch.softmax(self.fc3(x), dim=-1)

return action_probs

在这段代码中,Actor类继承自nn.Module,这是 PyTorch 中所有神经网络模块的基类。__init__方法是类的构造函数,用于初始化网络的层。这里定义了三个全连接层(nn.Linear),第一层将输入状态的维度从state_dim映射到 64,第二层进一步处理特征,第三层将特征映射到动作空间的维度action_dim,并通过torch.softmax函数将输出转换为动作的概率分布。

前向传播过程中,输入状态x依次通过三个全连接层,每一层后接 ReLU 激活函数,以增加网络的非线性表达能力。最后输出的action_probs表示在当前状态下每个动作被选择的概率。

- Critic 网络

Critic 网络用于估计给定状态的价值。其定义代码如下:

class Critic(nn.Module):

def __init__(self, state_dim):

super(Critic, self).__init__()

self.fc1 = nn.Linear(state_dim, 64)

self.fc2 = nn.Linear(64, 64)

self.fc3 = nn.Linear(64, 1)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

value = self.fc3(x)

return value

Critic网络同样继承自nn.Module。它的结构与 Actor 网络类似,但最后一层的输出维度为 1,因为它只需要输出一个标量值,表示当前状态的价值。在训练过程中,Critic 网络的目标是最小化预测值与实际回报之间的均方误差,以准确估计状态的价值,为 Actor 网络的策略更新提供指导。与 Actor 网络不同,Critic 网络不涉及动作的选择,只是对状态价值进行评估 。

(三)数据收集与处理

在训练过程中,我们需要使用当前策略与环境交互来收集数据。以下是数据收集的示例代码:

def collect_data(env, actor, num_steps):

states = []

actions = []

rewards = []

dones = []

log_probs = []

state, _ = env.reset()

state = torch.FloatTensor(state).unsqueeze(0)

for _ in range(num_steps):

action_probs = actor(state)

dist = torch.distributions.Categorical(action_probs)

action = dist.sample()

log_prob = dist.log_prob(action)

next_state, reward, terminated, truncated, _ = env.step(action.item())

done = terminated or truncated

states.append(state)

actions.append(action)

rewards.append(reward)

dones.append(done)

log_probs.append(log_prob)

state = torch.FloatTensor(next_state).unsqueeze(0)

if done:

state, _ = env.reset()

state = torch.FloatTensor(state).unsqueeze(0)

states = torch.cat(states).detach()

actions = torch.cat(actions).detach()

rewards = torch.FloatTensor(rewards).unsqueeze(1).detach()

dones = torch.FloatTensor(dones).unsqueeze(1).detach()

log_probs = torch.cat(log_probs).detach()

return states, actions, rewards, dones, log_probs

在collect_data函数中,首先初始化一些空列表用于存储状态、动作、奖励、是否结束标志和动作的对数概率。然后,通过env.reset获取初始状态,并将其转换为 PyTorch 的张量。在每一步中,根据当前状态通过 Actor 网络得到动作概率分布,使用Categorical分布进行动作采样,并计算动作的对数概率。执行动作后,从环境中获取下一个状态、奖励、是否终止和截断等信息。将这些数据存储到相应的列表中,并更新当前状态。如果环境到达终止状态,则重置环境。最后,将收集到的数据转换为 PyTorch 张量并返回。

(四)计算优势和回报

计算优势值和回报是 PPO 算法中的重要步骤,我们使用广义优势估计(GAE)来计算优势值。代码实现如下:

def compute_advantages(rewards, values, dones, gamma, lam):

advantages = []

gae = 0

for i in reversed(range(len(rewards))):

if i == len(rewards) - 1:

next_value = 0

else:

next_value = values[i + 1]

delta = rewards[i] + gamma * next_value * (1 - dones[i]) - values[i]

gae = delta + gamma * lam * gae * (1 - dones[i])

advantages.insert(0, gae)

advantages = torch.FloatTensor(advantages).unsqueeze(1)

return advantages

def compute_returns(advantages, values):

returns = advantages + values

return returns

在compute_advantages函数中,首先初始化一个空列表advantages用于存储优势值,以及变量gae用于累积优势估计。通过反向遍历奖励列表,根据 GAE 公式计算每个时间步的优势值。在计算过程中,需要用到下一个状态的价值估计next_value,如果是最后一个时间步,则next_value设为 0。计算出优势值后,将其插入到advantages列表的开头。最后,将优势值列表转换为 PyTorch 张量并返回。

compute_returns函数则比较简单,直接将优势值和状态值相加得到回报。

(五)优化策略和值函数

- 计算重要性采样比和裁剪目标函数

计算重要性采样比和裁剪目标函数是 PPO 算法的核心步骤之一。代码实现如下:

def ppo_update(actor, critic, optimizer_actor, optimizer_critic, states, actions, old_log_probs, returns, advantages,

clip_eps):

for _ in range(3): # 多次更新以充分利用数据

new_action_probs = actor(states)

dist = torch.distributions.Categorical(new_action_probs)

new_log_probs = dist.log_prob(actions)

ratios = torch.exp(new_log_probs - old_log_probs)

surr1 = ratios * advantages

surr2 = torch.clamp(ratios, 1 - clip_eps, 1 + clip_eps) * advantages

actor_loss = -torch.min(surr1, surr2).mean()

values_pred = critic(states)

critic_loss = nn.functional.mse_loss(values_pred, returns)

optimizer_actor.zero_grad()

actor_loss.backward(retain_graph=True)

optimizer_actor.step()

optimizer_critic.zero_grad()

critic_loss.backward()

optimizer_critic.step()

在ppo_update函数中,首先多次循环(这里设置为 3 次)以充分利用收集到的数据进行参数更新。在每次循环中,根据当前状态通过 Actor 网络得到新的动作概率分布,并计算新动作的对数概率。然后计算重要性采样比ratios,它是新策略与旧策略下动作对数概率的指数差值。接下来,计算裁剪目标函数的两个部分surr1和surr2,并取两者的最小值作为 Actor 网络的损失actor_loss。对于 Critic 网络,计算预测值与实际回报之间的均方误差作为损失critic_loss。最后,通过反向传播和优化器分别更新 Actor 网络和 Critic 网络的参数。

- 更新策略网络和价值网络参数

在上述ppo_update函数中,已经展示了如何使用优化器(如Adam优化器)来更新策略网络(Actor)和价值网络(Critic)的参数。首先通过optimizer.zero_grad()将梯度清零,然后通过loss.backward()计算损失的梯度,最后通过optimizer.step()更新参数。在更新 Actor 网络参数时,由于需要同时计算 Critic 网络的损失,所以在actor_loss.backward()中使用了retain_graph=True,以保留计算图,防止在计算 Critic 网络损失时出现问题。

(六)完整代码示例与运行

下面是一个完整的 PPO 算法 Python 代码示例,包含了上述所有部分:

import torch

import torch.nn as nn

import torch.optim as optim

import gymnasium as gym

import numpy as np

class Actor(nn.Module):

def __init__(self, state_dim, action_dim):

super(Actor, self).__init__()

self.fc1 = nn.Linear(state_dim, 64)

self.fc2 = nn.Linear(64, 64)

self.fc3 = nn.Linear(64, action_dim)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

action_probs = torch.softmax(self.fc3(x), dim=-1)

return action_probs

class Critic(nn.Module):

def __init__(self, state_dim):

super(Critic, self).__init__()

self.fc1 = nn.Linear(state_dim, 64)

self.fc2 = nn.Linear(64, 64)

self.fc3 = nn.Linear(64, 1)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

value = self.fc3(x)

return value

def collect_data(env, actor, num_steps):

states = []

actions = []

rewards = []

dones = []

log_probs = []

state, _ = env.reset()

state = torch.FloatTensor(state).unsqueeze(0)

for _ in range(num_steps):

action_probs = actor(state)

dist = torch.distributions.Categorical(action_probs)

action = dist.sample()

log_prob = dist.log_prob(action)

next_state, reward, terminated, truncated, _ = env.step(action.item())

done = terminated or truncated

states.append(state)

actions.append(action)

rewards.append(reward)

dones.append(done)

log_probs.append(log_prob)

state = torch.FloatTensor(next_state).unsqueeze(0)

if done:

state, _ = env.reset()

state = torch.FloatTensor(state).unsqueeze(0)

states = torch.cat(states).detach()

actions = torch.cat(actions).detach()

rewards = torch.FloatTensor(rewards).unsqueeze(1).detach()

dones = torch.FloatTensor(dones).unsqueeze(1).detach()

log_probs = torch.cat(log_probs).detach()

return states, actions, rewards, dones, log_probs

def compute_advantages(rewards, values, dones, gamma, lam):

advantages = []

gae = 0

for i in reversed(range(len(rewards))):

if i == len(rewards) - 1:

next_value = 0

else:

next_value = values[i + 1]

delta = rewards[i] + gamma * next_value * (1 - dones[i]) - values[i]

gae = delta + gamma * lam * gae * (1 - dones[i])

advantages.insert(0, gae)

advantages = torch.FloatTensor(advantages).unsqueeze(1)

return advantages

def compute_returns(advantages, values):

returns = advantages + values

return returns

def ppo_update(actor, critic, optimizer_actor, optimizer_critic, states, actions, old_log_probs, returns, advantages,

clip_eps):

for _ in range(3): # 多次更新以充分利用数据

new_action_probs = actor(states)

dist = torch.distributions.Categorical(new_action_probs)

new_log_probs = dist.log_prob(actions)

ratios = torch.exp(new_log_probs - old_log_probs)

surr1 = ratios * advantages

surr2 = torch.clamp(ratios, 1 - clip_eps, 1 + clip_eps) * advantages

actor_loss = -torch.min(surr1, surr2).mean()

values_pred = critic(states)

critic_loss = nn.functional.mse_loss(values_pred, returns)

optimizer_actor.zero_grad()

actor_loss.backward(retain_graph=True)

optimizer_actor.step()

optimizer_critic.zero_grad()

critic_loss.backward()

optimizer_critic.step()

if __name__ == "__main__":

env = gym.make('CartPole-v1')

state_dim = env.observation_space.shape[0]

action_dim = env.action_space.n

actor = Actor(state_dim, action_dim)

critic = Critic(state_dim)

optimizer_actor = optim.Adam(actor.parameters(), lr=3e-4)

optimizer_critic = optim.Adam(critic.parameters(), lr=3e-4)

gamma = 0.99

lam = 0.95

clip_eps = 0.2

num_steps = 2048

num_epochs = 100

for epoch in range(num_epochs):

states, actions, rewards, dones, log_probs = collect_data(env, actor, num_steps)

values = critic(states)

advantages = compute_advantages(rewards, values, dones, gamma, lam)

returns = compute_returns(advantages, values)

ppo_update(actor, critic, optimizer_actor, optimizer_critic, states, actions, log_probs, returns, advantages,

clip_eps)

avg_reward = torch.mean(rewards).item()

print(f'Epoch: {epoch + 1}, Average Reward: {avg_reward}')

env.close()

要运行这段代码,你只需要将上述代码保存为一个 Python 文件(例如ppo_example.py),然后在命令行中执行:

python ppo_example.py

运行过程中,你会看到每个训练周期(epoch)的平均奖励输出。随着训练的进行,平均奖励应该逐渐增加,表明智能体在不断学习并提高其在环境中的表现。你可以根据实际需求调整超参数,如学习率、折扣因子、GAE 参数、裁剪参数等,以优化算法的性能 。同时,也可以尝试将该算法应用到其他 Gym 环境中,观察其效果。

五、应用案例与实践

(一)游戏 AI 领域

PPO 算法在游戏 AI 领域取得了令人瞩目的成果,其中 OpenAI Five 在 Dota 2 中的应用以及 AlphaStar 在星际争霸 Ⅱ 中的表现尤为突出。

OpenAI Five 是 OpenAI 开发的基于 PPO 算法的多智能体系统,旨在掌握复杂的 MOBA 游戏 Dota 2。Dota 2 拥有极其庞大的动作空间和复杂的策略机制,要求智能体具备高度的决策能力和团队协作能力。OpenAI Five 通过大规模分布式训练,利用 PPO 算法不断优化每个智能体的策略。它可以在与环境的交互中学习到各种复杂的战术,如对线技巧、团战配合、资源管理等。在 2019 年,OpenAI Five 击败了 Dota 2 世界冠军战队 OG,展示了 PPO 算法在训练高水平游戏 AI 方面的强大能力 。其优势在于能够高效地利用样本数据进行学习,快速收敛到较好的策略,并且通过多智能体之间的协作,实现了复杂的团队战术。

DeepMind 开发的 AlphaStar 则是针对即时战略游戏星际争霸 Ⅱ 的 AI。星际争霸 Ⅱ 不仅具有复杂的宏观策略决策,如资源采集、基地建设、科技研发,还涉及微观的战斗操作,如单位控制、阵型调整等。AlphaStar 结合了深度学习和强化学习技术,其中 PPO 算法在策略优化中起到了关键作用。通过在大量的游戏对战中学习,AlphaStar 能够根据不同的游戏局势做出合理的决策,达到了人类大师级玩家的水平。PPO 算法使得 AlphaStar 在训练过程中能够稳定地更新策略,避免因策略更新过大而导致的性能波动,从而逐步提升在复杂游戏环境中的竞争力 。

(二)机器人控制领域

在机器人控制领域,PPO 算法同样发挥着重要作用,波士顿动力 Atlas 机器人的步态优化就是一个典型案例。Atlas 机器人是一款高度复杂的人形机器人,其运动控制需要精确协调多个关节的运动,以实现稳定、高效的行走和各种复杂动作。

传统的机器人步态控制方法通常依赖于预先设定的规则和模型,这种方式在面对复杂多变的环境时往往缺乏灵活性和适应性。而 PPO 算法为机器人步态优化提供了新的解决方案。通过将机器人的运动状态作为环境状态,将关节的控制动作作为智能体的动作,PPO 算法可以让机器人在仿真环境中进行大量的试验和学习。机器人在与环境的交互中,根据不同动作所获得的奖励(如行走的稳定性、能量消耗、到达目标的速度等),不断调整自己的步态策略 。

例如,在面对崎岖不平的地形时,PPO 算法可以使 Atlas 机器人通过学习自动调整关节角度和运动顺序,以保持身体平衡并顺利通过。这种基于强化学习的方法,使机器人能够根据实际环境情况实时做出最优决策,极大地提高了机器人的环境适应能力和任务执行能力,推动了机器人技术在复杂现实场景中的应用。

(三)自然语言处理领域

在自然语言处理领域,PPO 算法也有着重要的应用,ChatGPT 的策略优化阶段便是一个很好的例子。ChatGPT 是基于 GPT 模型开发的大型语言模型,它能够生成高质量的自然语言回复。在 ChatGPT 的训练过程中,基于人工反馈的强化学习(RLHF)方法被用于进一步优化模型的策略,而其中的强化学习算法正是 PPO 。

具体来说,首先通过人工标注的数据对 GPT 模型进行微调,然后训练一个奖励模型来评估模型生成回复的质量。接着,使用 PPO 算法,以奖励模型的输出作为反馈信号,对模型进行强化学习优化。PPO 算法通过不断调整模型的策略,使得模型生成的回复更加符合人类的期望和偏好,提高了回复的相关性、准确性和有用性 。例如,在处理用户的问题时,ChatGPT 能够利用 PPO 算法优化后的策略,生成更有针对性、逻辑清晰的回答,提升了用户体验和交互效果,展示了 PPO 算法在自然语言处理任务中优化语言生成策略的强大能力。

六、总结与展望

(一)PPO 算法总结

PPO 算法作为强化学习领域的重要成果,具有独特的优势和重要的应用价值。从核心原理来看,它通过引入裁剪代理目标函数,巧妙地限制了策略更新的幅度,避免了策略的剧烈变化,从而保证了训练过程的稳定性。这种设计有效地解决了传统策略梯度方法中更新步长敏感的问题,使得智能体在学习过程中能够更加稳健地优化策略 。同时,重要性采样思想的运用,使得 PPO 能够复用旧策略采集的数据,大大提高了样本利用率,减少了与环境交互的次数,在有限的样本资源下实现更高效的学习。

在算法流程方面,PPO 基于 Actor - Critic 架构,通过收集数据、计算优势与回报、优化策略等步骤,实现了策略网络和价值网络的协同优化。在数据收集阶段,智能体与环境充分交互,获取丰富的经验数据;利用广义优势估计计算优势值和回报,为策略更新提供了准确的指导;在优化策略时,通过多次迭代更新,充分利用数据,逐步提升智能体的性能。

通过 Python 代码实现,我们更直观地了解了 PPO 算法的具体执行过程。从环境搭建、模型定义,到数据收集、处理以及策略和值函数的优化,每个环节都紧密相连,共同构成了一个完整的 PPO 算法体系。这种清晰的实现过程,不仅有助于我们深入理解算法原理,也为在实际应用中灵活运用 PPO 算法提供了便利。

(二)局限性与改进方向

尽管 PPO 算法表现出色,但它也并非完美无缺,存在一些局限性。首先,PPO 算法存在陷入局部最优陷阱的风险。由于 Clip 机制限制了策略更新的幅度,虽然保证了训练的稳定性,但在一定程度上也限制了智能体对策略空间的探索能力,可能导致智能体在面对复杂环境时无法找到全局最优策略。

在处理高维动作空间时,PPO 算法也面临挑战。随着动作空间维度的增加,策略的搜索空间呈指数级增长,这使得 PPO 算法的训练难度加大,需要更加精细地调整熵系数等超参数,以平衡探索与利用的关系,否则可能出现训练不稳定或收敛速度慢的问题。

针对这些局限性,研究人员提出了许多前沿的改进方法。例如,PPO - Adaptive 通过动态调整 Clip 范围 \( \epsilon \),使得算法能够根据训练情况自动调整策略更新的幅度,在训练初期允许较大的更新幅度以加快探索速度,而在训练后期则减小更新幅度以保证策略的稳定性,从而有效提高了算法的性能和适应性 。

POP(Phasic Policy Gradient)则解耦了策略与价值函数的更新频率,根据不同阶段的需求分别对策略和价值函数进行更新,避免了两者之间的相互干扰,提高了算法的效率和稳定性。

结合元学习也是一种有前景的改进方向。通过元学习,PPO 算法可以在多个任务上进行训练,学习到快速适应新任务的能力,实现跨任务的快速迁移和优化,如 Meta - PPO 算法,在面对新的任务时能够更快地收敛到较好的策略 。

(三)未来展望

展望未来,PPO 算法在强化学习领域有着广阔的应用前景。随着离线强化学习的兴起,将 PPO 算法与离线强化学习相结合,有望解决在线学习中数据收集成本高、效率低的问题。通过利用大量的离线数据进行训练,PPO 算法可以在不与环境实时交互的情况下优化策略,从而在一些难以获取实时数据的场景中发挥重要作用,如自动驾驶的仿真训练、工业生产的模拟优化等。

在多智能体系统中,PPO 算法也将大有可为。多智能体系统中的智能体之间存在复杂的交互和协作关系,PPO 算法可以用于优化每个智能体的策略,使智能体能够在与其他智能体的交互中学习到最优的协作策略,实现更高效的团队合作。例如,在智能交通系统中,多个车辆作为智能体,通过 PPO 算法可以学习到如何合理规划行驶路线、避免碰撞,提高交通系统的整体效率 。

PPO 算法为强化学习领域带来了新的突破和发展,其高效性、稳定性和易实现性使其成为众多应用场景的首选算法之一。尽管存在一些局限性,但随着研究的不断深入和改进方法的不断涌现,PPO 算法将在未来的人工智能发展中发挥更加重要的作用。希望读者能够通过本文对 PPO 算法有更深入的了解,并在实际研究和应用中不断探索和创新,推动强化学习技术的进一步发展。

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)