迈向稳健安全的具身人工智能:关于漏洞与攻击的综述(上)

25年11月来自浙大、黑龙江大学和贵州大学的论文“Towards Robust and Secure Embodied AI: A Survey on Vulnerabilities and Attacks”。具身人工智能系统,包括机器人和自动驾驶汽车,正日益融入现实世界的应用,并面临着一系列源于环境和系统层面的漏洞。这些漏洞表现为传感器欺骗、对抗性攻击以及任务和运动规划失败,对系统的鲁棒性和安全

25年11月来自浙大、黑龙江大学和贵州大学的论文“Towards Robust and Secure Embodied AI: A Survey on Vulnerabilities and Attacks”。

具身人工智能系统,包括机器人和自动驾驶汽车,正日益融入现实世界的应用,并面临着一系列源于环境和系统层面的漏洞。这些漏洞表现为传感器欺骗、对抗性攻击以及任务和运动规划失败,对系统的鲁棒性和安全性构成重大挑战。尽管相关研究日益增多,但现有综述很少专门关注具身人工智能系统特有的安全挑战。以往的研究大多要么着眼于通用人工智能漏洞,要么侧重于孤立的方面,缺乏专门针对具身人工智能的统一框架。本综述填补这一关键空白,具体体现在:(1) 将具身人工智能特有的漏洞分为外源性(例如,物理攻击、网络安全威胁)和内源性(例如,传感器故障、软件缺陷)两类;(2) 系统地分析具身人工智能特有的对抗性攻击范式,重点关注其对感知、决策和具身交互的影响; (3)研究针对具身系统中大型视觉语言模型(LVLM)和大语言模型(LLM)的攻击向量,例如越狱攻击和指令误译;(4)评估具身感知、决策和任务规划算法的鲁棒性挑战;以及(5)提出有针对性的策略来增强具身人工智能系统的安全性和可靠性。整合这些维度,其提供一个全面的框架,用于理解具身人工智能中漏洞与安全性之间的相互作用。

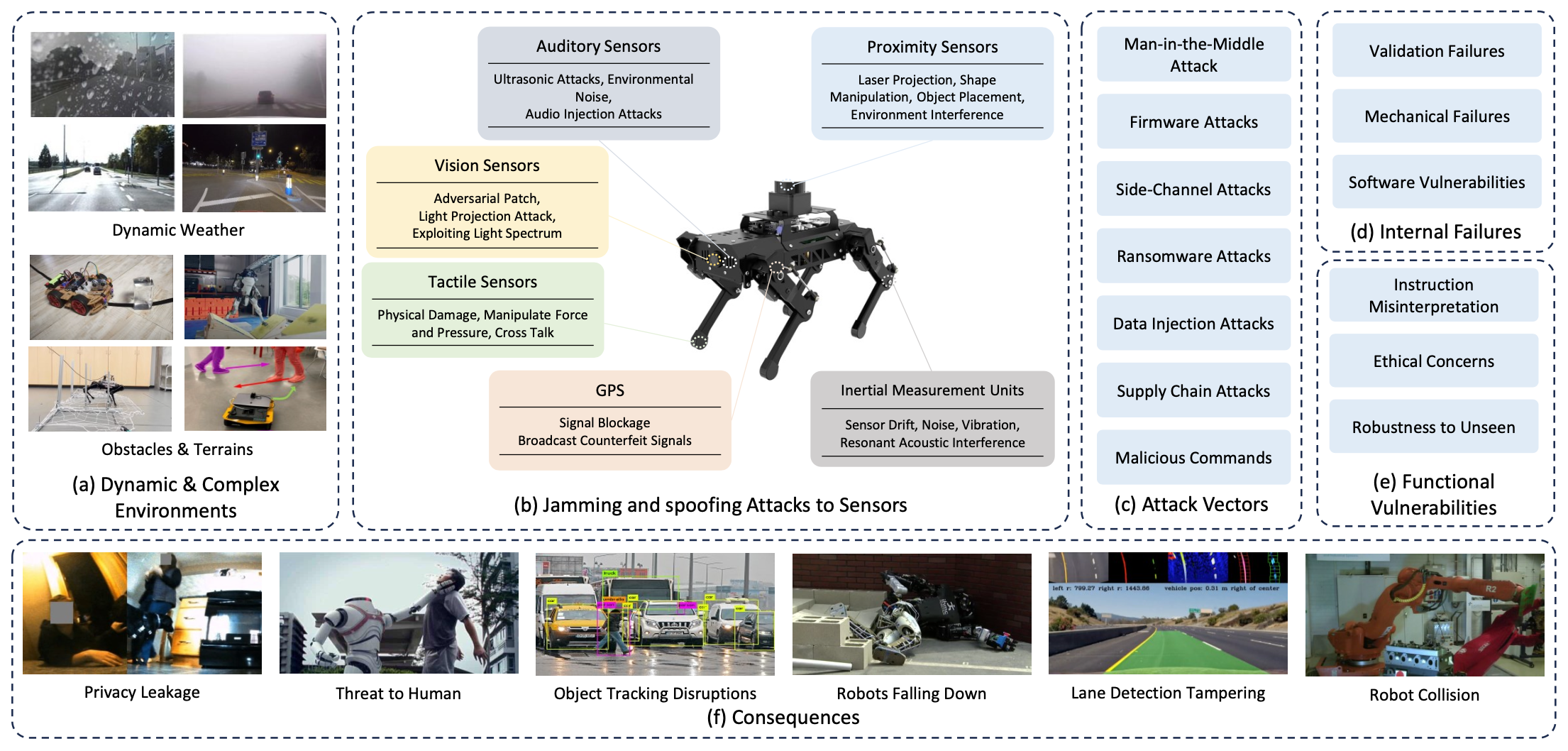

人工智能的飞速发展使得具身人工智能成为自动驾驶、工业自动化和智能家居系统等领域的关键技术。这些系统通过融合感知、决策和执行功能,在处理复杂的现实世界任务方面表现出色。然而,如图所示,它们对传感器、执行器和算法之间复杂交互的依赖也使其面临诸多安全漏洞,包括动态复杂的环境、传感器干扰和欺骗攻击以及系统故障。这些风险引发人们对未经授权行为和声誉损害的担忧,凸显采取强有力的安全措施以确保其安全可靠部署的迫切性。

稳健的具身系统有三个关键特征[27]:自主性、具身性和认知性。自主性是指系统能够做出明智的独立决策,使其能够适应动态且不可预测的场景。然而,这种独立性也带来了一些漏洞,例如在复杂环境中可能出现决策错误。具身性是指系统与物理环境交互的能力,它将物理存在与决策过程相结合,从而实现无缝交互。认知能力涵盖系统理解、推理和解释自身行为的能力,确保其行为符合内部目标和外部约束。然而,认知过程也可能被利用,例如通过传感器到模型的攻击或对已学习模型的操纵。

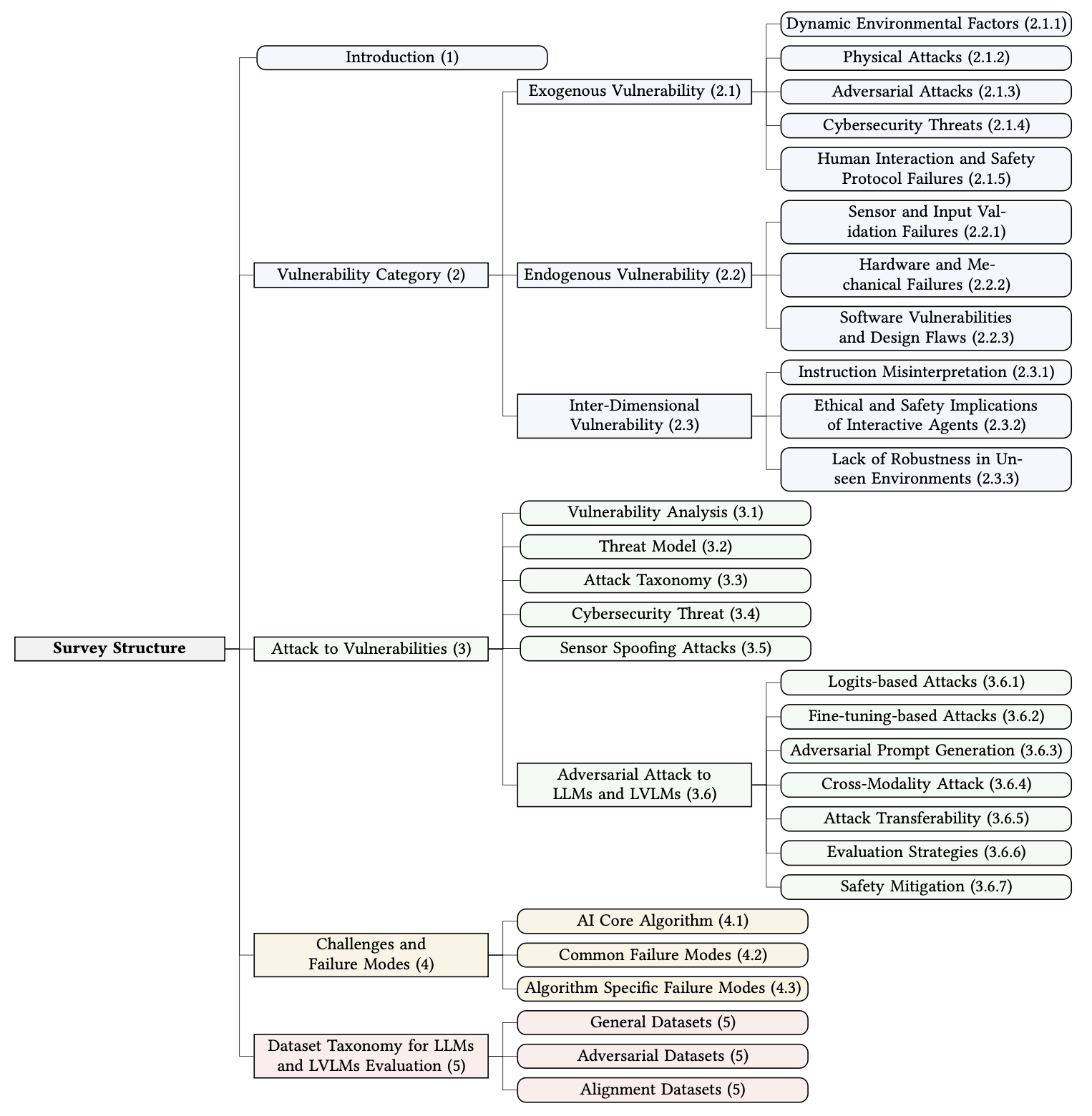

本文系统地探讨具身人工智能系统中的漏洞、攻击途径和缓解策略,如图所示。具身人工智能漏洞被分为外生风险、内生风险和跨维度风险,并进一步探讨物理攻击、传感器验证失败以及交互式智体中的伦理挑战等具体问题。另外,探讨漏洞与攻击策略之间的关系,包括威胁模型分析和攻击的详细分类,例如网络安全威胁和传感器欺骗攻击。第重点关注针对大语言模型 (LLM) 和大型视觉语言模型 (LVLM) 的对抗性攻击,着重介绍基于逻辑的攻击、对抗性提示生成和跨模态攻击等技术。本文探讨具身人工智能面临的挑战和失效模式,包括常见失效模式和算法特定的漏洞。还提供用于评估 LLM 和 LVLM 的数据集分类,涵盖通用数据集、对抗性数据集和对齐数据集。最后,总结主要发现并提出未来研究方向。

具身人工智能系统固有的风险大致可分为三个关键维度:外生脆弱性,源于动态环境或对抗性攻击等外部因素;内生脆弱性,源于内部系统故障,包括硬件故障和软件漏洞;此外,还存在维度间脆弱性,其中外部因素和内部因素之间的相互作用会加剧系统脆弱性。

外生脆弱性

外生风险源于系统与其环境或外部恶意行为者的交互。这些风险分为动态环境因素、物理攻击、对抗性攻击、网络安全威胁以及人机交互和安全协议失效。

内生性脆弱性

内生性风险源于系统自身,包括硬件故障、软件漏洞和设计缺陷。这些风险通常更易预测,但如果不加以充分缓解,仍然可能导致严重后果。

维度间脆弱性

某些风险可能同时涉及外生和内生两个维度,其中外部因素会加剧内部脆弱性。例如,利用软件漏洞(内生)的网络攻击(外生)可能导致机器人或车辆被未经授权控制,从而造成物理损坏或运行中断。同样,极端温度或湿度等环境因素可能会加速硬件老化,导致机械故障。

多模态大模型(尤其是源自LLM的LLVM模型)的出现,通过赋予系统在视觉和语言任务中感知、推理和交互的高级能力,彻底革新具身人工智能。这些模型利用大量的预训练、高容量和复杂的对齐技术,实现最先进的性能。然而,它们的多模态特性——融合视觉和文本模态——显著扩大攻击面,引入独特的漏洞。攻击者可以利用视觉输入、文本提示或它们之间的交互来构建复杂的攻击向量,从而暴露现有防御体系的关键漏洞。

本文系统地分析这些系统的漏洞,首先进行漏洞分析,重点阐述扩大的攻击面、攻击者的漏洞以及文本和动作之间转换带来的挑战。接下来,威胁模型概述攻击者的能力和潜在目标,随后是攻击分类法,该分类法将威胁分为三大类:外生攻击、内生攻击和跨维度漏洞中心攻击。之后深入探讨具体的攻击方法,包括网络安全威胁、传感器欺骗攻击和对抗性攻击。

漏洞分析

LLM和LVLM的漏洞源于其训练范式、数据覆盖范围和架构属性的根本性限制。其中三个关键问题:训练和数据限制、神经网络对抗性漏洞以及多模态系统扩展攻击面。

训练和数据限制。LLM 的自回归训练范式侧重于下一个token的预测,这与生成有用、真实且无害的响应的目标有所偏差。安全性考虑并非内在因素,使用安全数据集进行微调也只能提供有限的缓解措施。在未经筛选的互联网数据 [30] 上进行预训练会引入偏差 [59] 和有害内容 [226],从而强化刻板印象或生成有害的输出。训练范式和数据方面的这些局限性加剧了模型易受对抗性操纵和滥用的脆弱性。

对抗性漏洞。深度神经网络 (DNN) 尽管具有非线性架构,但在高维输入空间中通常表现出近似线性的行为,这使得它们容易受到对抗样本的攻击 [32]。微小的输入扰动会导致预测结果发生显著变化,例如 FGSM 和 Carlini & Wagner (CW) 攻击 [32]。此外,训练过程中输入空间覆盖不完整 [161] 会导致盲点,从而增加过拟合并降低泛化能力 [155]。在决策边界附近,陡峭的梯度会进一步放大这种脆弱性 [162]。DNN 对高频成分也高度敏感 [202],这会造成人类感知与模型行为之间的不匹配,而攻击者可以利用这种不匹配。

扩展的攻击面。LVLM 处理多模态输入(例如,文本和视觉),这增强了其功能,但也引入了新的漏洞。一种模态中的对抗信号可以传播到其他模态,从而放大其影响[122];例如,篡改的视觉信息可以干扰文本推理。LVLM的日益普及,尤其是在具身人工智能和传感器驱动系统中,扩大了攻击面。Zhang[255]证明,针对LVLM的对抗性攻击对自动驾驶构成重大风险。

从文本-到-动作的转换。旨在绕过LLM安全机制的传统越狱攻击,可能并不完全适用于具身系统。具身LLM不仅需要生成文本,还需要在物理世界中规划和执行动作。这就需要一种新的攻击范式,以应对具身系统中动作规划和执行的独特挑战。例如,具身LLM通常会生成结构化输出,例如JSON或YAML,这些输出随后会被下游控制模块用于执行动作[74, 169, 219]。攻击者可以利用这些结构化输出来操纵系统行为,从而导致不安全或非预期行为。

威胁模型

对抗性威胁模型的框架由两个主要方面定义:攻击者的能力及其预期目标。

攻击者能力

在白盒攻击中,攻击者可以完全访问系统的架构、参数和 API,这在开源具身人工智能系统或模拟器中很常见 [20, 192]。经典的白盒攻击示例包括 FGSM [11]、PGD [69]、APGD [45] 和 CW [32]。这使得攻击者能够发起高度针对性和复杂的攻击。

灰盒攻击:当攻击者拥有部分访问权限(通常是通过高级 API 或外部接口),但无法控制底层组件时,就会出现灰盒攻击 [118]。这些攻击通常会利用外部输入(例如传感器数据或用户命令)中的漏洞。

黑盒攻击:在黑盒攻击中,攻击者对系统的内部运作一无所知,只能通过输入查询进行交互。即使商业系统采用了专有保护措施,攻击者仍然可以利用外部输入造成损害。

攻击目标

攻击的具体目标会因攻击者的目标而异。具身人工智能系统中常见的攻击目标包括:

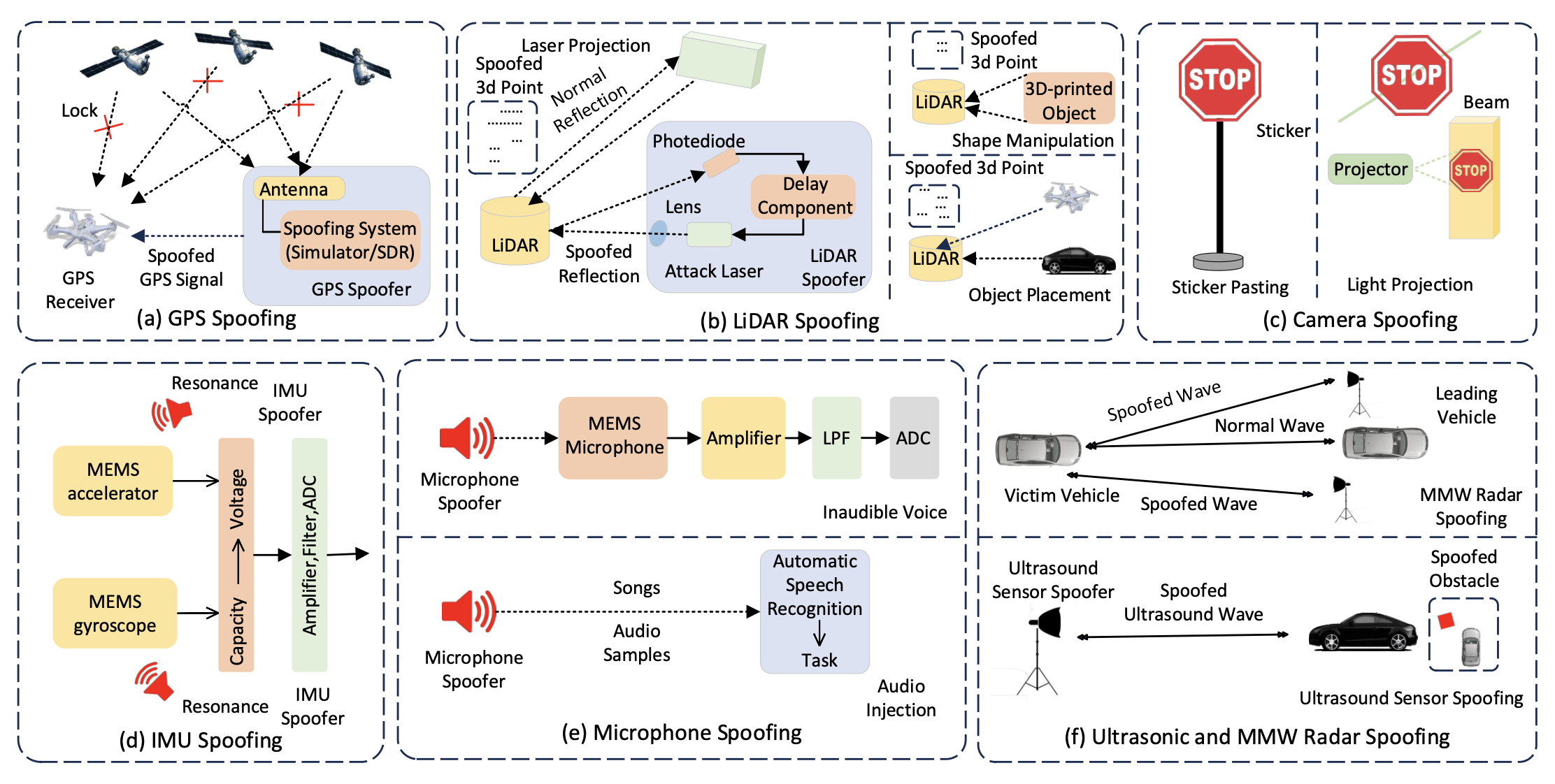

•感知系统:对传感器(例如摄像头、激光雷达和GPS,详见3.5节)的攻击会破坏系统准确解读环境的能力,导致决策错误。例如,传感器欺骗会导致自动驾驶车辆误判距离或无法检测到障碍物。无人机GPS欺骗攻击[13]就是一个典型的例子,该攻击通过GPS欺骗劫持一架民用无人机,导致其被用于非法用途。

•控制系统:针对系统控制算法漏洞的攻击可能导致不安全行为,例如异常移动或不遵守安全规程。例如,攻击者可以操纵机器人的控制系统,使其与物体或人发生碰撞。

• 通信信道:具身人工智能系统通常依赖无线通信进行协调和控制。针对这些通信信道的攻击,例如干扰或中间人攻击 (MitM),会破坏系统接收关键更新或命令的能力。

攻击分类

针对具身人工智能的攻击可以根据攻击者的能力、目标组件和漏洞以及它们对系统性能的总体影响进行系统分类。该分类涵盖一系列策略,包括数据投毒、传感器欺骗和对抗性扰动,每种策略都有其独特的机制和影响。

外源性漏洞中心攻击

– 数据中心攻击

数据投毒:攻击者将恶意数据注入训练集,导致模型学习错误的关联,这可能会导致自动驾驶或机器人手术等安全关键型应用出现故障。

– 输入操纵攻击

对抗性攻击:对抗性攻击对机器学习模型构成重大威胁,尤其是在感知系统中使用的模型。Szegedy [172, 203] 首先证明,许多机器学习算法容易受到对抗样本的影响,对抗样本是指输入数据中的微小扰动,会导致模型预测错误。这种脆弱性主要是由于神经网络固有的非线性特性 [78]。

传感器欺骗攻击:这类攻击利用具身人工智能系统传感器数据管道中的漏洞,针对数据采集、处理和解释过程。与通过操纵数字输入来欺骗机器学习模型的对抗性攻击不同,传感器欺骗攻击发生在物理领域,直接操纵环境或传感器信号。例如,攻击者可以向激光雷达、GPS 或摄像头等传感器注入虚假数据,导致机器人错误解读周围环境并表现出意外行为,例如碰撞或导航失败 [236, 263],误导自动驾驶车辆 [233],或者嵌入恶意语音命令以利用智能助手执行未经授权的操作。

命令注入:在基于自然语言处理的系统中,例如语音助手或机器人,攻击者可以通过语音或文本输入注入恶意命令,从而可能触发意外操作,例如解锁门锁、禁用安全系统或执行危险操作。

越狱攻击:针对LLM和LVLM的越狱攻击涉及构造绕过模型安全机制的提示,从而对信息安全构成重大风险。与主要针对物理系统的命令注入攻击不同,越狱攻击利用模型响应生成机制中的漏洞。两种具有代表性的技术包括:1)提示注入:通过注入恶意提示来操纵模型的输出,导致 LLM 生成有害或非预期的响应;2)对抗性提示:对输入提示进行细微扰动,以引发 LLM 的意外反应。

– 系统和基础设施攻击

API 操纵:攻击者利用暴露的 API 发送恶意命令,导致系统行为异常,例如操纵机器人的导航使其走不安全路径或与障碍物碰撞。

拒绝服务 (DoS) 攻击:攻击者通过发送过多的输入查询使系统不堪重负,导致系统运行缓慢或无响应,这对自动驾驶汽车或无人机等实时系统尤其危险。

中间人 (MitM) 攻击:中间人攻击利用无线通信中的漏洞,拦截并操纵系统与外部服务之间的数据,通过篡改传感器数据或控制命令来威胁自动驾驶汽车和机器人系统的安全 [43, 177]。通信协议中薄弱的加密会扩大攻击面,而强加密(例如 TLS、IPsec)和入侵检测系统 (IDS) 等应对措施有助于降低风险 [5, 194]。

内生漏洞中心型攻击

– 模型中心型攻击

模型提取攻击:攻击者通过逆向工程(利用完全系统访问权限)或基于查询的提取(通过大量的输入输出查询来近似模型的决策边界)等方法复制模型的功能或发现漏洞。

– 系统和基础设施攻击

供应链攻击:攻击者通过攻击开发或部署中的漏洞,插入恶意代码,例如 SolarWinds 攻击,该攻击影响了全球多个组织。[230]

– 传感器和硬件攻击

侧信道攻击:攻击者利用间接数据泄露(例如,时间或功耗),推断敏感信息,对嵌入式机器人等安全系统构成风险。[106]

固件攻击:利用具身系统(例如,自动驾驶汽车、无人机)中的底层软件,获得持久控制权,绕过更高级别的安全措施;难以检测和缓解,这些漏洞需要安全启动和运行时固件验证等防御措施。

– 漏洞利用

零-日漏洞:攻击者利用未公开的漏洞对关键系统(例如医疗机器人或无人机)发起有效攻击。

跨维度漏洞攻击

– 复杂且协调的攻击

高级持续性威胁 (APT):这类攻击者拥有资源和专业知识,能够进行长期隐蔽攻击,在不被发现的情况下逐步破坏系统 [7]。

勒索软件攻击:这类攻击会加密关键文件或锁定控制软件,导致具身人工智能系统(例如,自动驾驶汽车、工业机器人)无法运行,直到支付赎金为止。具身人工智能系统由于依赖实时数据处理而特别容易受到攻击,勒索软件导致的故障可能会在相互连接的系统中引发连锁反应 [91]。

网络安全威胁

网络安全威胁日益复杂,攻击者瞄准智能系统的核心组件,利用漏洞破坏系统运行。从中间人攻击(MitM)拦截敏感通信,到传感器到模型攻击,再到固件入侵和侧信道攻击,这些威胁都会损害系统的完整性和机密性。此外,勒索软件攻击和供应链攻击会进一步加剧风险,攻击目标包括关键基础设施和受信任的依赖项。了解这些攻击途径对于开发主动且具有弹性的具身人工智能系统至关重要。

传感器欺骗攻击

在具身人工智能系统中,多种传感器被用于实现环境感知和交互。这些传感器包括触觉传感器、视觉传感器、接近传感器、惯性测量单元 (IMU)、GPS 和听觉传感器,每个传感器都提供独特的数据,以增强系统的导航和任务执行能力。然而,尽管这些传感器发挥着至关重要的作用,但它们并非不会受到安全漏洞的影响。针对具身智体的基于传感器的攻击已成为一个重要的安全问题,因为攻击者可以利用传感器数据管道中的特定漏洞绕过现有的安全措施,从而破坏系统完整性 [103],如图所示。

这些攻击的目标是传感器数据采集、处理和解释的基本过程,通常会导致严重的运行故障。例如,传感器欺骗攻击通过向机器人的传感器注入虚假数据来操纵其感知,这可能导致意外行为,例如与障碍物碰撞或无法导航到预期目的地 [236, 263]。关于这些攻击策略及其影响的全面综述,请参见 [236]。

。。。。。。待续。。。。。。

更多推荐

已为社区贡献39条内容

已为社区贡献39条内容

所有评论(0)