简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

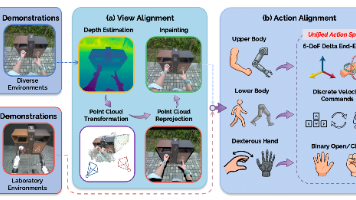

26年2月来自港大、上海创新研究院、北航和 Kinetix AI 公司的论文“EgoHumanoid: Unlocking In-the-Wild Loco-Manipulation with Robot-Free Egocentric Demonstration”。人类演示提供丰富的环境多样性和自然尺度,使其成为机器人远程操作的理想替代方案。虽然这种范式已经推动机器人手臂操作的发展,但其在更具挑

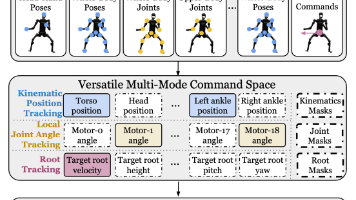

25年3月来自Nvidia、CMU、伯克利分校、德州奥斯丁分校和 UCSD 的论文“HOVER: Versatile Neural Whole-Body Controller for Humanoid Robots”。人形机器人的全身控制需要适应导航、移动操作和桌面操作等多种任务,每种任务都需要不同的控制模式。例如,导航依赖于根速度或位置跟踪,而桌面操作则优先考虑上半身关节角度跟踪。现有方法通常针

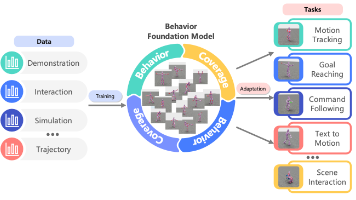

25年6月来自香港理工、逐际动力、宁波数字孪生研究院、香港大学和瑞士 EPFL 的论文“Behavior Foundation Model: Towards Next-Generation Whole-Body Control System of Humanoid Robots”。人形机器人作为用于复杂运动控制、人机交互和通用物理智能的多功能平台,正备受关注。然而,由于复杂的动力学、欠驱动和多样化

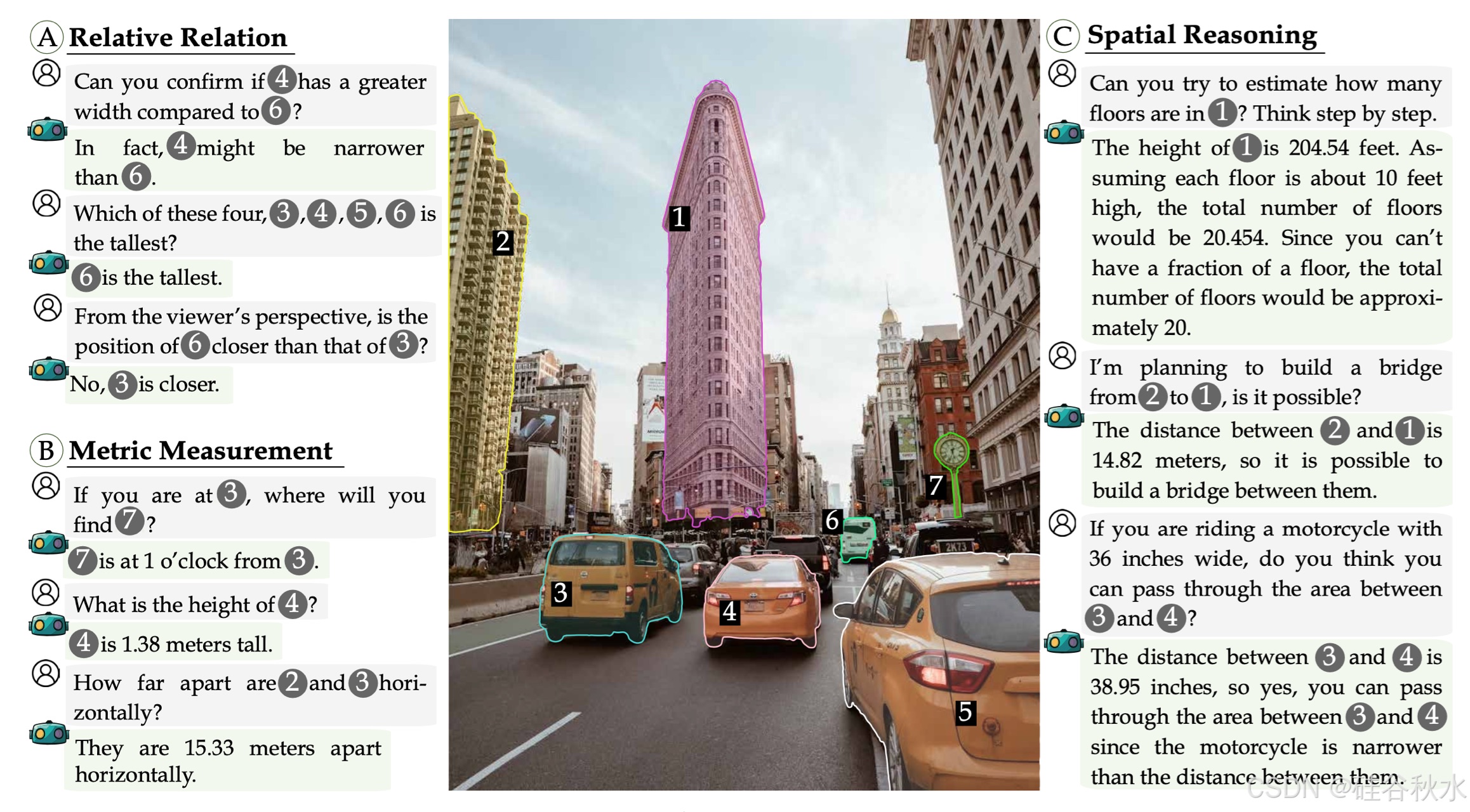

24年10月来自UCSD和Nvidia的论文“SpatialRGPT: Grounded Spatial Reasoning in Vision-Language Models”。视觉-语言模型 (VLM) 在 2D 视觉和语言任务中表现出色。然而,它们推理空间安排的能力仍然有限。这项工作引入空间域 GPT (SpatialRGPT) 来增强 VLM 的空间感知和推理能力。SpatialRGPT

25年3月来自哈工大、中南大学、香港大学和复旦大学的论文“Towards Reasoning Era: A Survey of Long Chain-of-Thought for Reasoning Large Language Models”。OpenAI-O1 和 DeepSeek-R1 等推理大语言模型 (RLLM) 领域的最新进展,已在数学和编码等复杂领域展示其深刻的能力。它们成功的核心因

25年4月来自清华大学的论文“Embodied-R: Collaborative Framework for Activating Embodied Spatial Reasoning in Foundation Models via Reinforcement Learning”。人类可以从连续的视觉观察(例如以自我为中心的视频流)中感知和推理空间关系。然而,预训练模型如何获得这种能力,尤其是高

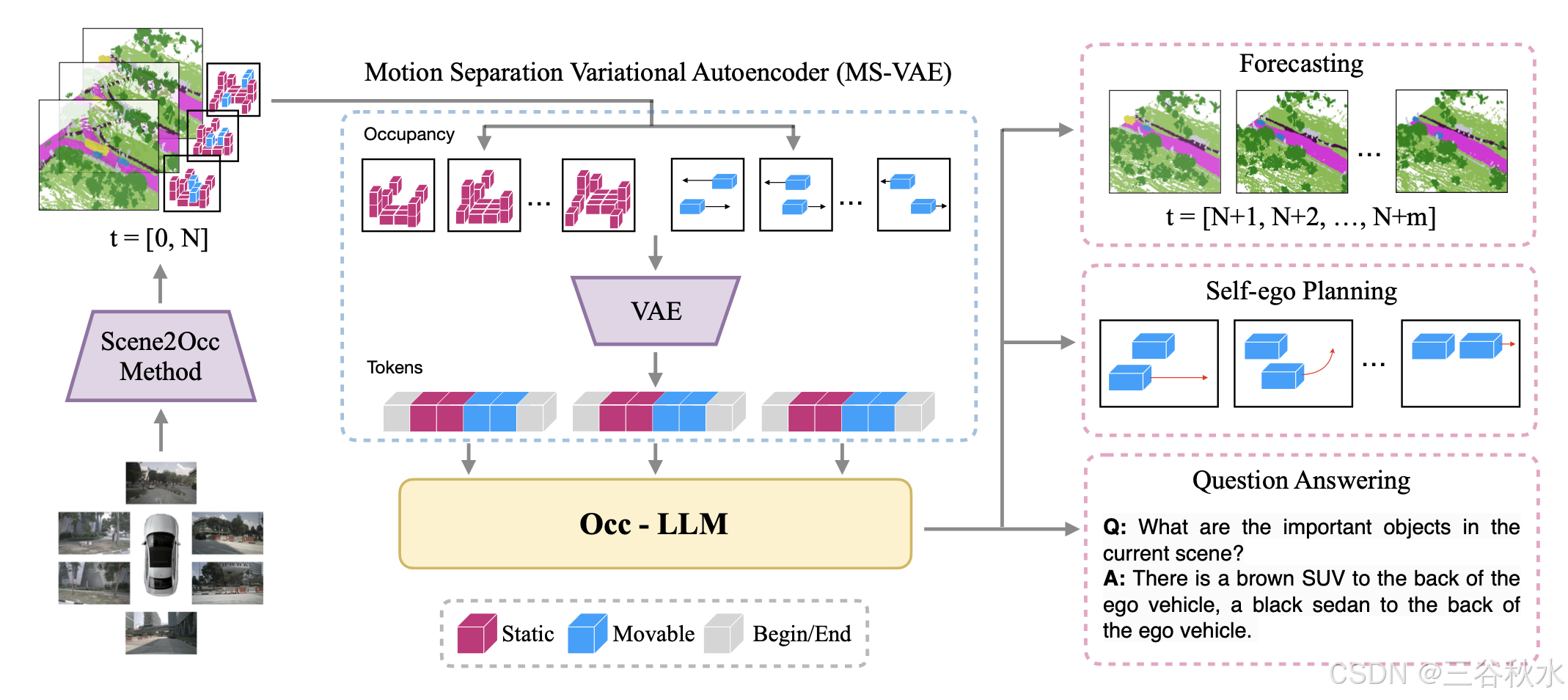

25年2月来自香港科技大学广州分校的论文“Occ-LLM: Enhancing Autonomous Driving with Occupancy-Based Large Language Models”。大语言模型 (LLM) 在机器人和自动驾驶领域取得重大进步。本研究提出一个基于占用的大型语言模型 (Occ-LLM),它代表将 LLM 与重要表示相结合的开创性努力。为了有效地将占用编码为 LL

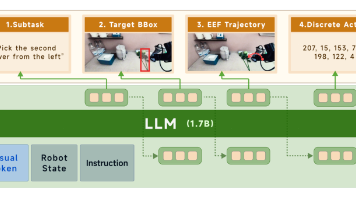

26年2月来自原力灵机和阶跃AI的论文“DM0: An Embodied-Native Vision-Language-Action Model towards Physical AI”。本文突破将互联网预训练模型应用于物理任务的传统范式,提出DM0,一个专为物理人工智能设计的具身原生视觉-语言-动作(VLA)框架。与将物理基础事后微调的方法不同,DM0从一开始就通过学习异构数据源,统一具身操作和

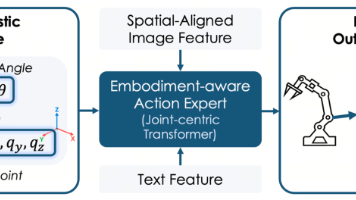

26年2月来自地平线的论文“HoloBrain-0 Technical Report”。本文介绍一种名为 HoloBrain-0 的综合性视觉-语言-动作 (VLA) 框架,它弥合基础模型研究与可靠的真实世界机器人部署之间的鸿沟。系统的核心是一种 VLA 架构,它显式地整合机器人具身先验信息,包括多视角相机参数和运动学描述 (URDF),以增强 3D 空间推理能力并支持多样化的具身形态。通过可扩展

LeRobot 采用模块化架构设计,在提供统一的机器人学习接口的同时,也兼具灵活性。该框架的核心由四个主要子系统组成:策略系统 - 实现各种机器人控制学习算法数据集管理 - 处理机器人数据的存储、加载和预处理环境接口 - 提供与模拟环境交互的抽象层机器人控制系统 - 管理机器人物理硬件和控制模式