简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Uber构建了高性能缓存系统CacheFront,在保证强一致性的前提下每秒处理超1.5亿次读取。系统采用三层架构:查询引擎、存储引擎和缓存层,使用Redis作为缓存,实现99.9%的命中率。针对写操作导致的数据不一致问题,Uber创新性地结合同步失效、异步CDC和TTL三重机制,并改造存储引擎支持条件更新的精确追踪。通过Cache Inspector工具验证,系统在保持极高命中率的同时,几乎消除

Ollama现在已有Docker hub开源的镜像提供,这使得使用Docker容器运行大型语言模型变得更加简单。有了Ollama,大型语言模型的所有交互都在本地进行,无需将数据发送给第三方服务。

进入 Ollama 服务对应的 pod 内部,执行 ollama run llama3 命令进行模型安装。若提前构建了模型的镜像并在部署步骤中进行了部署,则可省略此手动安装步骤。命令,即可获取模型对职场冲突处理相关问题的回答,展示了 Ollama 服务在 Kubernetes 环境中正常运行并能够对外提供大模型服务的能力。模型安装完成后,在 namespace 下的其他 pod 中可通过 curl

可以将邮件从服务器端完整地下载到本地,包括邮件的正文内容以及所有附件,确保信息的完整性。支持按照指定的文件夹前缀进行有针对性的邮件备份,方便用户根据自己的需求选择特定的邮箱文件夹进行备份操作。最新版本为 v0.3,不断在功能和稳定性上进行优化和提升。

在使用 NGINX 作为反向代理服务器时,尤其是在处理 AI 大模型的推理请求时,存在缓冲区引起的输出延迟问题。这篇论文探讨了如何通过禁用缓冲机制来解决反向代理过程中无法即时输出结果的问题。通过调整 NGINX 配置,确保数据流能够实时传输,解决了因输出被缓冲而导致的延迟和超时问题。

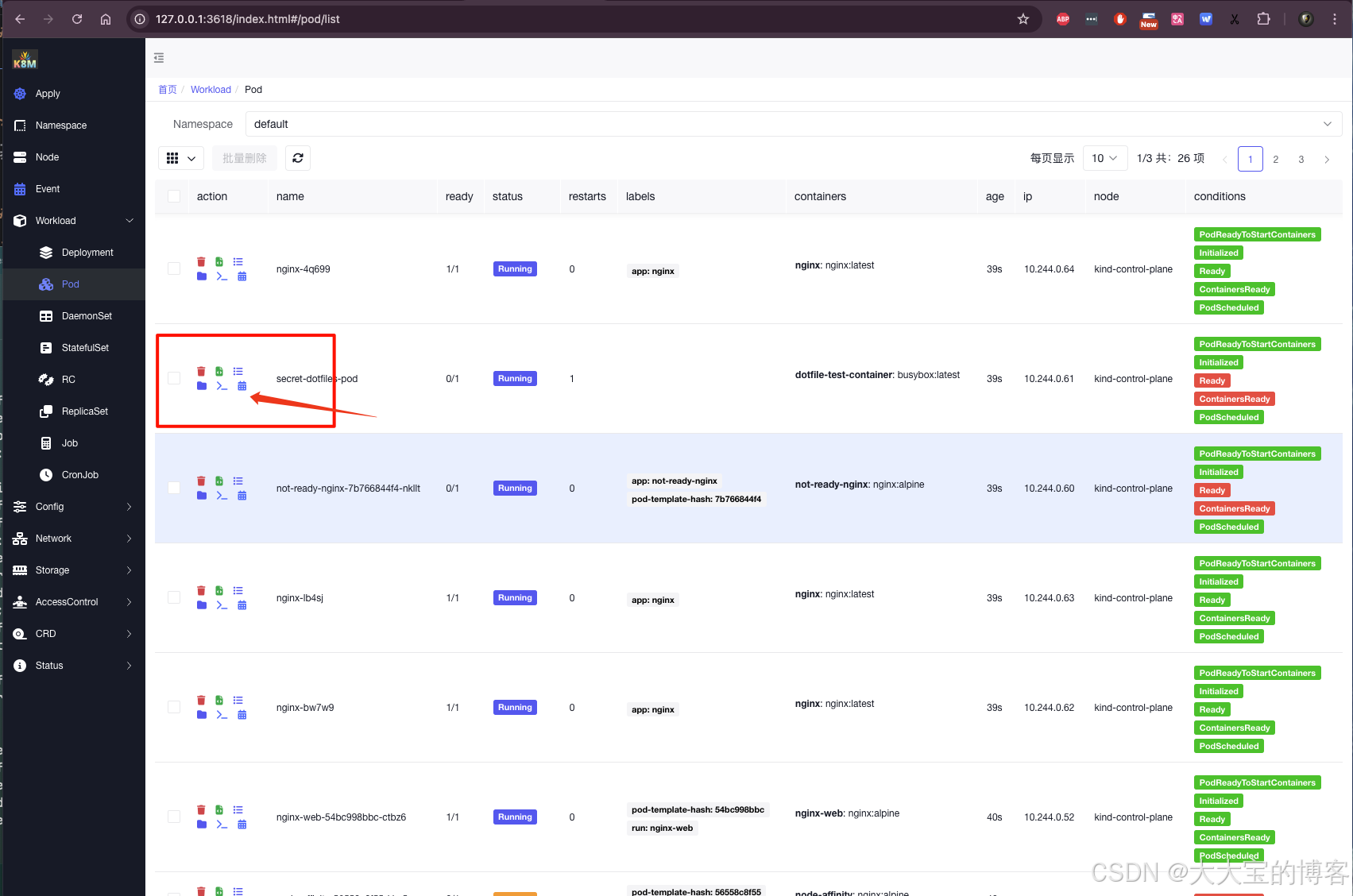

k8m是一款集 AI 与 Kubernetes 于一体的轻量级控制台工具,专为简化集群管理设计。基于 AMIS 构建,并通过 kom 作为 Kubernetes API 客户端,k8m内置了 Qwen2.5-Coder-7B 模型交互能力,同时支持接入您自己的私有化大模型。k8m作为一款结合 AI 和 Kubernetes 的工具,展现了其简洁高效的设计理念。从便捷的文件管理、日志诊断到智能化的