简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

torchrun:适合需要快速上手和简单配置的用户,适用于小规模分布式训练。accelerate:适合使用 Hugging Face 生态系统的用户,尤其是在 NLP 任务中,提供了较为便捷的分布式训练接口。deepspeed:适合对性能和规模有更高要求的用户,提供了丰富的优化功能,适用于大规模模型训练。不同工具的选择取决于具体的需求、模型规模、硬件环境以及用户对配置和优化的熟悉程度。Poe好的,

另外,我们也发现这些针对于C端提供的编程助手,在引入Agent以后,对整体的项目改动是没有严格边界的,有的时候会改动程序员不希望修改的很多文件,导致程序员并不知道自己的哪些项目被修改过。,同时需要紧贴着企业的软件开发框架,将企业内部那些稳定的、大量的业务逻辑和高频代码场景,利用AI的方式找出来并提取为Prompt体系,然后在用户输入的应用节点,以背景信息的形式、灵活的以智能化的方式提供给大模型,从

VITA-1.5 是一款开源的交互式多模态大型语言模型,实现接近实时的视觉和语音交互体验。相较于之前的VITA-1.0版本,VITA-1.5 在多个方面取得了显著进步。VITA-1.5 还采用了渐进式训练策略,确保在加入语音模态时,对其他多模态性能的影响最小化。该模型。

在插入新弹匣的瞬间,一发流弹几乎擦着TA的头飞过,迫使TA猛地一缩头 (6-7s)。的森林小径渐行渐远,她长发飘逸,乌黑顺直,浅色肌肤在自然光线下更显细腻。中景,跟随女子背影的视角,展现她融入。输入提示词“老虎怒吼后猛然冲向镜头,张口扑咬,巨大的身体掀翻树木,镜头剧烈晃动,模拟第一人称逃跑视角,穿越丛林,狂奔躲避追击,树枝划过镜头,恐惧与速度并存”看电影时,你忘了他是影帝,你沉浸到剧情里,忘了他是

2025年2月,前OpenAI和特斯拉AI团队领导者Andrej Karpathy在社交平台X上发布了一条引发广泛讨论的帖子,提出了"Vibe Coding"(感觉式编程)的概念。这一概念描述了开发者"完全沉浸在感觉中",依靠大语言模型(LLM)生成代码而无需理解输出的开发方式。短短两个月内,Vibe Coding迅速成为科技圈热门话题,甚至被美国韦氏词典收录为"俚语和流行词"。简单来说,Vibe

模型编辑是一个高效更新大模型内部所存储知识(如错误、过时和不安全知识)的技术。与微调相比,它的主要优势有两个:1.可以定向更新任意数量的知识(可少至几条),而不用担心过拟合、灾难性遗忘等问题。2.几乎是无需训练(Training Free)的,实时性强。一个很直观的问题是,在这个微调技术茁壮成长、层出不穷的时代,为什么我们需要模型编辑?上述俩个优势,到底会给它带来怎样的应用空间呢?叶问外传》中有一

大摩认为,正如聊天机器人需要文本数据来训练大语言模型(LLM)一样,物理机器人需要数据来训练其视觉-语言-动作模型(VLA),预计随着算力规模不断扩展且效率提升,AI公司需要大量的视觉数据来创建物理世界的“数字孪生”,视觉数据将成为AI巨头们的竞争焦点。这意味着,当AI技术成熟后,视觉数据将成为极其宝贵的资源。大摩预计,随着算力规模不断扩展且效率提升,AI公司需要大量的视觉数据来创建物理世界的“数

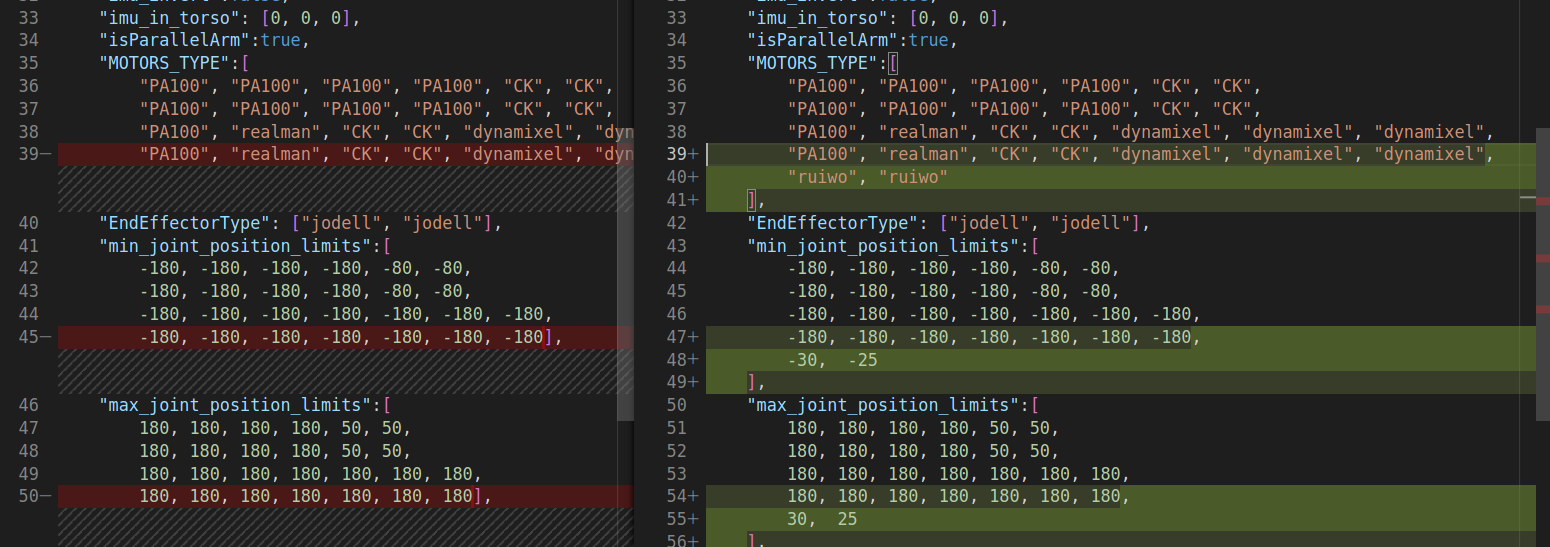

里面有一个基本的说明,在这个站立的示例程序里面用户可以尝试修改机器人躯干的 Yaw , Pictch 角来观察机器人的变化,可以修改执行距离地面的高度来调整机器人的站立高度。2.5 机器人站立之后,按下 r 键,机器人会进入基于速度的步态模式,进入步态之后默认各个方向速度为 0, 使用 a(左)d (右) w(前) d(后) 来改变在 x,y 轴上的速度,来控制机器人前后左右移动。2.7 结束调试

原创 Aitrainee2024年07月19日 07:43湖南Aitrainee | 公众号:AI进修生🌟用于开发 AI Web 代理的大型行动模型框架。Hi,这里是Aitrainee,欢迎阅读本期新文章。,这是一个用于开发AI网页应用的框架,它现在有了一些很酷的新更新,比如可以构建一个能够根据你的简历PNG自动申请工作的代理,这太疯狂了。以前它只能做一些简单的任务,但现在似乎变得更好了,不仅能

本文提出了Janus框架,通过解耦视觉编码路径来提升多模态理解与生成性能,并超越现有统一模型。论文题目: Janus: Decoupling Visual Encoding for Unified Multimodal Understanding and Generation论文链接: https://arxiv.org/abs/2410.10486PS: 欢迎大家扫码关注公众号^_^,我们一起在