简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

首先使用抽象基类(ABC)来定义所有 LLM 引擎包装器必须遵循的标准接口。这确保了一致性和可互换性。任何继承自EngineLM的类都必须实现generatepass在这里定义ChatVLLM类,它是EngineLM接口的具体实现。2\n```")print(f"\n'─'50'─'50")try:")raise eprint(f"\n'─'50'─'50")try:str100]try:在多智能

首先使用抽象基类(ABC)来定义所有 LLM 引擎包装器必须遵循的标准接口。这确保了一致性和可互换性。任何继承自EngineLM的类都必须实现generatepass在这里定义ChatVLLM类,它是EngineLM接口的具体实现。2\n```")print(f"\n'─'50'─'50")try:")raise eprint(f"\n'─'50'─'50")try:str100]try:在多智能

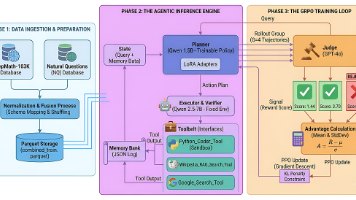

总结来说,OpenResearcher证明了完全可复现的离线轨迹合成能够作为训练有竞争力的深度研究智能体的坚实基础,不需要依赖专有搜索基础设施。

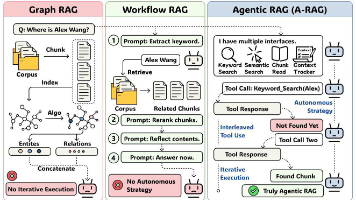

把决策权还给模型,才是 RAG 的未来一句话概括:A-RAG 通过设计分层检索接口(关键词、语义、文档块三个粒度),让大模型像真正的 Agent 一样自主探索知识库,在多跳问答任务上全面超越传统 RAG 方法,而且更省 token、更能利用测试时计算资源。与其设计复杂的检索算法,不如设计好用的检索接口,让模型自己决定怎么检索。就像给程序员提供好的 API 比写死的脚本更有用一样。

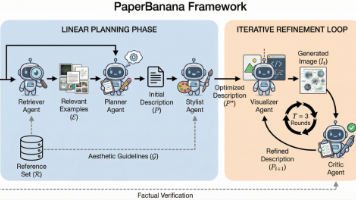

把科研插图生成拆解成"结构推理"和"美学渲染"两个独立阶段,通过迭代优化布局、精确控制文本,可以实现既准确又美观的publication-ready图片生成。这个工作的意义远不止是个好用的工具。它真正触及到了AI科学家的一个核心瓶颈——视觉表达能力。现在的AI已经能写论文、做实验了(比如AI Scientist-v2被ICLR接收),但没法把自己的发现画成图,这就像一个只会说话不会比划的人,表达力

下午刷到这篇PaperBanana的论文,讲真,这个方向确实戳中了AI科研圈的痛点。写论文最头疼的是什么?不是跑实验,不是调参数,而是画那些方法示意图和统计图表。每次到这个环节,PPT、Visio、Python matplotlib轮番上阵,改来改去,最后还是觉得不够professional。这次北大和谷歌的团队直接放大招,搞了个框架,专门解决学术插图自动化生成的问题。看完之后,第一反应是:这玩意

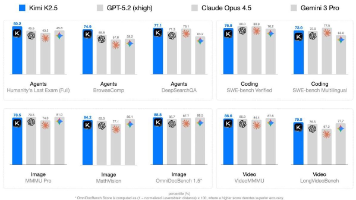

Kimi K2.5的核心让视觉和语言从训练之初就相互促进,并通过多智能体并行执行把AI从"单核串行"升级到"多核并行",从而在保持强大能力的同时实现了4.5倍的速度提升。多模态不是"拼接",而应该是"共生"智能体的未来不是单打独斗,而是协同作战。

大家还记得年初Meta以超过20亿美元的价格收购了Manus,同时Claude Code的运行规模也突破了10亿美元的年化收入。在这样的背景下,看看大模型智能体设计中都出现了什么共同的模式,就显得特别有意思。这篇文章汇总了许多有趣的博客、论文和讨论,希望能为大家梳理出一些规律。@RLanceMartin最近加入了@AnthropicAI,发表了一篇Agent设计和上下文管理的深度总结。这篇文章不是

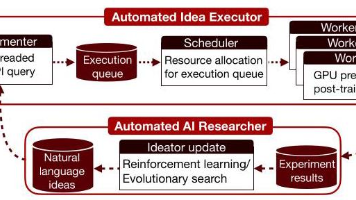

这篇论文做了一件很酷的事:把AI科研从"纸上谈兵"变成"实战演练"。他们搭建的自动化执行系统能让LLM真正把想法跑通、拿到结果、从反馈中学习。进化搜索证明这条路走得通——10轮搜索就能找到比baseline强很多的方案,甚至超过研究生课程的最佳学生作业。但也暴露了问题:除了Claude-4.5-Opus,其他模型很快就到瓶颈;强化学习更是只能提高平均分,最高分反而不涨,因为模型学会了抄近路、搞重复

DeepSeek-OCR 2解决的其实是个很实际的问题:以前模型读文档就像小学生,傻傻地从左上角一个字一个字往右下角扫,碰到复杂排版、公式、表格就懵了。现在它学会了像人一样,看到标题先读标题,看到图表就跳过去看图表,按照文档本身的逻辑来读,自然就更准了。而且它用的token更少、速度更快,在实际使用中重复率从6%降到4%——这意味着你让它识别PDF时,出错和胡说八道的情况明显少了。