简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文主要目的是将使用cann过程中的问题进行总结,希望能给各位开发者提供一些帮助。另外:2、希望更多的开发者同学们能参与到CANN的建设,

需要关注的是,如上4个文件。步骤一般是:算子yaml配置(op_plugin_functions.yaml/derivatives.yaml) ->算子适配实现(AbsKernelNpuOpApi.cpp/AbsKernelNpu.cpp)

Ascend Transformer Boost加速库(下文简称为ATB加速库)是一款高效、可靠的加速库,基于华为Ascend AI处理器,专门为Transformer类模型的训练和推理而设计。ATB加速库采用了一系列优化策略,包括算法优化、硬件优化和软件优化,能够显著提升Transformer模型的训练和推理速度,同时降低能耗和成本。具体来说,ATB加速库通过优化矩阵乘法等核心算子和注意力机制的

INSTALL_DIR”是CANN软件安装后文件存储路径,其中“/usr/local/Ascend”为root用户的默认安装路径,如果使用普通用户安装,或指定路径安装,请自行替换。“INSTALL_DIR”是CANN软件安装后文件存储路径,其中“/usr/local/Ascend”为root用户的默认安装路径,如果使用普通用户安装,或指定路径安装,请自行替换。“/usr/local/mpich”以

MindIE Service是面向通用模型场景的推理服务化框架,通过开放、可扩展的推理服务化平台架构提供推理服务化能力,支持对接业界主流推理框架接口,满足大语言模型的高性能推理需求。

总结一句话就是,自定义算子要准确的设置和这2个环境变量,否则会执行失败。

CANN(Compute Architecture for Neural Networks)提供了算子加速库(Ascend Operator Library,简称AOL)。该库提供了一系列丰富且深度优化过的高性能算子API,更亲和昇腾AI处理器,调用流程如图1所示。开发者可直接调用算子库API使能模型创新与应用,以进一步提升开发效率和获取极致模型性能。其中aclnnXxxGetWorkspaceS

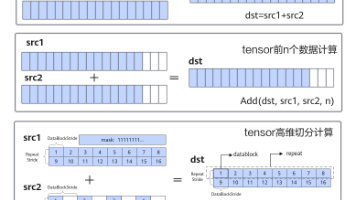

标量计算API,实现调用Scalar计算单元执行计算的功能。矢量计算API,实现调用Vector计算单元执行计算的功能。矩阵计算API,实现调用Cube计算单元执行计算的功能。数据搬运API,计算API基于Local Memory数据进行计算,所以数据需要先从Global Memory搬运至Local Memory,再使用计算API完成计算,最后从Local Memory搬出至Global Mem

CANN(Compute Architecture for Neural Networks)提供了算子加速库(Ascend Operator Library,简称AOL)。该库提供了一系列丰富且深度优化过的高性能算子API,更亲和昇腾AI处理器,调用流程如图1所示。开发者可直接调用算子库API使能模型创新与应用,以进一步提升开发效率和获取极致模型性能。其中aclnnXxxGetWorkspaceS