简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要: Anthropic推出的Claude大模型具备多模态理解、代码执行等能力,但限制中国用户访问。通过Poe平台可稳定使用Claude系列模型,包括高性能的Claude-Opus、中等的Claude-Sonnet和轻量级的Claude-Haiku。用户注册Poe后,可选择模型并通过网页或API调用,需替换生成的API密钥。平台支持订阅积分和客户端下载,便于国内用户使用。

1.摘要HunyuanVideo是一个全新的开源视频基础模型,其视频生成性能堪比领先的闭源模型,甚至超越它们。我们采用了多项模型学习的关键技术,通过有效的模型架构和数据集扩展策略,我们成功训练了一个拥有超过130亿个参数的视频生成模型,使其成为所有开源模型中规模最大的模型。部署环境为:linux服务器,GPU大小为64G。2. 安装。

训练成本低,但效果卓越。DeepSeek V3的参数量为671B,每个token激活 37B,支持上下文长度为128k。训练语料由14.8T高质量且多样化的token组成, 在2048个H800上训练了2.788M H800 GPU小时,耗时57天(2.788*1000000/2048/24=56.78天),用了558万美元。其所用的GPU训练资源仅为Llama 3.1 405B的差不多1/14,

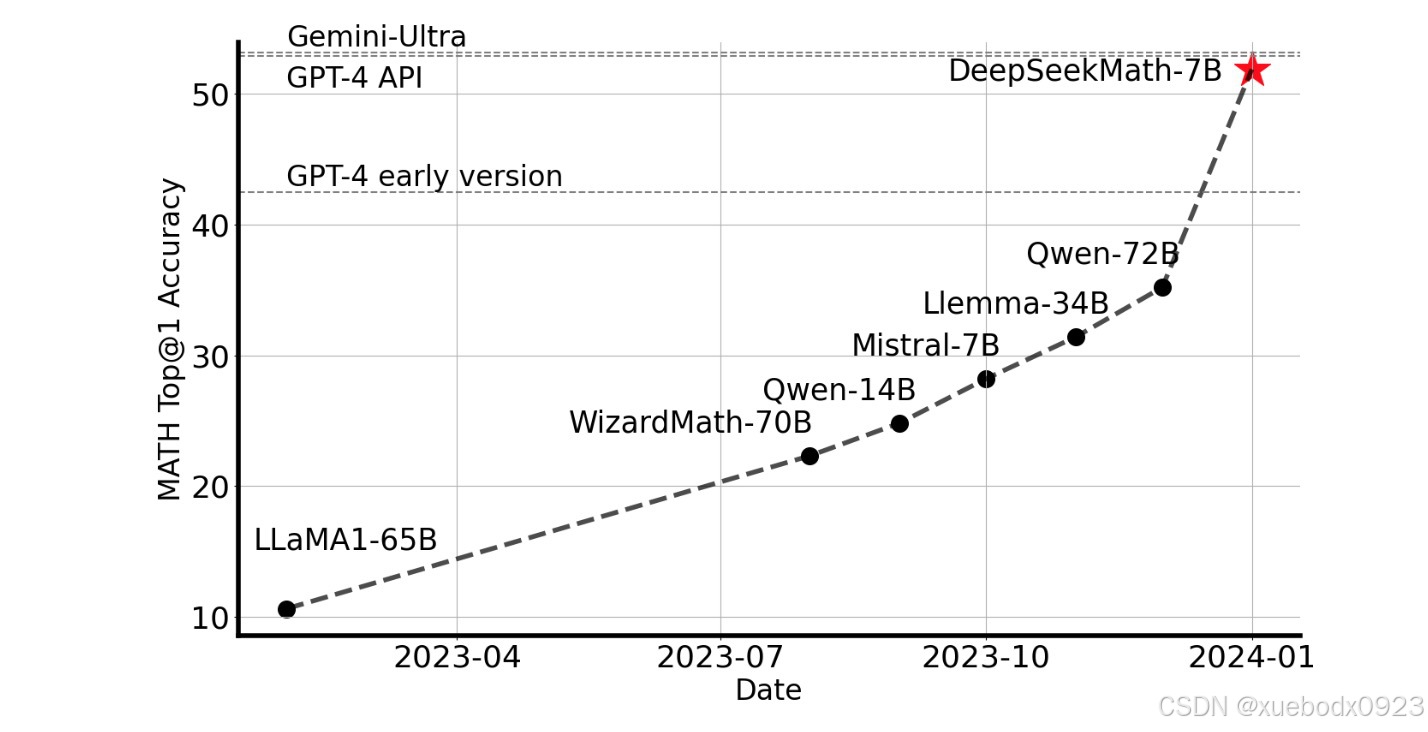

是DeepSeek推出的数学推理大模型,使用DeepSeek-Coder-v1.5-7B进行初始化,并继续对来自 Common Crawl 的数学相关tokens以及 500B 个tokens的自然语言和代码数据进行预训练。7B在不依赖外部工具包和投票技术的情况下,在竞赛级MATH基准上取得了令人印象深刻的51.7%的成绩,接近和GPT-4的性能水平。使用500B。

这是一系列先进的大型混合专家(MoE)视觉语言模型,比其前身DeepSeek-VL有了显著改进。DeepSeek-VL2在各种任务中都表现出卓越的能力,包括但不限于视觉问答、光学字符识别、文档/表格/图表理解和视觉基础。我们的模型系列由三个变体组成:DeepSeek-VL2-Tiny、DeepSeek-VL2-Small和,他们之间的主要区别在于基础LLM。基于DeepSeekMoE-3B 构建(

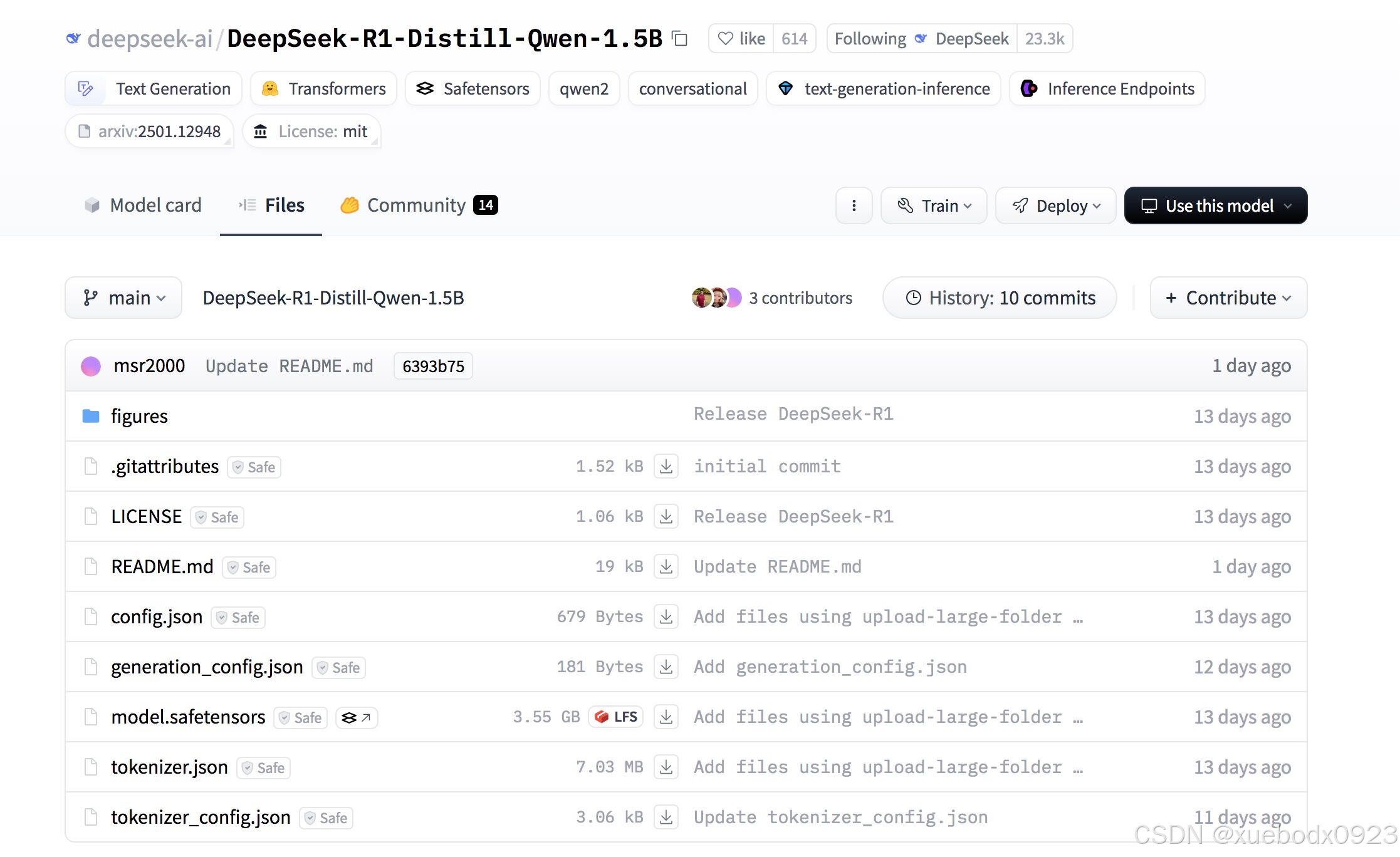

1. 摘要(发音为 "n-eight-n")是一个开源的图形化低代码工作流自动化工具,允许用户通过可视化界面连接不同的应用程序和服务,实现自动化任务。在linux服务器上,用docker安装n8n工作流自动化工具,用ollama私有化部署DeepSeek-R1-Distill-Qwen-1.5B。If you prefer to disable this security feature,set

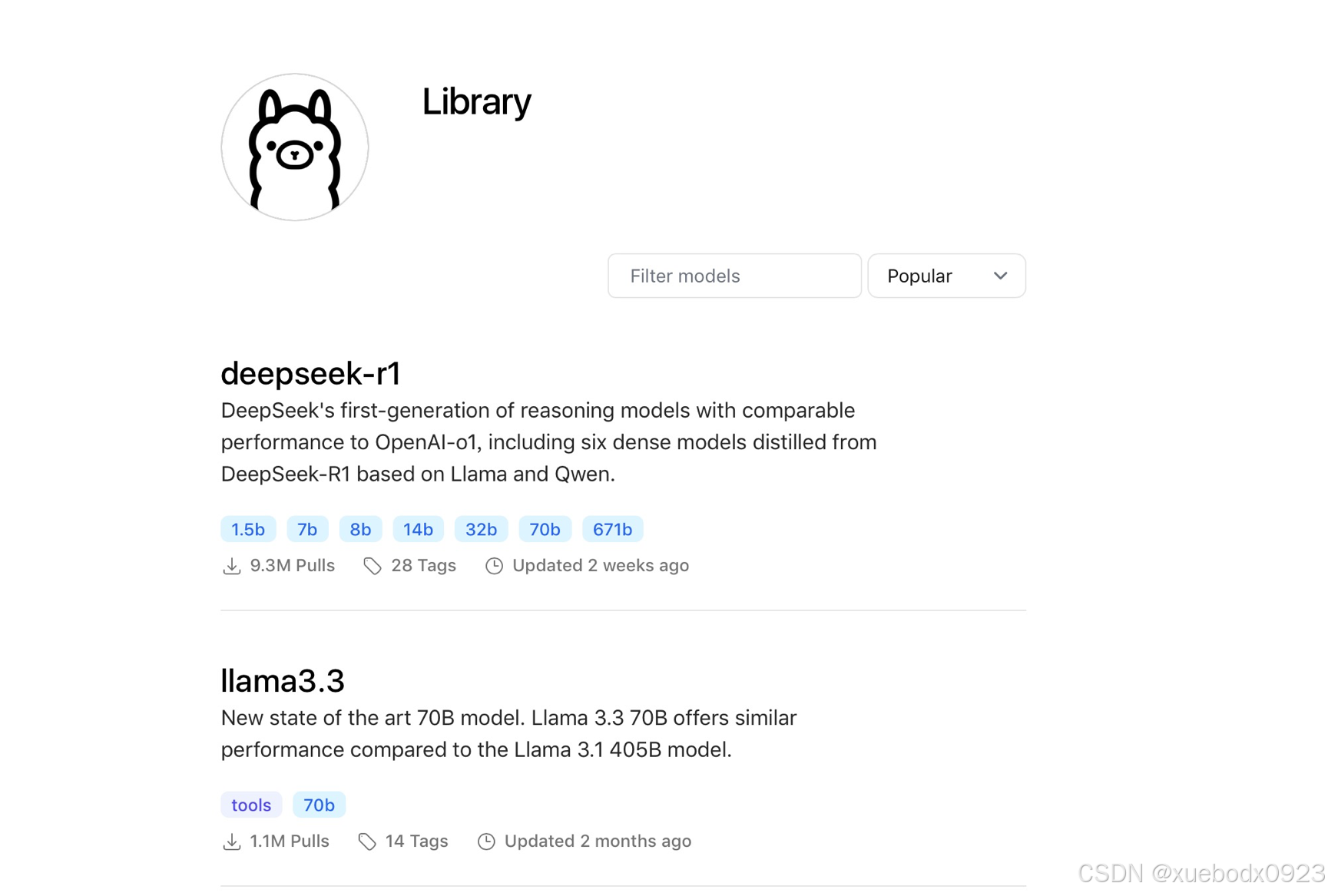

Ollama是一个基于 Go 语言的本地大语言模型运行框架,类 docker 产品(支持 list,pull,push,run 等命令),ollama将类似于镜像的大模型从中央仓库拉取到本地,可以把ollama看作,把ai大模型看作是镜像。DeepSeek,全称杭州深度求索人工智能基础技术研究有限公司。推出国产大模型DeepSeek-V3和DeepSeek-R1。总参数量为671B,激活37B。优

1. 摘要(发音为 "n-eight-n")是一个开源的图形化低代码工作流自动化工具,允许用户通过可视化界面连接不同的应用程序和服务,实现自动化任务。在linux服务器上,用docker安装n8n工作流自动化工具,用ollama私有化部署DeepSeek-R1-Distill-Qwen-1.5B。If you prefer to disable this security feature,set

1. 摘要(发音为 "n-eight-n")是一个开源的图形化低代码工作流自动化工具,允许用户通过可视化界面连接不同的应用程序和服务,实现自动化任务。在linux服务器上,用docker安装n8n工作流自动化工具,用ollama私有化部署DeepSeek-R1-Distill-Qwen-1.5B。If you prefer to disable this security feature,set

是伯克利大学LMSYS组织开源的大语言模型高速推理框架,旨在极大地提升实时场景下的语言模型服务的吞吐与内存使用效率。也正是因为如此,DeepSeek R1价格非常便宜,每100万个输出tokens 2.19美元,而 OpenAI o1 则需要60美元,DeepSeek R1便宜 96.4%,性能却不相上下,完全就是逆风翻盘。推出国产大模型DeepSeek-V3和DeepSeek-R1。由于硬件的限