简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了Pandas中字符串操作的主要方法,包括字符串访问器str的使用、字符串匹配查找、替换、分割连接以及格式化等核心功能。通过实际代码示例展示了如何对文本数据进行大小写转换、查找子串位置、正则匹配、分割字符串、连接列表元素等常见操作。特别提供了邮箱和电话号码处理的实际应用案例,演示了如何规范化这类常见数据格式。这些字符串处理方法为数据清洗和预处理提供了强大工具,能有效处理各类文本型数据。

JSON解析器(JsonOutputParser)是将大模型自由文本输出转换为结构化JSON数据的工具,适用于API调用等需要严格结构化输出的场景。它具有标准化输出、数据验证(Pydantic模型)和与提示模板集成的特点,通过get_format_instructions()方法指导模型输出JSON结构。示例代码展示了如何使用ChatPromptTemplate和JsonOutputParser,

本文详细介绍了LangChain框架中的流式调用、并行处理和Runnable组件三大核心技术。流式调用通过逐步返回结果提升用户体验,可使用stream()方法实现同步/异步调用。并行处理能同时运行多个任务,提高效率。Runnable组件(如RunnablePassthrough、RunnableLambda等)作为核心构建块,提供了灵活的链式组合能力。文章还对比了传统Chain与LCEL的差异,强

LangChain Chains 是 LangChain 框架中的核心概念之一,它代表了一系列组件的有序组合,这些组件可以依次处理输入并产生输出。Chains 提供了一种简单而强大的方式来构建复杂的 AI 应用程序,将不同的组件(如语言模型、提示词模板、工具等)连接在一起。可以把 Chains 想象成一条流水线,数据从一端进入,经过多个处理步骤,最终从另一端输出结果。每个处理步骤都可以是一个简单的

本文总结了多智能体系统(MAS)的6种经典设计模式: 顺序模式:智能体线性执行,适合明确顺序的任务,但效率较低且灵活性差。 路由模式:通过中央路由器动态分配任务,灵活性高但路由器可能成为瓶颈。 并行模式:任务分解并行执行,效率高但拆分合并开销大。 生成器模式:生成候选方案并验证,适合创意任务但迭代成本高。 网络模式:智能体网状协作,适应性强但管理复杂。 自主智能体模式:智能体独立决策,灵活性最高但

2. 安装## 2.1 项目地址。

指标数值投资建议买入置信度75.0%风险评分45.0%目标价位215.0维度评估结果新闻时效性高(当日盘后汇总,反映最新交易日表现)信息可信度高(东方财富权威来源,数据交叉验证)市场影响程度强(涉及资金、筹码、板块、ETF多维度)投资者情绪显著正面短期价格影响上涨5%-8%,目标165–170元长期价值影响正面强化,行业景气度支撑成长逻辑我选择买入当前风险已被市场过度定价,而增长潜力尚未充分反映在

Source(源):从外部系统读取数据Sink(汇):向外部系统写入数据本教程完整讲解了 Flink 1.20 自定义 SQL 连接器的开发:✅核心组件✅完整实现:HTTP 连接器的 Source 和 Sink✅实战示例:Flask API + Flink SQL 完整演示✅最佳实践:性能优化、容错处理、监控指标WebSocket 连接器MongoDB 连接器Redis 连接器企业内部系统连接器。

Memory 基础概念与应用 Memory是LangChain中存储对话历史与状态的核心组件,主要功能包括: 上下文维护:在多轮对话中保持连贯性 状态管理:记录任务执行进度和中间结果 个性化服务:存储用户偏好实现定制响应 核心操作包括: 通过save_context()保存对话记录 使用load_memory_variables()读取历史信息 调用clear()清除过期数据 典型应用场景: 个性

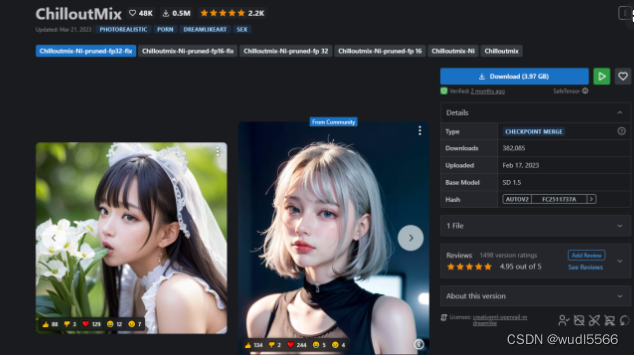

在这里插入图片描述](https://img-blog.csdnimg.cn/62235a718f8542c7a47b1779ed36ce7e.png。更多的模型下载 模型训练请加。