简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

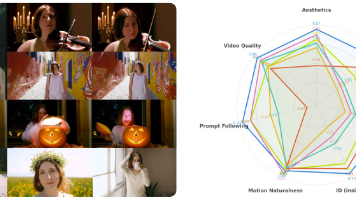

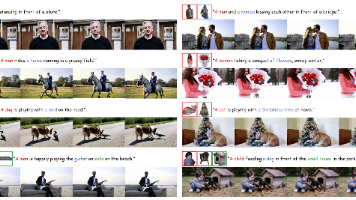

摘要: 字节跳动提出Lynx模型,实现了从单张图像生成高保真个性化视频。基于扩散Transformer(DiT),Lynx通过两个轻量适配器(ID-adapter和Ref-adapter)保持身份一致性:ID-adapter将人脸特征转换为身份token,Ref-adapter通过跨注意力注入VAE细节特征。在40个主体和20个提示的测试集上(共800个案例),Lynx在身份相似度、提示跟随和视频

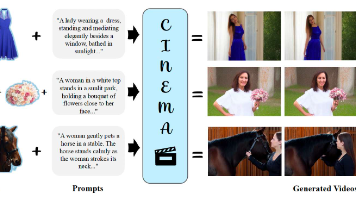

字节跳动提出的CINEMA框架通过多模态大语言模型(MLLM)实现多主体一致性视频生成,解决了现有方法在主体关系建模和视觉一致性方面的不足。该框架无需显式绑定主体图像与文本实体,利用MLLM解析主体间关系,显著提升了生成视频的连贯性。CINEMA采用模型无关设计,通过AlignerNet模块将MLLM输出对齐到文本特征,并注入参考图像的VAE特征保持主体一致性。实验表明,该方法在主体一致性和场景协

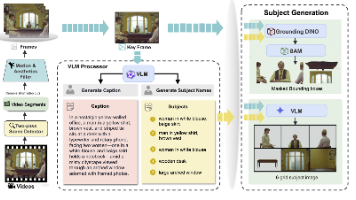

本文提出ID-COMPOSER框架,用于解决多主体视频生成中的身份保持、语义整合和时间一致性难题。该框架创新性地设计了分层身份保持注意力机制,通过主体内部、主体间和跨模态三个层次的特征聚合,有效维持多主体身份一致性;同时引入基于视觉-语言模型的语义理解模块,提升多主体交互的细粒度控制。此外,采用在线强化学习优化生成质量,并构建了专门的多主体视频数据集。实验表明,ID-COMPOSER在身份保持、视

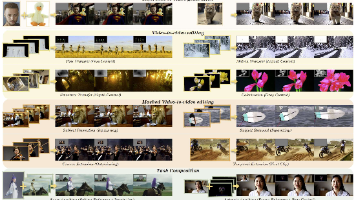

本文提出VACE,一种基于扩散Transformer的统一视频创作与编辑框架,支持多种视频任务(文本生成视频、参考生成视频、视频编辑等)的自由组合。通过设计的视频条件单元(VCU)统一接口和概念解耦策略,VACE能灵活处理多模态输入并保持时空一致性。实验表明该统一模型性能与专用模型相当,同时支持长视频重新渲染等创新应用,为视频内容创作提供了高效解决方案。

文章摘要 本文提出ConceptMaster,一种无需测试时微调的多概念视频定制(MCVC)方法。该方法解决了两个关键挑战:1) 身份解耦问题,通过独立注入解耦的多概念嵌入,有效区分相似概念的属性;2) 高质量数据稀缺问题,设计数据管线收集130万+跨领域视频-实体对。ConceptMaster采用查询Transformer提取视觉嵌入,结合解耦注意力模块保持概念唯一性,并通过独立的多概念注入器增

BindWeave提出了一种跨模态整合框架,通过多模态大语言模型(MLLM)实现主体一致性视频生成。该方法利用MLLM进行深层语义解析,将文本指令与视觉实体绑定,生成主体感知的隐状态来调控扩散Transformer。通过整合MLLM推理、CLIP语义特征和VAE细节特征,BindWeave在复杂多主体场景中实现了高保真且主体一致的视频生成。实验表明,该方法在OpenS2V基准上显著优于现有模型,为

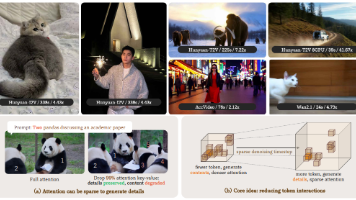

尽管视频扩散 Transformer(DiT)模型在生成质量方面表现出色,但其实际部署受到大量计算需求的严重限制。这种低效性主要源于两个关键挑战:一是自注意力机制在 token 长度上的二次复杂度,二是扩散模型本身的多步生成特性。为了解决这些问题,我们提出了 Jenga,这是一种新颖的推理流程,结合了动态注意力剔除与渐进式分辨率生成策略。我们的方法基于两个关键洞察:(1)在扩散的早期阶段,不需要高

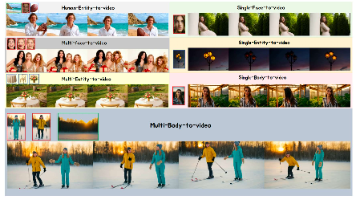

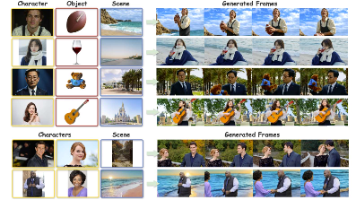

本文提出SkyReels-A2框架,实现了基于多参考图像和文本提示的可控视频生成。该框架通过双流结构处理参考图像:语义分支提取全局特征,空间分支保留局部细节。作者构建了"文本-参考-视频"三元组数据集,并设计了A2-Bench评估基准。实验表明,该方法能生成高质量、元素一致的自然视频,性能优于现有闭源模型。SkyReels-A2是首个开源的商用级元素到视频生成模型,为创意应用提

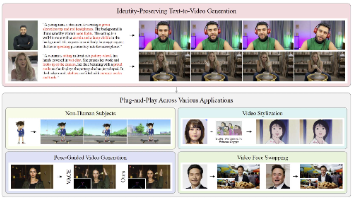

本文提出Stand-In,一种轻量化的即插即用身份控制框架,用于视频生成中的身份保持。该方法通过引入条件图像分支和受限自注意力机制,仅需训练约1%的额外参数(2000对数据)即可实现高质量身份保持。创新性地利用预训练VAE将条件图像映射到视频潜空间,通过3D RoPE位置编码区分图像和视频token。实验表明,该方法在面部相似度和自然度上均优于全参数训练方法,并能无缝集成到主体驱动生成、风格化、人

在下游任务上对大型预训练语言模型进行微调已成为 NLP 中的重要范例。然而,常见的做法是对预训练模型中的所有参数进行微调,当存在大量下游任务时,这种方法变得难以实施。因此,提出了许多微调方法,以参数高效的方式学习预训练权重的增量更新,例如低秩增量。这些方法通常将增量更新的预算均匀分布在所有预训练权重矩阵中,而忽略了不同权重参数的不同重要性。因此,微调性能不是最优的。为了弥补这一差距,我们提出了 A