简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

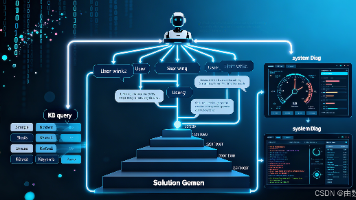

Moltbot是一款能操作电脑的开源AI智能体,通过自然语言接受指令后,可自主执行信息整理、跨平台通信、内容创作等任务。你可通过本地部署与消息App交互,或选择云服务套餐快速使用。搭建时需重点配置AI模型大脑与消息通道,并务必严守本地运行、强认证等安全准则,防范未授权访问风险。

AISkills(AI技能)是模块化、可组合的AI功能单元,专注于完成特定任务。它具有专业化、可组合性、接口标准化和上下文感知等特点,区别于传统AI模型。AISkills可应用于内容创作、数据分析、客户服务、开发运维和业务流程自动化等多个领域。使用方式包括调用现有平台API或集成到现有系统。搭建AISkills需要经过需求分析、技术选型、技能开发、测试评估和部署监控五个步骤,遵循单一职责、接口标准

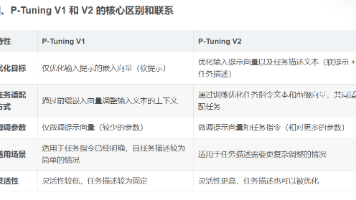

PromptTuning是一种高效的自然语言处理技术,通过优化输入提示(而非模型参数)来适配下游任务。主要包括硬提示(人工设计)和软提示(可训练向量)两种方式。P-TuningV1通过可训练前缀向量实现任务适配,而P-TuningV2进一步优化任务指令文本,提升灵活性但增加计算量。两者都基于提示优化思想,但P-TuningV2在任务理解能力上更优,适合需要调整任务描述的复杂场景。这些方法显著减少了

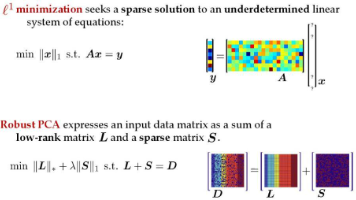

摘要:低秩技术在大模型中的应用聚焦于模型压缩与加速,通过矩阵分解(如SVD、PCA)减少参数规模,保持性能的同时降低计算成本。在Transformer中,低秩近似(如Linformer)将自注意力复杂度从O(N²)降至O(N),并与剪枝技术结合优化模型冗余。此外,低秩方法还支持动态计算调整、大模型蒸馏(如BERT/GPT优化)及生成式模型效率提升,显著增强模型在资源受限环境中的适用性。核心价值体现

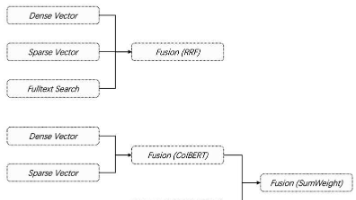

本文对比了稀疏向量与稠密向量的特点及其在RAG(检索增强生成)中的应用。稀疏向量(如BM25)通过高维稀疏表示实现精确关键词匹配,但缺乏语义理解;稠密向量(如BERT嵌入)则通过低维稠密编码捕捉语义相似性。在RAG中,稠密向量因其强大的语义理解能力成为核心检索机制,而稀疏向量作为补充处理精确匹配需求。当前趋势是采用混合检索策略,结合两者优势:通过算法(如RRF)融合语义相关性和关键词匹配结果,显著

Spacy和TorchText是两大主流NLP处理库,各具特色。Spacy专注于工业级文本处理,提供词性标注、命名实体识别等高效功能,支持多语言及深度学习模型集成。TorchText专为PyTorch设计,擅长文本数据加载、预处理及嵌入生成,适用于深度学习任务中的批处理和数据增强。两者分别对应NLP工程实现和深度学习训练两大场景,开发者可根据具体需求选择使用。

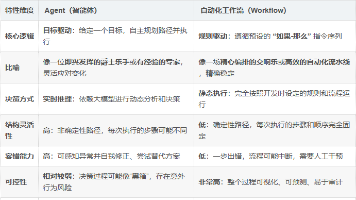

智能体(Agent)与自动化工作流(Workflow)的核心差异在于:智能体是目标驱动的自主决策系统,具有高灵活性和实时推理能力,适合处理不确定性的复杂任务;而工作流是规则驱动的固定流程,稳定性强但灵活性低,适合标准化重复性任务。未来趋势是二者融合,形成"工作流为骨架、智能体为大脑"的混合架构,兼顾流程可控性与智能决策能力。选择时应根据任务特性:规则明确选工作流,需灵活判断则用

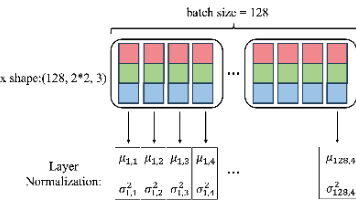

BatchNormalization(BN)和LayerNormalization(LN)都是用于标准化神经网络激活值的技术,但二者在归一化维度和适用场景上存在显著差异。BN沿着批处理维度进行标准化,适合图像任务(如CNN),但对batch size敏感;LN则在特征维度进行归一化,适用于NLP和Transformer等序列建模任务,且不受batch size影响。主要区别包括:BN训练/测试行为

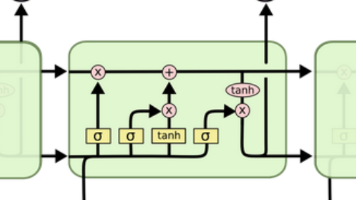

LSTM(长短期记忆网络)深度解析:本文详细剖析了LSTM的内部结构和参数机制,重点阐释其如何通过细胞状态和门控系统解决RNN的长期依赖问题。LSTM通过遗忘门、输入门、输出门三个可控单元(均采用Sigmoid激活)和tanh激活的候选值,实现对信息的精细化调控。其核心在于细胞状态的加法更新公式C_t=f_tC_{t-1}+i_tg_t,这种设计既保留了长期记忆又维持了梯度稳定。文章还计算了参数总

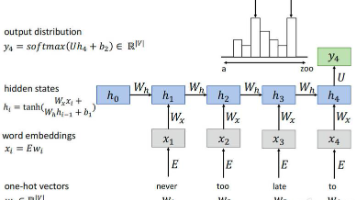

传统RNN通过单一隐藏状态ht传递序列信息,其计算过程为ht=tanh(Wxhxt + Whh ht-1+bn),但长序列中易因梯度连乘导致信息丢失;而LSTM引入细胞状态Ct作为长期记忆载体,通过遗忘门ft、输入门it和输出门ot构成的门控机制选择性调控信息流,使隐藏状态ht = ot ⊙tanh(Ct)仅输出与当前相关的短期信息,从而有效解决梯度消失问题并捕捉长期依赖;因此,RNN适用于短