简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

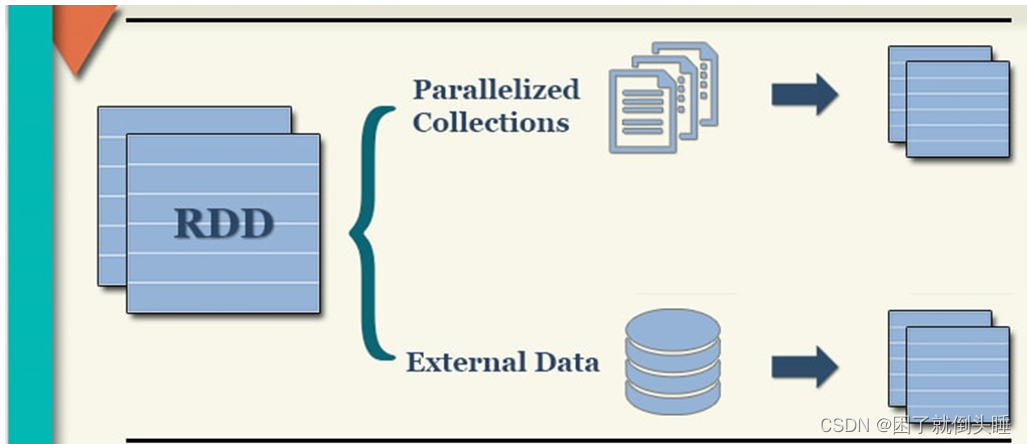

RDD:英文全称Resilient Distributed Dataset,叫做弹性分布式数据集,代表一个不可变、可分区、里面的元素可并行计算的分布式的抽象的数据集合。Resilient弹性:RDD的数据可以存储在内存或者磁盘当中,RDD的数据可以分区Distributed分布式:RDD的数据可以分布式存储,可以进行并行计算Dataset数据集:一个用于存放数据的集合。

bashrc 也是看名字就知道, 是专门用来给 bash 做初始化的比如用来初始化 bash 的设置, bash 的代码补全, bash 的别名, bash 的颜色. 以此类推也就还会有 shrc, zshrc 这样的文件存在了, 只是 bash 太常用了而已.其实看名字就能了解大概了, profile 是某个用户唯一的用来设置环境变量的地方, 因为用户可以有多个 shell 比如 bash, s

Spark天然支持集成Kafka, 基于Spark读取Kafka中的数据, 同时可以实施精准一次(仅且只会处理一次)的语义, 作为程序员, 仅需要关心如何处理消息数据即可, 结构化流会将数据读取过来, 转换为一个DataFrame的对象, DataFrame就是一个无界的DataFrame, 是一个无限增大的表。1- 放置位置一: 当spark-submit提交的运行环境为Spark集群环境的时候

标签: 是某一种用户特征的符号表示标签体系: 把用户分到多少类别里面去, 这些类是什么, 彼此之间有什么关系, 就构成了标签体系标签解决的问题: 解决描述(或命名)问题以及解决数据之间的关联。

—>点击主文件夹的其他位置的计算机,找到user文件夹打开后,找到local文件夹打开后,找到src文件夹打开,找到刚刚发送的nginx软件包,注意这里的(user/local/src/软件包)路径是可以根据要求来变化的。——>输入命令useradd-u900nginx-gnginx-s/sbin/nologin后回车,创建一个新用户,用户名为nginx,UID设置为900,所属用户组为nginx

1- 什么使用使用select(),什么时候使用groupBy()+agg()/select()实现聚合?如果有分组操作,需要使用groupBy()+agg()/select(),推荐使用agg()3- F.col(): 对于在计算过程中临时产生的字段,需要使用F.col()封装成Column对象,然后去使用。需求四: 查询高分电影中(电影平均分大于3)打分次数最多的用户, 并且求出此人所有的打分

该错误需要查看Hadoop的源代码(131行):https://gitee.com/highmoutain/hadoop/blob/trunk/hadoop-mapreduce-project/hadoop-mapreduce-client/hadoop-mapreduce-client-core/src/main/java/org/apache/hadoop/mapred/FileOutputF

远程连接方案, 允许所有的程序员都去连接远端的测试环境, 确保大家的环境都是统一的, 避免各种环境问题的发生,而且由于是连接的远程环境, 所有在pycharm编写代码 都会自动上传到远端服务器中, 在执行代码的时候, 相当于是直接在远端环境上进行执行操作。可以配置为Base环境,也可以配置为其他的虚拟环境, 但是目前建议配置为Base环境,因为Base环境自带python包更全面一些。Standa

sql = "insert into student(name,gender,age) values(%s,%s,%s)"# 不管什么类型的数据,都是使用%s替换。# sql = "insert into student(name,gender,age) values(%s,%s,%d)"# 错误。insert into student(name, gender, age) values ('赵雪

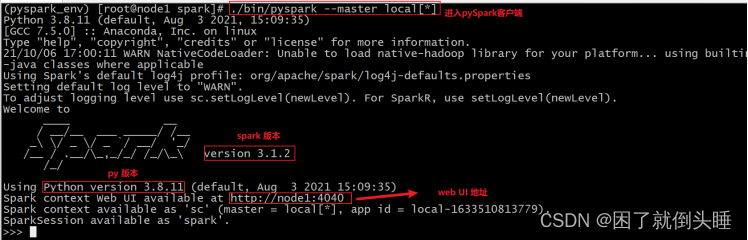

Apache Spark是用于大规模数据(large-scala data)处理的统一(unified)分析引擎。