简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

你是否好奇,大模型和数据集成平台能擦出怎样的火花?

Apache SeaTunnel MCP Server,可以将 SeaTunnel 的接口文档提供给 Cursor 等支持 AI 编程的 IDE,或其他支持 MCP 的 AI 工具。是一种基于MCP协议的服务器,旨在为大型语言模型(LLM)提供与外部数据源和工具的无缝集成。它通过标准化AI系统与数据源的交互方式,帮助模型获取更丰富的上下文信息,从而生成更准确、更相关的响应。。

Apache SeaTunnel 2.3.7 的发布,是我们持续提升产品性能和用户体验的重要一步。通过新增功能、优化现有功能以及修复已知问题,我们希望为用户提供更好的数据集成和处理体验。同时,我们也期待有更多的用户和开发者加入到 SeaTunnel 社区中来,共同推动这个开源项目的发展。欢迎下载 SeaTunnel 2.3.7 版本,体验最新功能和改进。如果您在使用过程中有任何问题或建议,欢迎随时

这次在 6月 Meetup 为大家带来的是Scaleph 基于 Apache SeaTunnel (Incubating) 的数据集成介绍,希望你有所收获。本次演讲主要包括五个部分:Apache SeaTunnel (Incubating) 王奇Apache SeaTunnel Contributor搜索推荐工程师,大数据 Java 开发我最早是从事搜索推荐工作,在团队里面负责维护Dump系统,主

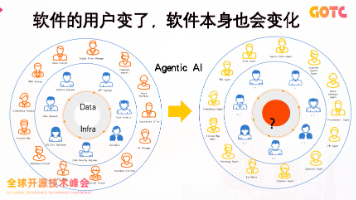

在软件世界中,用户的形态正在发生变化。

(记录时间非常重要,实现代码的时候,是 2025 年 6 月,当下 AI 的发展是每个月一变,到现在 2025 年 10 月,AI Agent 模式已经可以覆盖更加底层,更加复杂的需求了。就像做 SQL 引擎之间的转换的时候,可以考虑用抽象语法树的方式来做。就像 CPU 很快的时候,硬盘就会成为瓶颈,迭代产品目标的过程中,我们每次的功能验证就是瓶颈,所以我们要有意识地加快功能验证的步骤,比如我在开

无论是甲方还是乙方,我们在采集数据进行数仓模型建设时,企业的ERP一旦切换到SAP系统中,**安全挑战问题在于:**传统数仓模式离线接入SAP HANA,对于多集团公司又涉及到数据权限和隔离等安全问题,一般集团大型企业不太会开放HANA数据库进行接入,同时SAP的业务表逻辑也比较复杂;**技术门槛在于:**我们要有对应的java开发工程师,每一个数据表就要开发一个接口,而且接口的传输速度也很慢,

本文通过 Apache SeaTunnel + Amazon Bedrock + Amazon OpenSearch 的组合,构建了一套高可扩展性、低耦合的语义搜索数据处理链路,成功实现了从结构化/非结构化文本数据到向量检索系统的全流程集成。松耦合架构设计:SeaTunnel 的插件式 Transform 和 Sink 机制,使得模型调用与向量写入逻辑保持解耦,方便后续替换嵌入模型或变更底层向量数

在本次活动中,白鲸开源申报的「SeaTunnel MCP Server:分布式数据集成能力的“神经中枢”」案例成功入选《中国信通院开源商业产品及企业典型案例集(2025)》,并获得主办方颁发的奖牌。

向量数据库是一种专门用于存储和检索向量数据的数据库系统:• 它能够高效处理高维向量数据,支持相似性搜索• 支持KNN(K-近邻)搜索• 计算向量间的距离(欧氏距离、余弦相似度等)• 快速检索最相似的向量• 主要用于AI和机器学习应用场景• 图像检索系统• 推荐系统• 自然语言处理• 人脸识别• 相似商品搜索。