简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

YOLO26小目标检测技术针对遥感、工业和交通场景进行了优化适配。研究背景显示,小目标检测在多个领域具有重要应用价值,但面临特征丢失、样本失衡等挑战。YOLO26通过STAL标签分配和ProgLoss训练策略进行优化,并针对不同场景特点采用差异化配置:遥感场景增强感受野和上下文融合,工业场景注重细节保留和高精度定位,交通场景优化实时性和跟踪辅助。核心代码实现了场景自适应的网络架构和数据增强策略,包

YOLO26边缘部署技术通过模型量化、剪枝、知识蒸馏和算子优化等策略,显著提升了在嵌入式设备上的运行效率。实验表明,优化后的YOLO26n-Edge在树莓派4上达到8FPS,功耗仅5W;在Jetson Nano上实现22FPS;高端手机芯片上可达50FPS。该技术有效解决了边缘设备计算资源受限、内存容量小、功耗限制等挑战,为低功耗边缘计算场景提供了高效的AI推理方案。

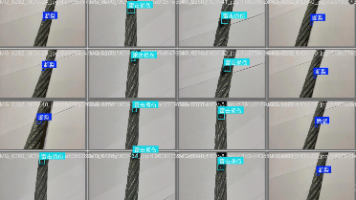

本文介绍了一个专注于电缆损坏识别的目标检测数据集,包含约1300张高质量图像,涵盖电缆断裂和雷击损伤两类故障。数据集已按训练、验证和测试集划分,采用YOLO格式标注,可直接用于主流检测模型训练。文章详细分析了数据特征、标注质量和类别分布特性,并提供了模型训练建议和参数配置。该数据集适用于无人机电力巡检、智慧电网故障预警等场景,通过结合深度学习算法可显著提升电力设备智能巡检效率。虽然数据规模不大,但

本文介绍了一个基于YOLOv8的脑肿瘤识别系统,该系统通过深度学习技术实现了对医学影像中脑肿瘤的自动检测和定位。项目从数据集构建、模型训练、系统集成到性能评估,形成了完整的解决方案。

在 2026 年的职场环境下,AI 高效办公到底意味着什么?答案已经越来越清晰:它不是简单地“学会几个工具”,也不是熟记几条提示词公式,而是完成一次认知层面的结构升级。AI 正在成为通用计算接口,真正拉开差距的,是谁能把它嵌入自己的工作流程,构建可复用、可扩展、可自动执行的生产力系统。从提示词工程到智能体封装,从对话式编程到自动化脚本落地,从单点工具使用到多工具协同闭环,本质都是在做一件事——把“

YOLO26训练策略详解:优化目标检测性能的关键技术 摘要: YOLO26通过创新的训练策略显著提升了目标检测性能。该策略采用300个epoch的渐进式训练,划分为预热(0-3 epoch)、早期(4-50)、中期(51-150)和后期(151-300)四个阶段。核心创新包括:1)渐进式余弦学习率调度,结合预热阶段;2)动态损失权重调整,逐步平衡分类与回归任务;3)阶段化数据增强策略,从基础Mos

小麦作为全球最重要的粮食作物之一,其产量与品质直接关系到粮食安全与农业经济稳定。然而,在实际种植过程中,小麦极易受到多种病害的侵袭,尤其是在气候变化加剧、极端天气频发的背景下,病害的发生时间更早、传播速度更快、影响范围更广。

总体而言,本无人机行人精准检测数据集在数据完整性、标注规范性、应用针对性与工程可落地性等方面均具备较高水准。它既可以作为目标检测算法学习与研究的实践数据集,也可以作为无人机智能视觉系统开发中的基础训练资源。随着应用场景的不断拓展与数据持续迭代,该数据集还具备进一步扩展为多场景、多时段无人机行人感知数据体系的潜力。

本项目提供了一套基于YOLOv8的蜜蜂目标检测系统,结合了高质量的蜜蜂数据集、完整的源码、训练流程和PyQt5界面,支持用户快速进行蜜蜂目标检测任务。通过该项目,用户可以在不同的应用场景中进行蜜蜂监测与识别,助力农业监控、生态研究等领域。

摘要 本项目基于YOLOv8算法开发了一套电缆损坏智能检测系统,可识别电缆断裂和雷击损伤两类典型故障。系统包含完整训练流程、1300张标注数据集、PyQt5图形界面及开箱即用的检测程序,支持图片、视频和实时摄像头输入。项目亮点包括高精度检测、多模态输入支持、可视化操作界面以及可定制化训练功能。通过深度学习技术实现电缆故障自动识别,为电力巡检提供高效可靠的解决方案。配套完整源码、预训练权重和详细教程