简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

OpenCodeReasoning-Nemotron-32B 是一个基于 Qwen2.5-32B-Instruct 开发的大型语言模型,专为代码生成推理任务优化,支持 32,768 个标记的上下文长度,适用于商业和非商业用途。该模型在 LiveCodeBench 和 CodeContest 等基准测试中表现出色,尤其在代码生成任务中展现了强大的推理能力。其核心优势包括长上下文支持、硬件优化(专为

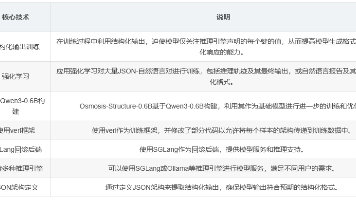

《Osmosis-Structure-0.6B:专精结构化输出的小型语言模型》 摘要:Osmosis-Structure-0.6B是一款专为结构化输出设计的0.6B参数小型语言模型。该模型通过独特的训练方法,在保持推理能力的同时确保了输出格式的规范性。在数学推理等任务中表现出色,在部分基准测试中可使GPT-4.1等模型的性能提升高达1322%。基于Qwen3-0.6B构建,采用强化学习训练50万组

vLLM(虚拟语言模型)是一个专为大规模语言模型设计的高性能推理引擎,尤其针对使用Transformer架构的模型,如GPT系列、Qwen等。VLLM旨在解决大模型在推理阶段的性能瓶颈,通过多种优化技术和策略,它能够提供高吞吐量、低延迟的文本生成服务。

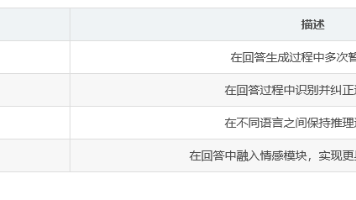

Dhanishtha-2.0是由HelpingAI团队开发的全球首款具备中间思维能力的AI模型。该模型基于Qwen3-14B架构,支持39种语言,具有自我修正和多阶段推理能力,可展示详细思考过程。核心技术包括中间思维模块、结构化情感推理和多语言一致性处理。适用于复杂问题解决、教育辅助和研究支持等场景,但存在回答冗长、生成时间较长等限制。模型通过16天训练,在MMLU、HumanEval等基准测试中

Ubuntu22.04, Python 3.12, Pytorch 2.5.1,CUDA 12.1, cuDNN 8, NVCC, VNC, QwQ-32b,QwQ-32B模型,Ollama。

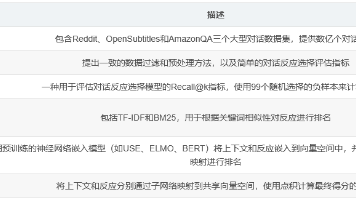

本文介绍了一个大型对话数据集仓库,包含Reddit、OpenSubtitles和AmazonQA三个主要数据集,总计超过10亿个对话示例。这些数据以标准化的TensorFlow格式存储,包含对话上下文和反应特征,适用于训练对话系统。论文详细描述了数据集构建流程、预处理方法和评估框架,提出了1-of-100准确度的Recall@k评估指标。实验部分比较了关键词匹配、预训练嵌入和专用编码器等基线方法,

SV4D 2.0是一种改进的多视图视频扩散模型,能够从单目视频生成高质量动态3D资产。相比前代,它在处理遮挡、大运动和真实世界视频泛化方面表现更优,通过优化网络架构、数据处理和训练策略,显著提升了时空一致性和细节质量。实验表明,SV4D 2.0在合成数据集和真实视频上都优于基线方法,成为4D生成领域的重要进展。

本文提出LongWriter-Zero,一种基于强化学习的超长文本生成方法,无需依赖标注数据。通过Group Relative Policy Optimization算法和复合奖励模型(包括长度、写作质量和格式奖励),该方法有效解决了长文本生成中的连贯性退化等问题。实验表明,在WritingBench和Arena-Write基准测试中,LongWriter-Zero优于传统监督微调方法和1000亿

它涵盖了人工智能的各个方面,包括机器学习、自然语言处理、计算机视觉、知识表示与推理、多智能体系统、机器人学等。7.ICCV International Conference on Computer Vision (ICCV) ICCV也是世界顶级的计算机视觉会议之一,虽然它是两年举办一次,但每届都吸引了大量的计算机视觉领域的研究者参与,展示了该领域的最新研究成果和技术进展。它是机器学习领域的顶级会

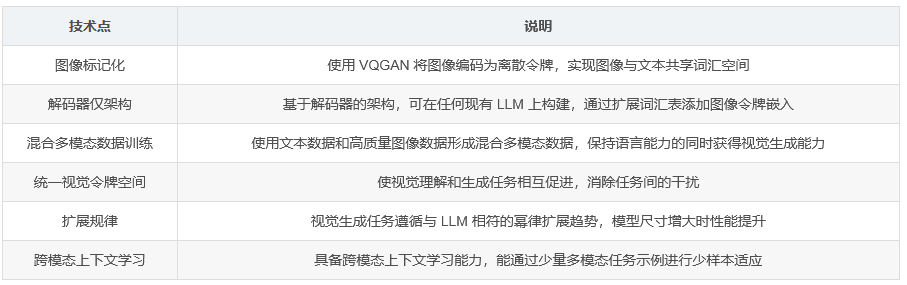

论文提出 Liquid,一种自回归生成范式,通过将图像和文本都转化为离散代码并在共享特征空间中学习,实现视觉理解和生成的无缝集成。与以往多模态大语言模型(MLLM)不同,Liquid 仅使用一个大型语言模型(LLM),无需外部预训练的视觉嵌入(如 CLIP)。研究发现,随着模型尺寸增大,视觉与语言任务统一训练导致的性能下降会减弱。Liquid 还能相互增强视觉生成与理解任务,消除早期模型中的干扰问