简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

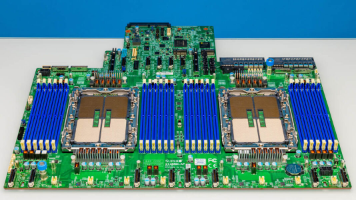

摘要:现代服务器主板正从标准化ATX/EATX形态转向深度定制化设计,以超微X14DBM-AP为例,其专为Hyper系列服务器优化,采用MCIO接口、模块化供电和OCP NIC 3.0等创新设计。这种演变源于12通道DDR5内存、PCIe Gen5信号完整性等需求,以及提升密度、可靠性和维护效率的需求。服务器主板正通过模块化架构、灵活通道分配和标准化扩展,更好地适应AI与高性能计算场景,展现了与消

随着2024年世界人工智能大会(WAIC 2024)在上海的圆满落幕,我们见证了人工智能技术的又一次飞跃。本次大会以“以共商促共享,以善治促善智”为主题,汇聚了全球顶尖的智慧,共同探讨了AI技术的未来趋势和应用前景。以下是我们为您精心整理的本次大会的亮点与趋势,希望能够为您的视野增添一抹亮色。

不同规模的 DeepSeek-R1 模型对硬件需求差异巨大。从轻量级的 1.5B 到顶级超大型的 671B,硬件配置需要根据模型规模、计算需求和预算进行选择。无论是个人开发者还是企业用户,都可以根据本文的推荐找到适合自己的硬件方案,高效部署 DeepSeek-R1 模型。希望这篇文章能帮助你在搭建 AI 运算站的道路上少走弯路。如果在部署过程中遇到问题,欢迎在评论区留言交流,让我们一起攻克难题!想

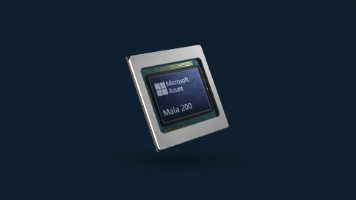

作为微软 Maia GPU 系列的第二代产品,Maia 200这款芯片从一开始就被明确定位为面向 AI 模型推理的专用加速器,而非通用训练 GPU。

H100与GH200并非替代关系,而是针对不同负载场景的互补方案:●H100是一款平衡型通用加速器,在训练、微调、推理等多种场景中表现稳定,计算密度高且部署灵活,是当前大多数AI与HPC负载的优选方案。●GH200是一款针对性极强的系统级解决方案,聚焦内存密集、CPU-GPU协同紧密的细分场景,能够突破传统分离式架构的瓶颈,为特殊负载提供更优性能。

随着大模型训练与推理规模的快速膨胀,网络互联架构已成为算力基础设施的核心瓶颈之一。以太网(Ethernet)与InfiniBand(IB)作为两种主流高性能互连方案,正朝着不同路径进化,同时也在逐步靠近。

超微基于AMD Turin架构的双路A+服务器AS-2126HS-TN——这款2U机型主打“超高核心数负载支持”与“灵活PCIe扩展”,瞄准企业级虚拟化、软件定义存储、AI推理、HPC等场景。

阿里通义千问近日宣布更新旗舰版Qwen3模型,专注"快思考"的Instruct模型,追求的是在指令遵循、文本理解和知识问答等任务上实现更快、更准,实现更极致的性能表现。

AI硬件市场正处于快速变化的时期,GB200未达预期、GB300的加速推进、CoWoS技术瓶颈、RTX 50系显卡量产延后以及ASIC AI的崛起,都在共同塑造着未来的竞争格局。尽管NVIDIA在GPU市场仍占据主导地位,但随着DeepSeek等新兴技术的崛起以及ASIC硬件的竞争,NVIDIA将面临更多的挑战。为了继续巩固其市场地位,NVIDIA必须加速产品创新,尤其是在专用AI硬件的研发和优化

与 LLaMA3、Qwen2 等开源模型相比,GPT-OSS 在模型精度、工具能力、可用性方面具备一定优势。更重要的是,它标志着 OpenAI 正式补齐了从 API 到开源模型的“全栈生态拼图”,并展现了其在硬件优化和模型压缩方面的工程能力。