简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Bean的扫描与注册

有一种特殊的容器叫作Init Container 初始化容器,它再普通容器之前运行。可以有多个初始化容器,所有初始化容器按顺序依次运行直到完成,所有容器都运行完成后,普通容器才开始运行

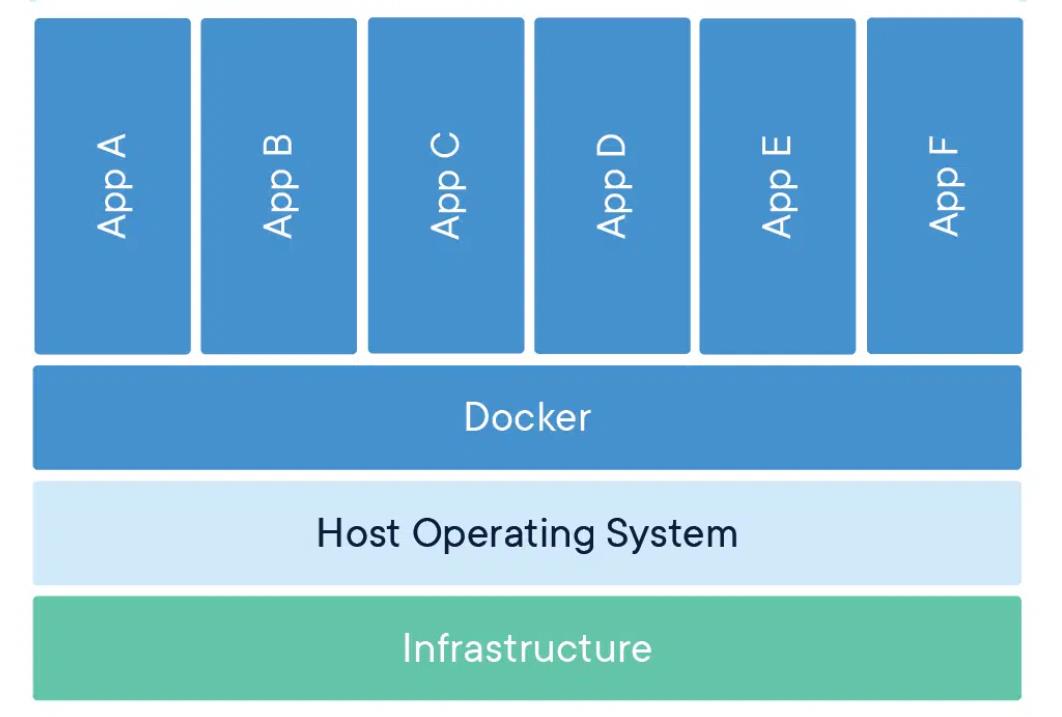

docker 容器操作命令

有一种Pod它不由ApiService管理。运行在固定的Node上,由kubelet创建。我们把它叫做Static Pod(静态Pod)

简单清晰、手把手带你搭建k8s学习环境

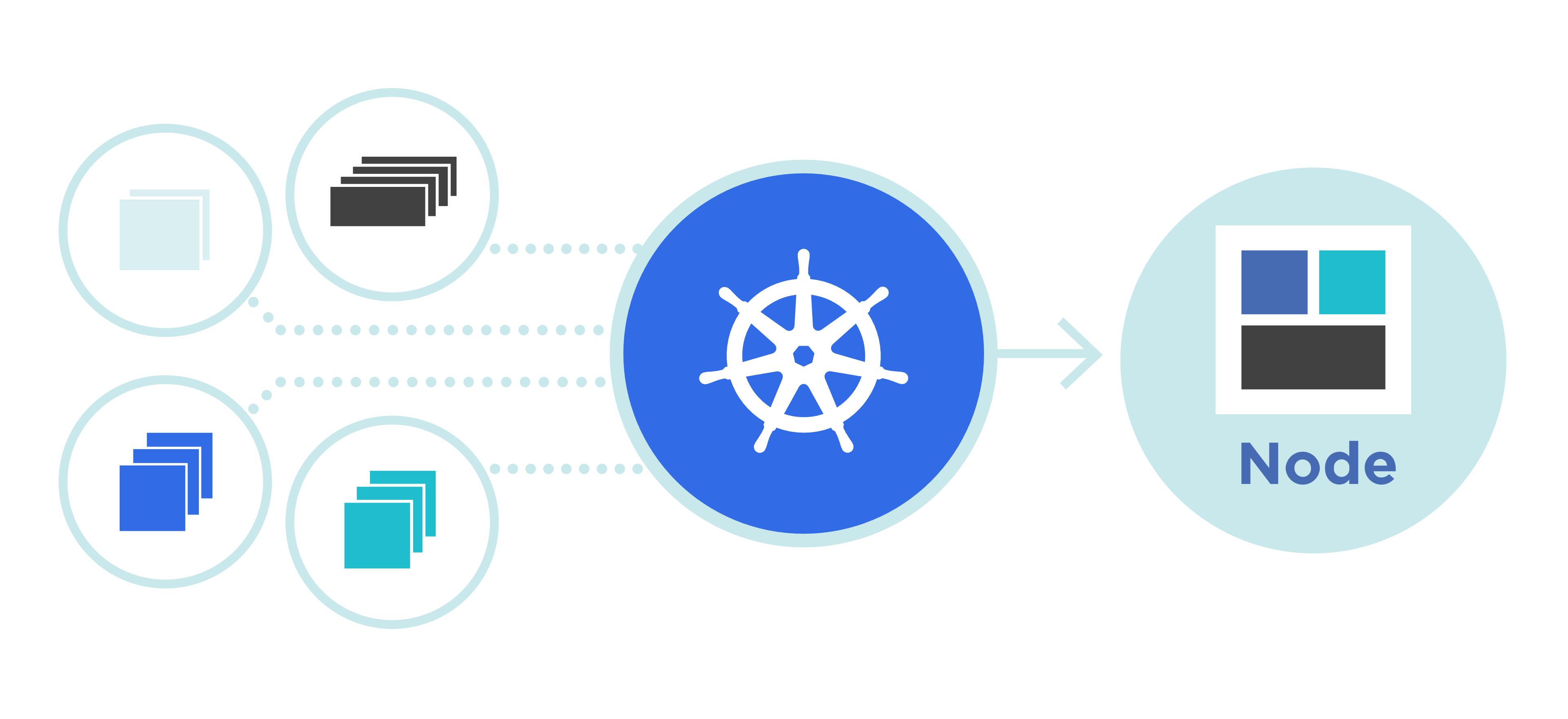

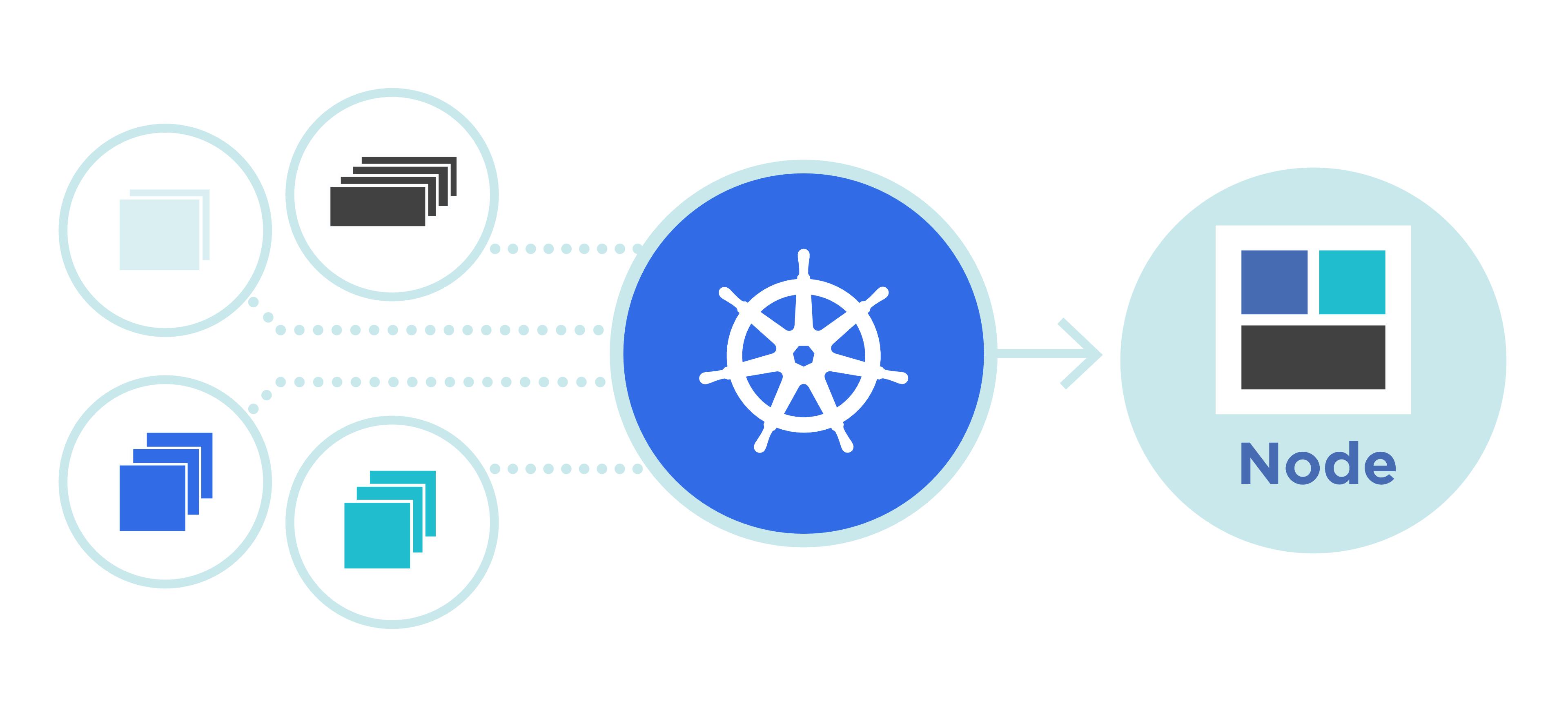

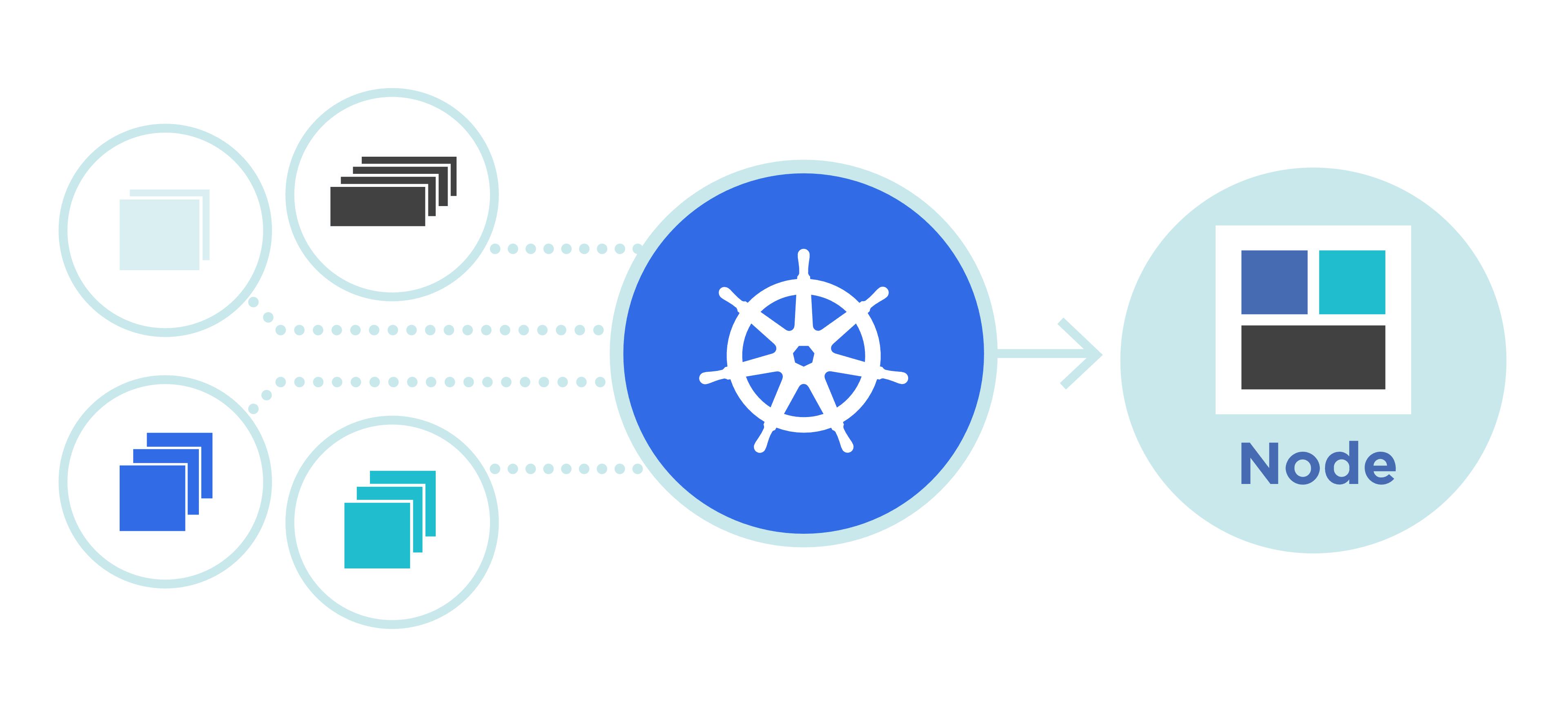

默认情况下,Pod的调度完全由Master节点的Scheduler组件经过一系列的算法计算得出的,这个过程是不能人工干预的。但是实际情况中我们的业务非常复杂,可能需要自己控制Pod到达某个节点,于是k8s也给我们提供了一些更加细粒度的调度策略设置。如NodeSelector,NodeAffinity,PodAffinity,污点和容忍等。

前面我们一直介绍的是直接创建Pod,但是在生产环境中基本很少让K8s直接创建Pod,因为这种方式创建出来的Pod删除就没有了,也不会重建。我们希望Pod资源出现故障的时候能够尝试着重启或者创建出新的Pod,扩缩容能够更加方便,更新升级能够更加合理,这个时候就需要用到Pod的控制器来实现

前面我们讲了Node的亲和性调度,但那只是对于Pod与Node之间关系能够更加容易的表达,但是实际的生产环境中对于Pod的调度还有一些特殊的需求,比如Pod之间存在相互依赖关系,调用频繁,对于这一类的Pod我们希望它们尽量部署在同一个机房,甚至同一个节点上,相反,两个毫无关系的Pod并且有可能存在一些竞争,会影响到该节点上其它的Pod,我们希望这些Pod尽量远离,所以K8s 1.4之后就引入了Po

Pod的探测用于检测容器中的应用实例是否可以正常的工作。如果不能正常工作应该去重启,或者不将流量引入该实例。K8s给我们提供了三种探测方式

前面介绍了定向调度,虽然很方便,但是也存在一些问题,不够灵活并且是硬限制,如果Node节点不存在,那么该Pod就运行不了,所以使用场景还是有所限制。