简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

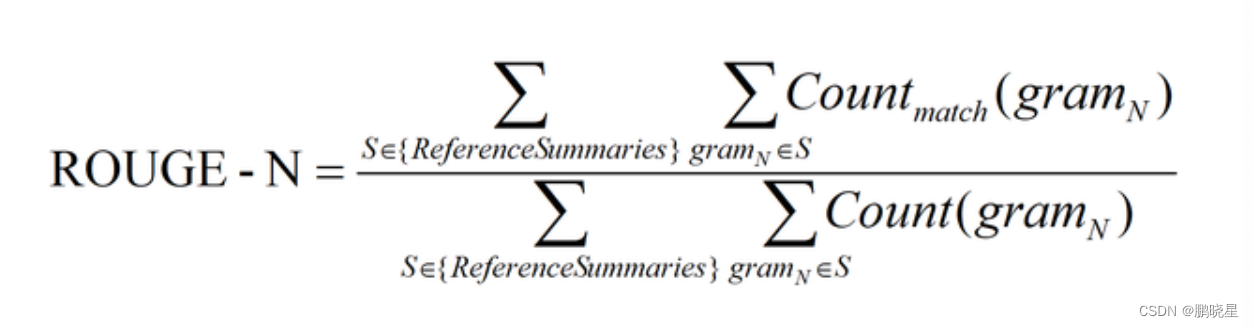

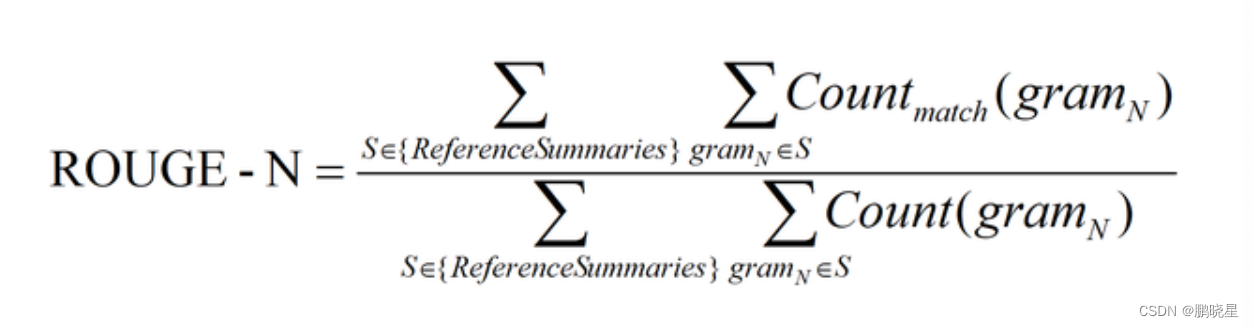

优点: 不要求词的连续匹配, 只要求按词的出现顺序匹配即可, 能够像n-gram一样反应句子级别的词序. 自动匹配最长公共子序列, 不需要预定义n-gram的长度超参数.将模型生成的自动摘要和人工摘要做对比, 通过统计两者之间重叠的基本单元的数量, 来评价模型摘要的表现.缺点: 只计算一个最长子序列, 最终的值忽略了其他备选的最长子序列及较短子序列的特征和影响.分子LCS(C, S1) = 5 (

自动微分模块是构成神经网络训练的必要模块,在神经网络的反向传播过程中,Autograd 模块基于正向计算的结果对当前的参数进行微分计算,从而实现网络权重参数的更新。torch.random.init_seed 和 torch.random.manual_seed 随机种子设置。torch.full 和 torch.full_like 创建全为指定值张量。torch.zeros 和 torch.ze

ELMo根据上下文动态调整word embedding, 可以解决多义词的问题.GPT使用了Transformer提取特征, 使得模型能力大幅提升.第三种方式就是前后分别保留一部分token, 总数是510.BERT预训练模型所接收的最大sequence长度是512。GPT只使用了单向Decoder, 无法融合未来的信息.第一种方式就是只保留前面510个token.第二种方式就是只保留后面510个

学习过程是:先从初始训练集训练出一个基学习器,再根据基学习器的表现对训练样本进行调整,使得先前基学习器做错的训练样本在后续受到更多的关注,然后基于调整后的样本分布来训练下一个基学习器;训练一个元模型(meta-model)来将各个组件模型的输出结果进行结合,具体过程就是将各个学习器在训练集上得到的预测结果作为训练特征和训练集的真实结果组成新的训练集;分别采用全部的训练样本来训练n个组件模型,要求这

Cypher是neo4j图数据的查询语言, 类似于mysql数据库的sql语句, 但是它允许对图形进行富有表现力和有效的查询和更新。心得:cypher在有SQL基础的情况下,上手还是比较轻松的,多练即可熟记。学过数据库,SQL的话不难理解,简单说就是满足ACID的操作。结果(未报错,运行正常)result:王阳明。

因为在Transformer的编码器结构中, 并没有针对词汇位置信息的处理,因此需要在Embedding层后加入位置编码器,将词汇位置不同可能会产生不同语义的信息加入到词嵌入张量中, 以弥补位置信息的缺失.相比于编码器部分,每层增加一个子层:多头自注意力子层和规范化层以及一个残差连接。第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接。第二个子层连接结构包括一个前馈全连接子层和规

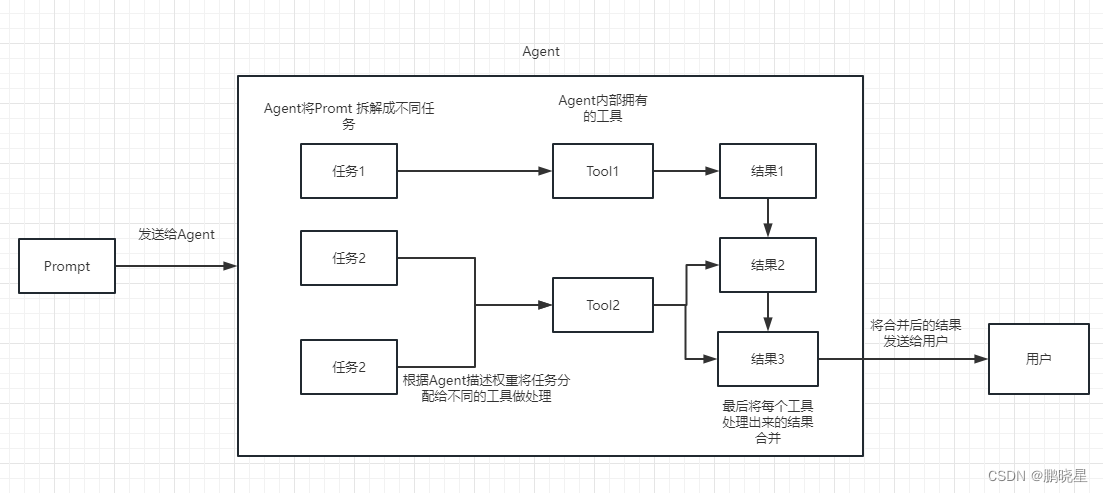

所以,不管我们是使用 openai api embedding 功能还是直接通过向量数据库直接查询,都需要将我们的加载进来的数据 Document 进行向量化,才能进行向量运算搜索。转换成向量也很简单,只需要我们把数据存储到对应的向量数据库中即可完成向量的转换。不用进行训练,并且可以实时添加新的内容,而不用加一次新的内容就训练一次,并且各方面成本要比 fine-tuning 低很多。Youtube

优点: 不要求词的连续匹配, 只要求按词的出现顺序匹配即可, 能够像n-gram一样反应句子级别的词序. 自动匹配最长公共子序列, 不需要预定义n-gram的长度超参数.将模型生成的自动摘要和人工摘要做对比, 通过统计两者之间重叠的基本单元的数量, 来评价模型摘要的表现.缺点: 只计算一个最长子序列, 最终的值忽略了其他备选的最长子序列及较短子序列的特征和影响.分子LCS(C, S1) = 5 (

自动微分模块是构成神经网络训练的必要模块,在神经网络的反向传播过程中,Autograd 模块基于正向计算的结果对当前的参数进行微分计算,从而实现网络权重参数的更新。torch.random.init_seed 和 torch.random.manual_seed 随机种子设置。torch.full 和 torch.full_like 创建全为指定值张量。torch.zeros 和 torch.ze

因为在Transformer的编码器结构中, 并没有针对词汇位置信息的处理,因此需要在Embedding层后加入位置编码器,将词汇位置不同可能会产生不同语义的信息加入到词嵌入张量中, 以弥补位置信息的缺失.相比于编码器部分,每层增加一个子层:多头自注意力子层和规范化层以及一个残差连接。第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接。第二个子层连接结构包括一个前馈全连接子层和规