简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

- **🍨 本文为[]中的学习记录博客**>- **🍖 原作者:[]**● 难度:夯实基础● 语言:Python3、TensorFlow2🍺 要求:1. 使用categorical_crossentropy(多分类的对数损失函数)完成本次选题2. 探究不同损失函数的使用场景与代码实现🍻 拔高(可选):1. 自己搭建VGG-16网络框架2. 调用官方的VGG-16网络框架3. 使用VGG-1

本次项目耗费很长时间在模型调整上,由于初始结果不理想,想到可能是由于卷积核5*5是否过大导致没能捕捉到敏感信息的缘故,将卷积核调整为3*3,但是结果更差,猜测可能是感受野过小不利于特征信息的捕捉,于是又将卷积核重新调整为5*5。同时,优化器修改为Adam。在此过程中,也曾将学习率修改为1e-3,但效果不理想,改回1e-4后结果达到满意状态。

return outmodel# 循环训练size=len(dataloader.dataset) # 训练集的大小num_batches=len(dataloader) # 批次数目,(size/batch_size,向上取整)train_loss,train_acc=0,0 # 初始化训练损失和正确率for x,y in dataloader: # 获取图片及其标签# 计算预测误差pred=m

model.train() # 切换为训练模式optimizer.zero_grad() # grad属性归零loss=criterion(predicted_label,label) # 计算网络输出和真实值之间的差距,label为真实值loss.backward() # 反向传播torch.nn.utils.clip_grad_norm_(model.parameters(),0.1) # 梯

本次项目耗费很长时间在模型调整上,由于初始结果不理想,想到可能是由于卷积核5*5是否过大导致没能捕捉到敏感信息的缘故,将卷积核调整为3*3,但是结果更差,猜测可能是感受野过小不利于特征信息的捕捉,于是又将卷积核重新调整为5*5。同时,优化器修改为Adam。在此过程中,也曾将学习率修改为1e-3,但效果不理想,改回1e-4后结果达到满意状态。

除了使用中提供的数据集,我们还可以使用类来自定义自己的数据集。自定义数据集需要实现__len__和方法。__init__:用来初始化数据集__len__:方法返回数据集中样本的数量:给定索引值,返回该索引值对应的数据;它是 python built-in 方法,其主要作用是能让该类可以像list一样通过索引值对数据进行访问。return x,y在这个示例中,MyDataset类继承自类,实现了 _

- **🍨 本文为[]中的学习记录博客**>- **🍖 原作者:[]**● 难度:夯实基础● 语言:Python3、TensorFlow2🍺 要求:1. 使用categorical_crossentropy(多分类的对数损失函数)完成本次选题2. 探究不同损失函数的使用场景与代码实现🍻 拔高(可选):1. 自己搭建VGG-16网络框架2. 调用官方的VGG-16网络框架3. 使用VGG-1

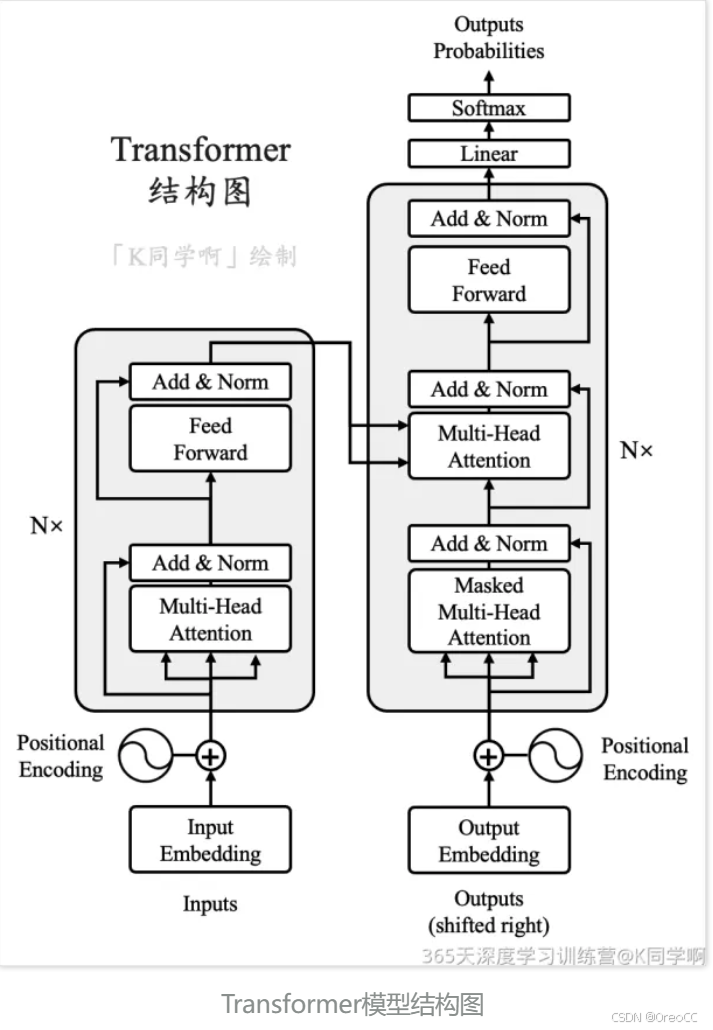

Transformer 网络架构由 Ashish Vaswani 等人在 Attention Is All You Need 一文中提出,并用于机器翻译任务,和以往网络架构有所区别的是,该网络架构中,编码器和解码器没有采用 RNN 或 CNN 等网络架构,而是采用完全依赖注意力机制的架构。网络架构如下所示:Transformer改进了RNN被人诟病的训练慢的特点,利用self-attention可

除了使用中提供的数据集,我们还可以使用类来自定义自己的数据集。自定义数据集需要实现__len__和方法。__init__:用来初始化数据集__len__:方法返回数据集中样本的数量:给定索引值,返回该索引值对应的数据;它是 python built-in 方法,其主要作用是能让该类可以像list一样通过索引值对数据进行访问。return x,y在这个示例中,MyDataset类继承自类,实现了 _

>- **🍨 本文为[🔗365天深度学习训练营]中的学习记录博客**>- **🍖 原作者:[K同学啊]**🏡 我的环境:论文地址:Conditional Image Synthesis with Auxiliary Classifier GANsACGAN的全称是 Auxiliary Classifier Generative Adversarial Network ,翻译成汉语的意思就是