简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

文章目录一、First 坑--“应输入表达式”二、Second 坑--程序不进入核函数3、Hello world测试THE END\qquad 最近再看深度学习的时候,了解了一些CUDA和GPU编程的东西,于是便想着用自己熟悉的C++试一试GPU编程的乐趣,然后遇到了一些小坑,在此记录一些。\qquad首先分享一个CUDA安装的教程,之后开始填坑。一、First 坑–“应输入表达式”\qquad

AMPL 建模指导

1、TSP问题描述\qquadTSP问题为travelling salesman Problem的缩写,问题描述为:一名旅行商需要从他的住址(home)出发,游历n个城市,之后再返回home。已知所有城市间的旅行成本,问题目标为:这位旅行商应该选择怎样的线路旅游,才能花最少的钱游历一遍所有的城市?2、TSP问题建模2.1 参数定义\qquad定义城市的总个数为:nnn,从城市iii到城市jjj的旅

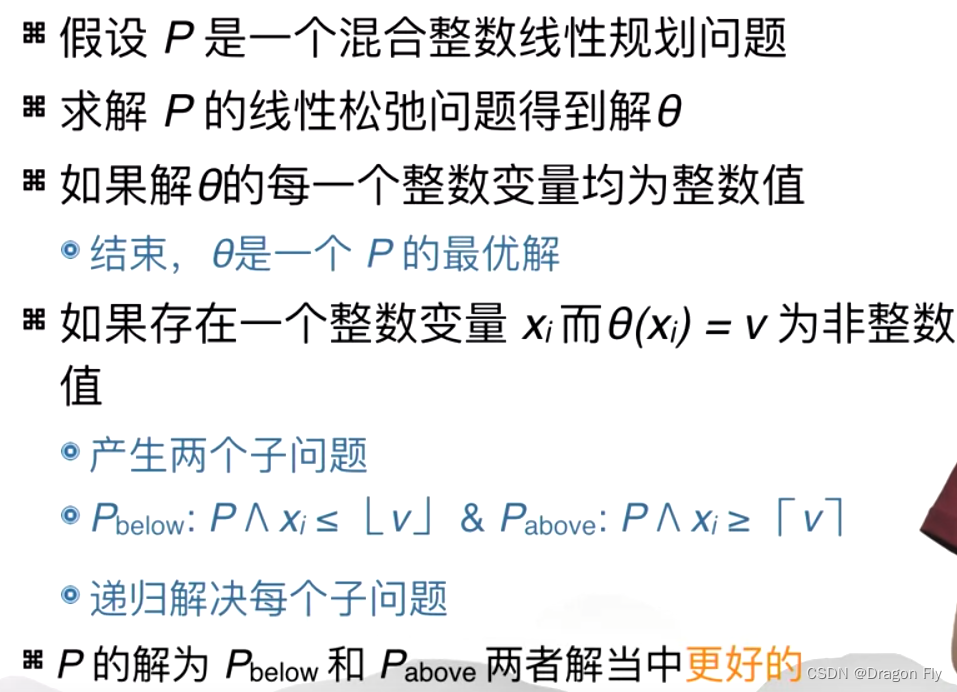

混合整数规划问题,分枝定界算法

文章目录1、引言2、UNIX BSD操作系统3、Linux操作系统4、Windows操作系统THE END1、引言\qquad操作系统的种类繁多,有面向桌面的操作系统(个人PC,办公室主机操作系统,etc);有面向服务器的操作系统,eg. 运行在数据中心(datacenter)中的操作系统,分析气象报告的操作系统;手机和移动终端运行的操作系统,eg.Android,IOS,harmonyOS,et

1、问题阐述\qquad使用C++ ADO连接MySQL时,在调用ADO函数GetRecordCount时总是返回-1,不能返回正确的记录数量。2、问题解决\qquad使用静态的游标,在连接语句之前添加下述语句:其中m_pConn是连接指针。m_pConn->CursorLocation = adUseClient; //游标类型...

端到端学习是相对于流水线学习而言的一种学习方式,如语音识别中,在端到端学习出现之前,会有一个复杂的流水线流程来实现一段语音的识别,流水线中包含很多繁琐的细节,每个细节中又包含许多繁杂的手工设计。如在图像识别中,当前手头的任务是需要训练一个关于医学影像识别的分类器,但是没有过多的训练数据,则可以使用其他训练好的分类器,如猫/狗/车分类器,其中的部分学习到的知识(部分神经网络参数)应用到医学影像识别分

文章目录1、引言2、UNIX BSD操作系统3、Linux操作系统4、Windows操作系统THE END1、引言\qquad操作系统的种类繁多,有面向桌面的操作系统(个人PC,办公室主机操作系统,etc);有面向服务器的操作系统,eg. 运行在数据中心(datacenter)中的操作系统,分析气象报告的操作系统;手机和移动终端运行的操作系统,eg.Android,IOS,harmonyOS,et