简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

机考今年的难度明显增加。建议先在leetcode上刷刷题,尽量多做中等和困难的题,简单的题今年完全没有,另外,华为机考的平台是牛客网,使用方式跟Leetcode不同,需要自己写输入输出的代码,最好提前刷几题适应下。校招一个职位可以考两次,进如果第一次没考过不要气馁!再去刷刷题回来再战!我就是第二次过的。

在推荐系统中,大型语言模型可以用于个性化推荐、解释推荐和多样性推荐等多个方面。具体来讲,大模型可以通过对用户的历史行为、兴趣偏好等信息进行建模,从而预测用户可能感兴趣的项目或物品。同时,还可以根据用户的反馈信息,自动生成解释和摘要,帮助用户更好地理解推荐结果。除此之外,还可以通过引入额外的知识库或数据集,提高推荐的多样性和新颖性...作为一个具有挑战性的研究方向,大模型推荐系统已经受到了更多研究者

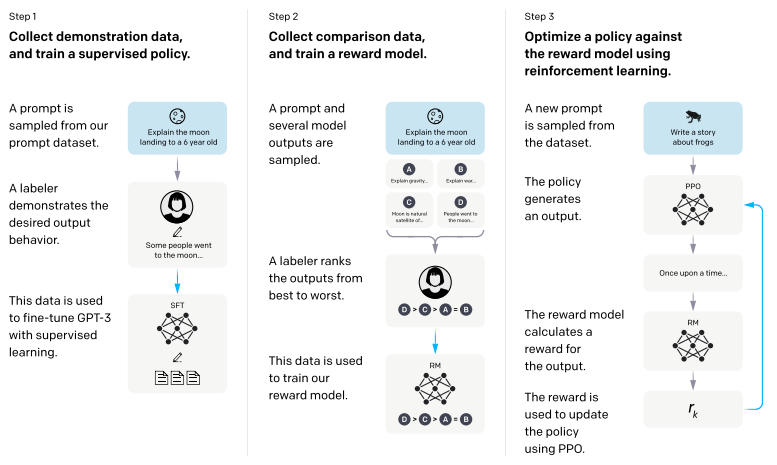

一种针对大型语言模型(LLMs)的训练方法,该方法的核心目标是使LLM具备遵循自然语言指令并完成现实世界任务的能力。它弥补了LLM的下一个单词预测目标与用户让LLM遵循人类指令的目标之间的差距,约束了模型的输出,使其符合预期的响应特征或领域知识。随着计算机技术的发展,指令调优在一些需要执行特定任务的场景上,如机器翻译、问答系统等,都有着广泛的应用前景。为帮助大家理解并掌握IT,我这次整理了每个方法

上回分享了一些,今天咱们就来聊聊垂直领域大模型,照旧附上论文资料,同学们自取哈!其实照目前的趋势来看,垂直领域大模型的未来发展是要比通用大模型好的,一是通用大模型有GPT4这座难以跨越的大山,二是自研通用大模型的成本实在太高,一般公司承受不来。所以,各类厂商们自然就会选择参与垂直领域大模型的角逐。目前卷出来的垂直领域大模型已经有很多了,我今天就来和大家分享几个比较出名的,感兴趣的同学也可以自己上手

最近特征金字塔(Feature Pyramid Network, FPN)结构被广泛运用在遥感目标检测领域。

主要介绍项目的数据、任务、模型、参数、优化和结果。

本篇主要是帮助大家构建高性能、高性价比的AI开发的硬件平台。

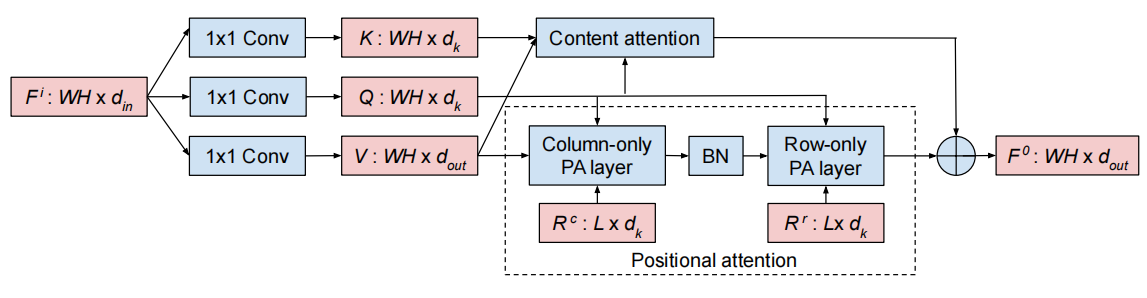

是学术界与工业界共同的研究热点,它可以这种结合策略充分利用全局注意力(擅长捕捉序列或图像中的长距离依赖)和位置注意力(专注于序列中元素的具体位置)各自的优势,让模型在处理数据时同时考虑元素的内容及其在序列中的位置。这不仅提高了模型的表达能力,还能在保持计算效率的同时增强模型对复杂模式的理解和预测能力。比如全局位置自注意力网络GPS-Net,通过空间自注意力学习结构化依赖性,并通过通道自注意力捕捉全

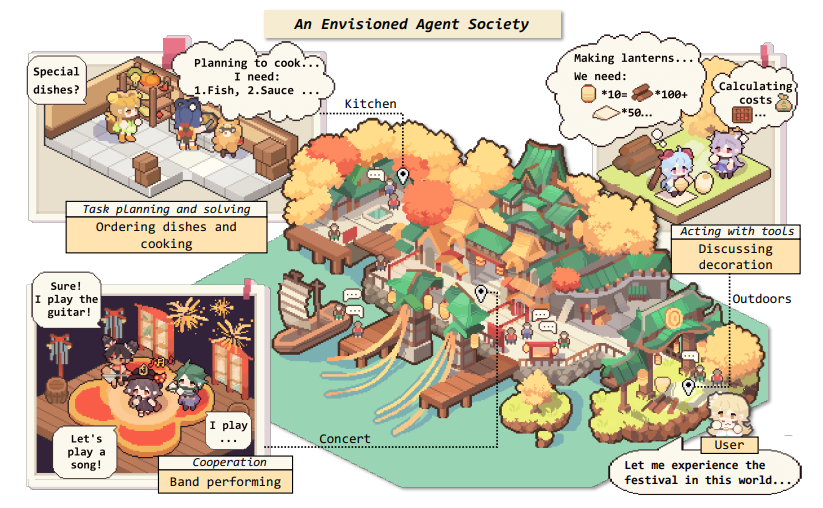

人们对于通用人工智能(AGI)的追求可以追溯到1950 年代中期,当时的AI研究者对机器拥有人类思维能力抱有很高的期望,但是随着研究的深入,他们发现想实现这个目标比最初设想的困难许多。到如今,AGI仍然有很长的路要走。不过值得高兴的是,在今年的各大顶会中,有关自主智能体的研究有了许多突破性进展,以往困扰AI Agent研究者的社会交互性和智能性问题都随着大语言模型(LLM)的发展有了新的解决方向。

还在搞传统的?不如考虑。优势在于能融合不同模态的特征信息,实现模型理解、预测和决策能力的大幅提升,可以帮助我们开发出拥有更高性能的智能算法和模型,近期的不少一区顶刊上陆续发表了相关研究,热度可见。不过深度学习+多模态数据融合仍然处于快速发展期,数据异构性、模态缺失等问题尚未解决,还是有创新空间的,尤其在解决实际挑战或提出新型融合架构方面。在未来更复杂场景下,显然这类多模态融合技术将成为核心支撑,且