简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

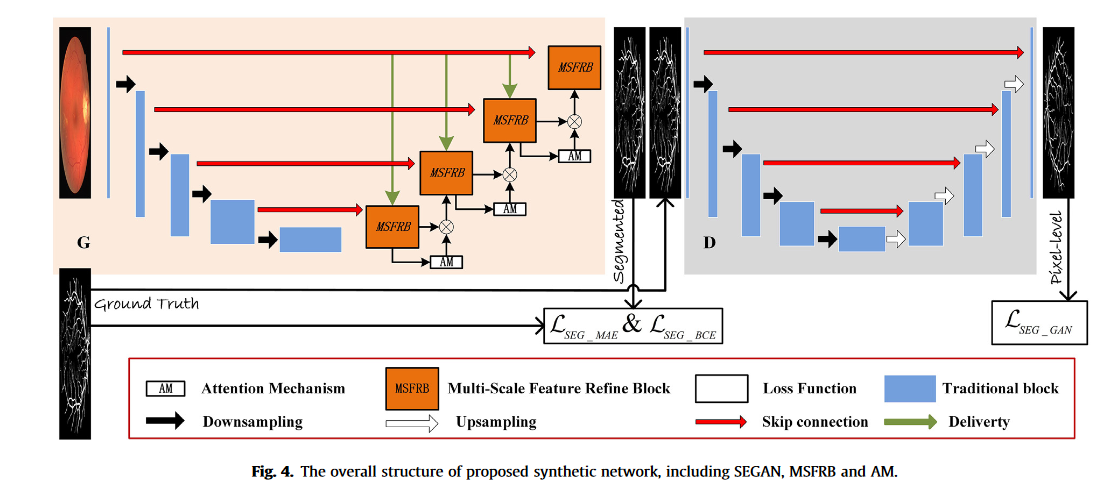

相应地,D重新强调了不仅有大的血管主干,还有充满细节信息的难以捉摸的血管的重要性。在这种良好匹配的设置下,加强对抗训练,以迫使G生成更真实的血管分割图。框架新颖,虽然也对UNet进行了魔改,但是魔改UNet不是最主要的点,使用生成对抗网络分割,加权损失函数等,可能也只是为了论文好看,主要是框架新。然而,分割性能受难以捉摸的血管的影响很大,特别是在。文中称这种难以分割的区域为:Elusive ves

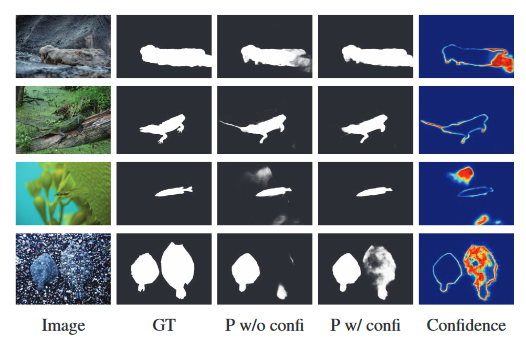

CODNet将模型预测(Dir yini和Dir yref)和图像x的级联作为输入,以产生单通道置信度图,以及最终预测的cref,通过从伪装目标检测网络fθ(x)和地面实况伪装图y的预测导出的动态不确定性监督来监督估计的置信图。数据集:使用COD10K训练集[13]训练我们的模型,并在四个伪装物体检测测试集上进行测试,包括CAMO[28]、CHAELEON[45]、COD10K测试数据集[13]和

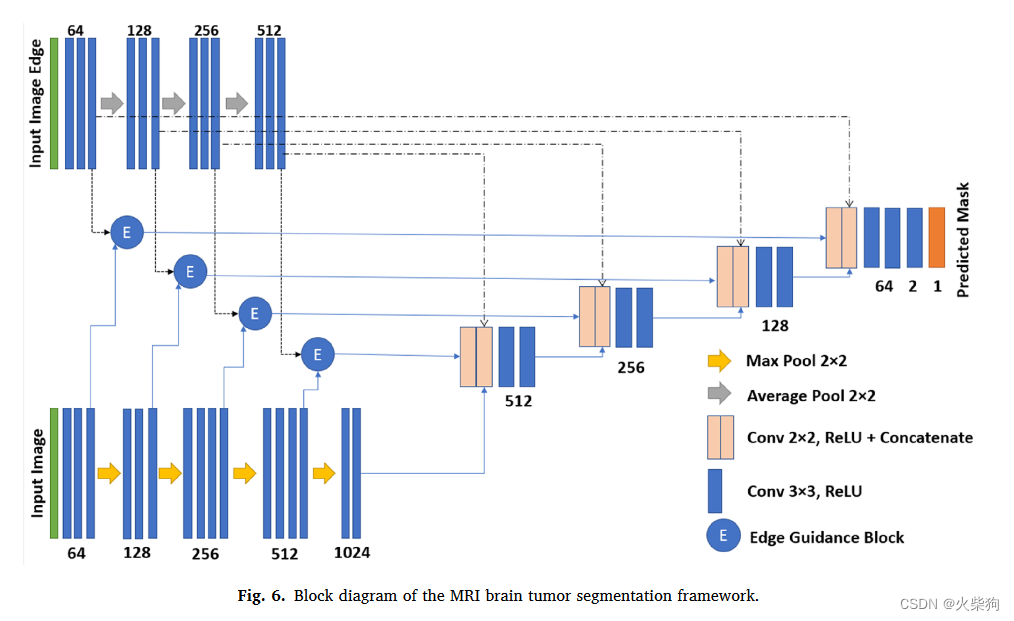

表2显示了数据集的三种类型的肿瘤的分布。文中没说边界输入是通过哪种方式提取的边缘,应该是Sobel或者Canny,用边缘特征给原图影像特征加权融合,融合后的特征以及边缘特征跳跃连接到解码器。开发用于对象分割的最合适的能量函数的主要目标是将能量函数的值降低到实现精确分割所需的最低水平。编码器和解码器的同一级别层之间的跳过连接使得能够将来自编码器网络的特征图与上采样的特征图级联,该特征图起到。为了评估

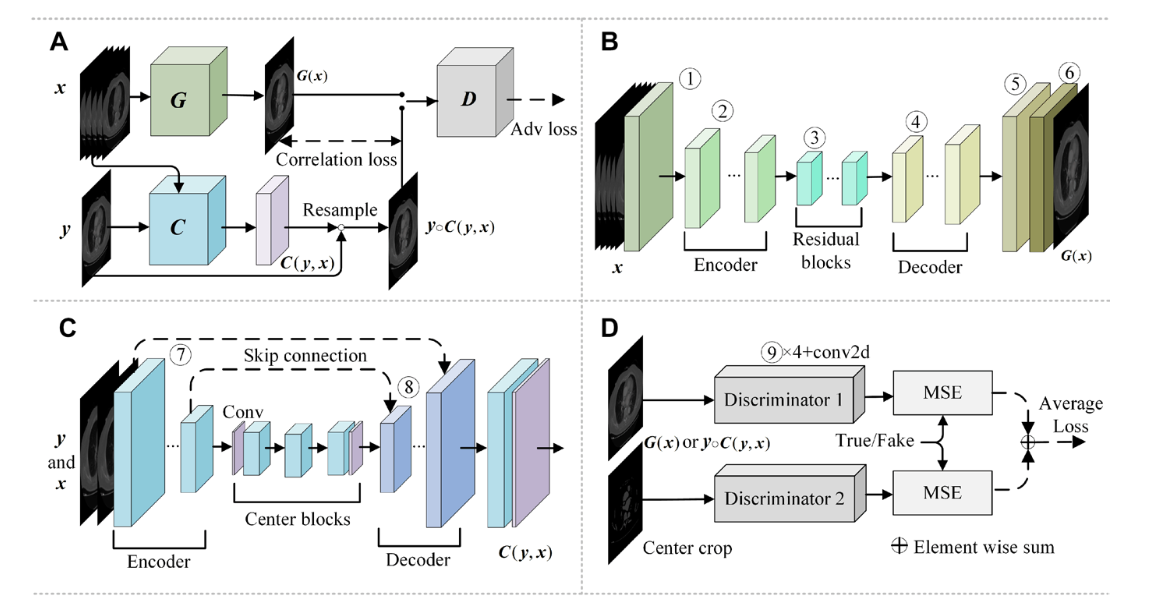

输入是未配准的成对CT-SynCTA影像,先用CT影像生成SynCTA影像,再对SynCTA影像进行配准,再通过判别器,判别生成的影像和原始SynCTA影像。最终合成配准了的SynCTA影像。碘造影剂(ICAs)广泛用于CT血管造影术(CTA),可能会对人体产生不良影响,而且使用耗时且成本高昂。论文中对方法描述不对,以下是从源代码中简化的训练步骤伪代码。配准后的图像和源图像的L1 loss,对抗l