简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

QT+opencv环境配置的编译阶段可能会出现各种错误,现在,我对自己遇到的错误做个小结一:友情提示1):cmake下载链接:https://cmake.org/download/OpenCV下载链接:https://opencv.org/releases.htmlQt Creator下载链接:https://download.qt.io/official_releases/qt/网上可参考的环境

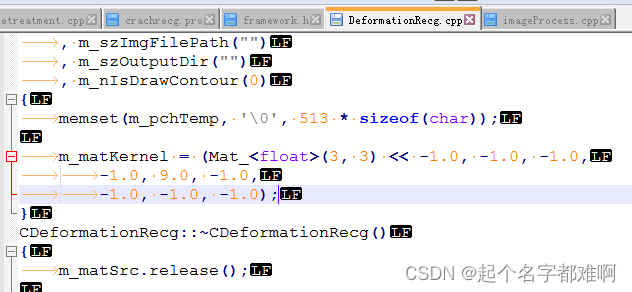

linux上的c或c++等文件拷贝到windows编译时由于编码格式、换行符等导致编译出错

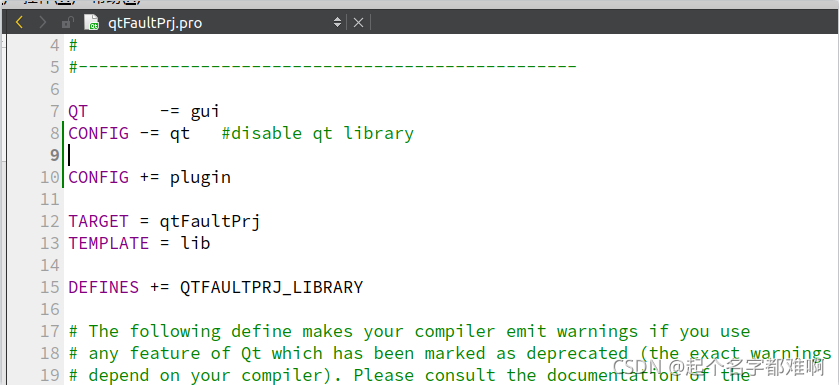

要生成纯净的so文件,也就是不包含qt的内容的话,在qt配置文件.pro中添加:1、QT -= gui #表示禁止使用qt的GUI界面及界面相关的文件;2、CONFIG -= qt#表示禁止使用qt的库;3、QT 生成.so动态库时,会默认生成.so .so.1 .so.1.0 .so.1.0.0四个文件,其中其他三个文件都是指向.so.1.0.0这个实际的库文件的链接文件,为了版本控制。要想直接

这个是官方测试TensorRT的Release日志,里面指明了当前测试的TensorRT版本是在哪个CUDNN等库下的测试结果,也就是说如果按照里面的测试时的版本对应的话能达到推理速度最快。在发布模型和推理发布的TRT模型时应该会出现相应的警告,如果出现警告,那么可以调整为官方要求的版本,那么还有很大的速度提升,,,留心一下。

这个是官方测试TensorRT的Release日志,里面指明了当前测试的TensorRT版本是在哪个CUDNN等库下的测试结果,也就是说如果按照里面的测试时的版本对应的话能达到推理速度最快。在发布模型和推理发布的TRT模型时应该会出现相应的警告,如果出现警告,那么可以调整为官方要求的版本,那么还有很大的速度提升,,,留心一下。

将linux下的QT作为生成和调用so的IDE,这使得我们省去了编写makefile或者cmake的步骤。1、生成so代码如下:(生成so的工程代码请到这下载)main.cpp#include "main.h"//调用该so内的下面函数时,传进的是Mat图像的data,传出的是处理后的Mat图像的data,而不是Mat格式的传递void drawCircle_Mat2Arry(int rows,

python传递字符串到c或c++时,出现格式错误:TypeError: bytes or integer address expected instead of str instance原因:因为编写的c或者c++中的编码并不是utf-8的,故当你在linux下调用该c或c++函数时就会出现类型不一致。当然,中文的编码时也应该变为utf8。注:windows编码方式默认是gbk和linux默认是

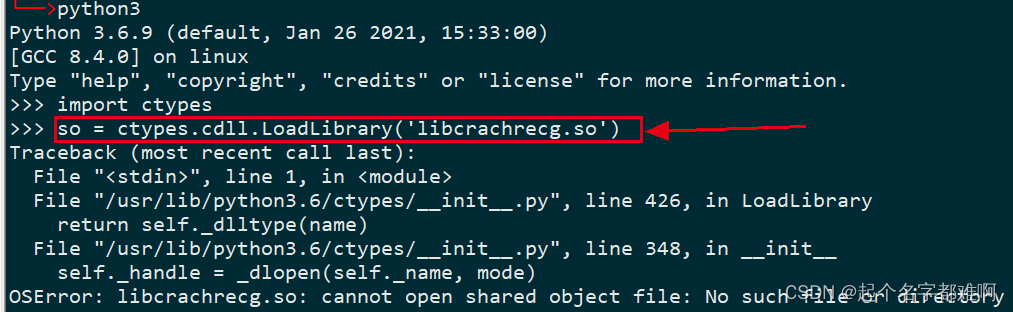

1、调用opencv函数时出现错误比如:qt编译包含opencv读取摄像头的函数时出现错误undefined reference to `cv::VideoCapture::VideoCapture()2、生成linux库文件so,并用python或者c++调用该so里面的接口时出错如:python调用linux下qt编译生成的so,该so文件里面已经实现了接口函数hello(),出现如下错误:解