简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

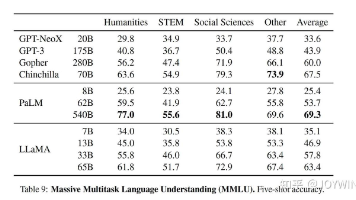

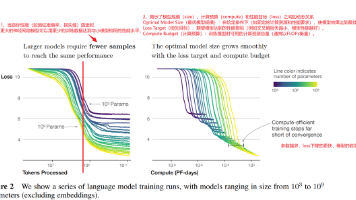

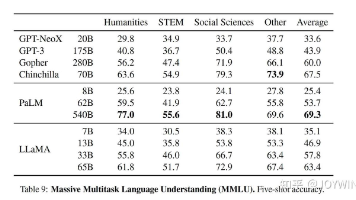

LLaMA是一个系列模型,模型参数量从7B到65B。在大部分的任务上,LLaMA-13B强于GPT-3(175B)。LLaMA-65B的性能,可以和最好的LM相媲美,如Chinchilla-70B 和PaLM-540B。

参考视频:【BERT 论文逐段精读【论文精读】】 https://www.bilibili.com/video/BV1PL411M7eQ/?

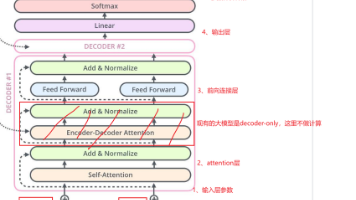

所有参数=$$词向量维度 × (词表大小 + 窗口长度) +(4D^2 + 8D^2 + 5D)*注意力层数 $$,D为词向量维度代码计算看7、代码计算。(计算复杂度和宽度是平方关系,和层数是线性关系)

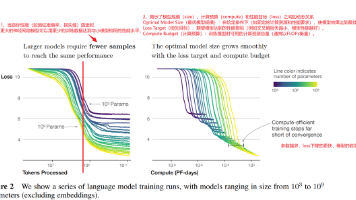

量变引起质变,当规模达到一定程度的时候,产生了一种群体的现象,这种群体的现象再也不能从原来的个体现象推知,可能需要一个新的学科,或者一些新的定律来研究整体的系统。(说人话就是一开始模型学习翻译的,训练完之后,模型也学会了做完型填空……)总结:大模型出现涌现现象(Emergent Abilities)的本质是复杂系统在规模效应和高维表征能力的共同作用下,产生的非线性相变。小模型不具备,但是大模型拥有

读取视频VideoCapture可以捕获摄像头,用数字可以空中不同的设备,比如0和1视频文件直接指定位置就可以。

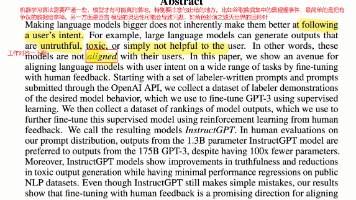

论文题目Training language models to follow instructions with human feedback,即训练语言模型,使得它们能够服从人类的一些指示。语言模型每次是给定一段东西,然后去预测下一个词,它是一个自监督模型,所以认为它是没有标号的。如果想让语言模型去解释某一个概念的话,就需要文本中出现过类似的东西,因此模型的行为取决于文本搜集的好坏。这样的问题在

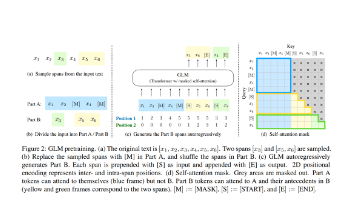

GLM:https://arxiv.org/abs/2103.10360GLM130B: https://arxiv.org/abs/2210.02414 code: https://github.com/THUDM/GLM-130B/Code: https://github.com/THUDM/ChatGLM-6B相关博客参考(按优先级顺序):https://blog.csdn.net/zsq_

参考视频:【BERT 论文逐段精读【论文精读】】 https://www.bilibili.com/video/BV1PL411M7eQ/?

LLaMA是一个系列模型,模型参数量从7B到65B。在大部分的任务上,LLaMA-13B强于GPT-3(175B)。LLaMA-65B的性能,可以和最好的LM相媲美,如Chinchilla-70B 和PaLM-540B。

量变引起质变,当规模达到一定程度的时候,产生了一种群体的现象,这种群体的现象再也不能从原来的个体现象推知,可能需要一个新的学科,或者一些新的定律来研究整体的系统。(说人话就是一开始模型学习翻译的,训练完之后,模型也学会了做完型填空……)总结:大模型出现涌现现象(Emergent Abilities)的本质是复杂系统在规模效应和高维表征能力的共同作用下,产生的非线性相变。小模型不具备,但是大模型拥有