简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文提供了一个3天快速上手LangGraph框架的学习方案,聚焦于简历项目开发。方案包含环境搭建、核心概念学习、多Agent实现和CRAG式反思机制三个主要阶段。第1天重点学习State、Node、Edge、Graph四个核心概念;第2天实现多Agent协作和条件分支;第3天构建带质量评估和循环重试的工作流。文中给出了可直接运行的示例代码,并强调通过修改示例代码来加深理解。学习资源优先级排序为官方

摘要: MCP(Model Context Protocol)是OpenAI提出的标准化协议,用于规范Agent与外部工具/服务的通信。fasemcp是主流的Python实现库,支持工具服务化部署、结构化参数校验(基于Pydantic),并与LangChain等框架兼容。其核心流程包括定义工具、封装为MCP服务、Agent通过客户端调用。MCP支持三种连接方式:HTTP/JSON-RPC(默认,跨

摘要: 智能体通信协议包括MCP(工具交互)、A2A(智能体协作)和ANP(网络管理)三大协议。MCP协议通过标准化接口实现智能体与工具的通信,核心组件包括客户端、服务器和工具封装模块。A2A协议支持智能体间点对点任务协商与技能调用,包含服务端、客户端和工具封装。ANP协议提供大规模智能体网络的服务发现与路由功能,包含发现中心、网络管理和工具模块。开发者可通过自定义MCP服务器快速扩展工具能力,三

本文介绍了智能代理系统中的上下文工程知识树,包含ContextBuilder、NoteTool和TerminalTool三大核心组件。ContextBuilder实现GSSC流水线管理上下文,通过信息收集、选择、结构化与压缩保障高价值信息留存;NoteTool提供Markdown+YAML结构化笔记功能,支持智能体持久化记忆管理;TerminalTool实现安全的命令行执行能力。文章还展示了三大工

摘要: 在医疗大模型SFT中,直接设置大num_train_epochs依赖loss下界判断收敛是高风险的,因为: Loss下降≠模型优化:医疗答案多样性可能导致模型“学坏”(如过度自信、幻觉增多); LoRA过拟合隐蔽:loss缓慢下降时,模型可能已塌缩至数据分布中心; 医疗场景更需保守:欠拟合比过拟合更安全。 正确做法: 密集探测:缩短save_steps间隔,通过人工评测不同step的模型行

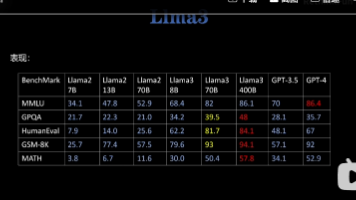

同参数量层面的代差优势似乎在告诉我,微调基座模型的选型应该越新越好你的判断非常准!在当前大模型的迭代节奏下,**“越新的基座模型,微调后的上限越高”**已经是行业共识,我们可以从技术代差、模型设计演进和开源生态三个维度来解读这几个主流开源基座的特点和选型逻辑。

摘要 大模型实习项目应聚焦小方向进行深度优化,通过控制变量实验和标准化指标量化改进效果。核心思路包括:选择具体优化点(如Loss函数)、设计严谨对比实验、用公开基准(MMLU/AlpacaEval等)量化性能提升,并能解释改进原理。建议记录完整实验日志,重点关注"单一变量+量化结果+原理分析"的闭环验证。项目不必贪大,可针对对齐算法Loss优化等具体问题,在固定基座模型和训练条

摘要 本文针对200M参数小模型的预训练与监督微调(SFT)阶段,提出了一套可落地的量化评测体系,包含4类核心指标: 困惑度指标:通过验证集计算token-level负对数似然,评估语言建模能力 自动文本相似度:使用BLEU/ROUGE/BERTScore衡量生成内容与参考答案的匹配度 行为稳定性指标:监测重复率、生成长度、EOS使用等生成特性 任务准确率:设计选择题/简单QA等微型评测集 文章强

摘要 本文针对200M参数小模型的预训练与监督微调(SFT)阶段,提出了一套可落地的量化评测体系,包含4类核心指标: 困惑度指标:通过验证集计算token-level负对数似然,评估语言建模能力 自动文本相似度:使用BLEU/ROUGE/BERTScore衡量生成内容与参考答案的匹配度 行为稳定性指标:监测重复率、生成长度、EOS使用等生成特性 任务准确率:设计选择题/简单QA等微型评测集 文章强

本文总结24种主流视觉-语言多模态模型的关键特性对比。表格包含模型名称、发布时间、核心特征、开源状态、适用任务、融合方式(早期/晚期/双流)及架构细节。重点模型包括:CLIP(图文对比训练)、BLIP系列(问答强项)、LLaVA(多模态对话)、Kosmos(统一建模)等。最新模型如Emu2(支持视频)、Qwen-VL(中文优化)和Phi-3-Vision(轻量化)均有涵盖。80%模型开源,融合方式