简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

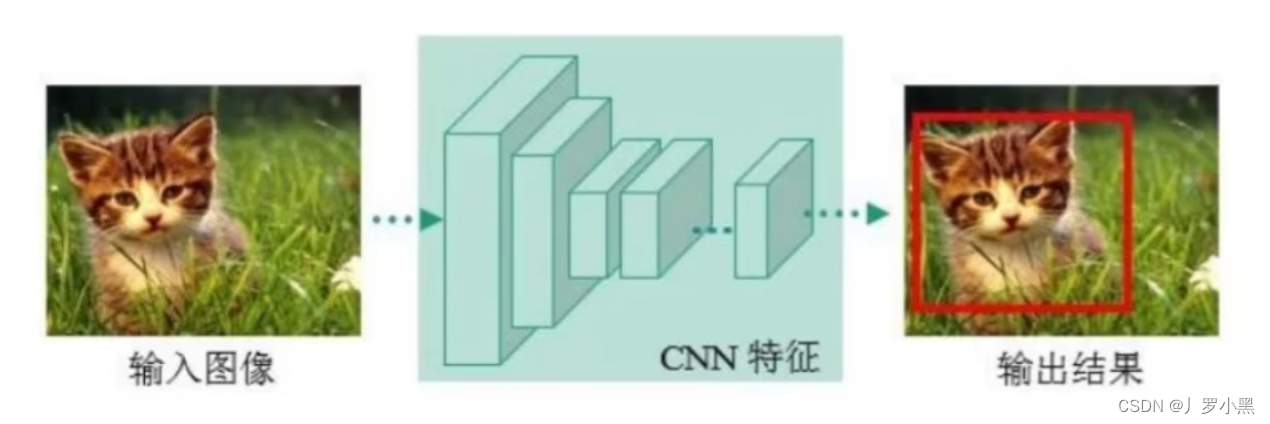

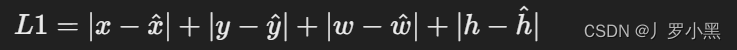

经典的目标检测方法one-stage 单阶段法:YOLO系列one-stage方法:仅使用一个CNN,直接在特征图上预测每个物体的类别和边界框输入图像之后,使用CNN网络提取特征图,不加入任何补充(锚点、锚框),直接输出预测框左上右下角的坐标以及物体的类别即该CNN网络在单次前向传播中,不仅提取特征,还要预测每个物体的类别和边界框优点:速度非常快,适合做实时检测任务缺点:效果通常不会太好two-s

使用惰性求值的目的是要最小化计算机要做的工作。eg:生成器推导式是继列表推导式后的Python推导式,比列表推导式速度快,占内存少。:不管用什么方法访问元素,当所有元素访问结束后,立马清空生成器对象。如果需要重新访问其中的元素,必须重新创建该生成器对象。:惰性求值(Lazy Evaluation),又译为惰性计算、懒惰求值,也称为传需求调用(call-by-need)。

传统OCR的流程传统OCR:传统光学字符识别常见的的模型主要包括以下几个步骤来识别文本预处理:预处理是指对输入的图像进行处理,以提高文字识别的准确率。这可能包括调整图像大小、转换为灰度图像、二值化(将图像转换为黑白两色)、去噪声、校正图像中的倾斜等步骤。目的是减少图像中的干扰信息,并突出文字部分。文本检测:文本检测的目的是在图像中定位文本的位置。这一步骤要解决的主要问题是识别图像中哪些区域包含文字

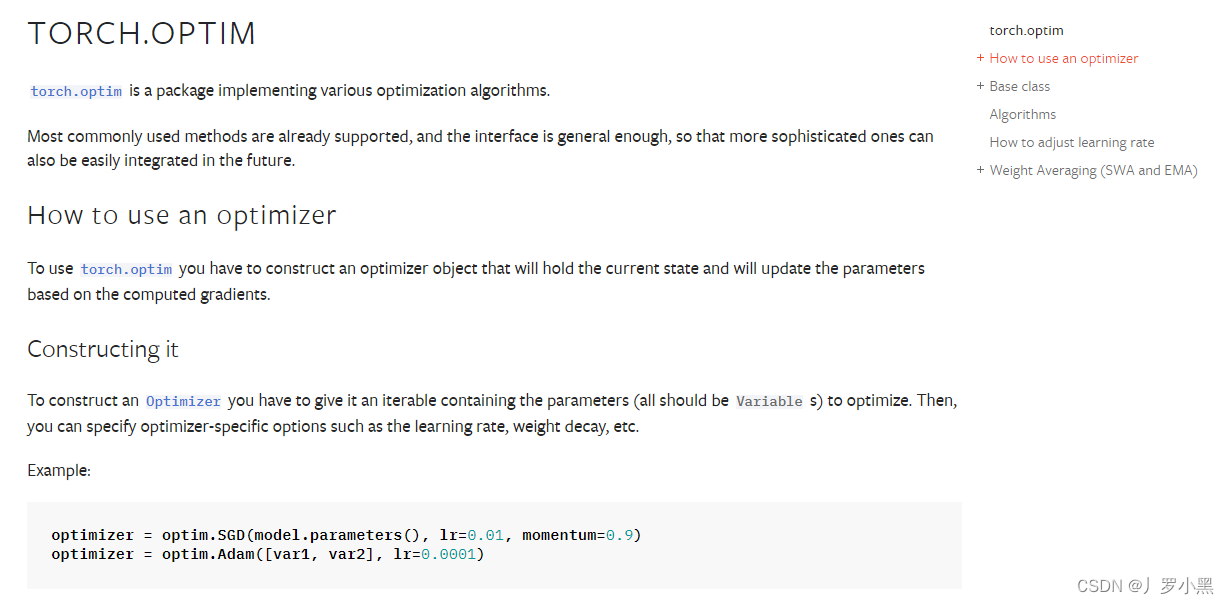

优化器在模型的训练过程中,我们根据反向传播来获取每个网络节点的对应梯度,之后通过某种算法(优化器)根据对应梯度来不断更新节点的参数,最终达到最小loss的结果。优化器有很多,但有两个参数是所有优化器都有的:模型的节点参数、学习率,其中:学习率是我们手动指定的,一般都为较小的数,如下:以下为使用优化器的步骤:注意,在每次反向传播(backward)之前,需要进行梯度清零(zero_grad)。因为在

有放回抽样有放回抽样和无放回抽样的区别:有放回可以确保每轮抽取的结果不一定相同,无放回则每轮抽取的结果都相同在猫狗的例子中,我们使用”有放回抽样“来抽取10个样本,并组合为一个与原始数据集不同的新数据集,虽然新数据集中可能有重复的样本,也不一定包含原始数据集的所有样本。随机森林算法装袋决策树算法(Bagged decision tree)是适用于决策树集合的一种算法,生成决策树集合的过程如下:对于

正则化的思想如果特征的参数值更小,那么对模型有影响的特征就越少,模型就越简单,因此就不太容易过拟合如上图所示,成本函数中有W₃和W₄,且他们的系数很大,要想让该成本函数达到最小值,就得使W₃和W₄接近0,从而消除它们对成本函数的影响,最后我们就得出一个接近二次函数(左边图片)的成本函数正则化的一般形式通常,一个模型有很多特征,我们不知道哪个特征的参数重要,哪个特征的参数我们需要缩小或惩罚。所以,我

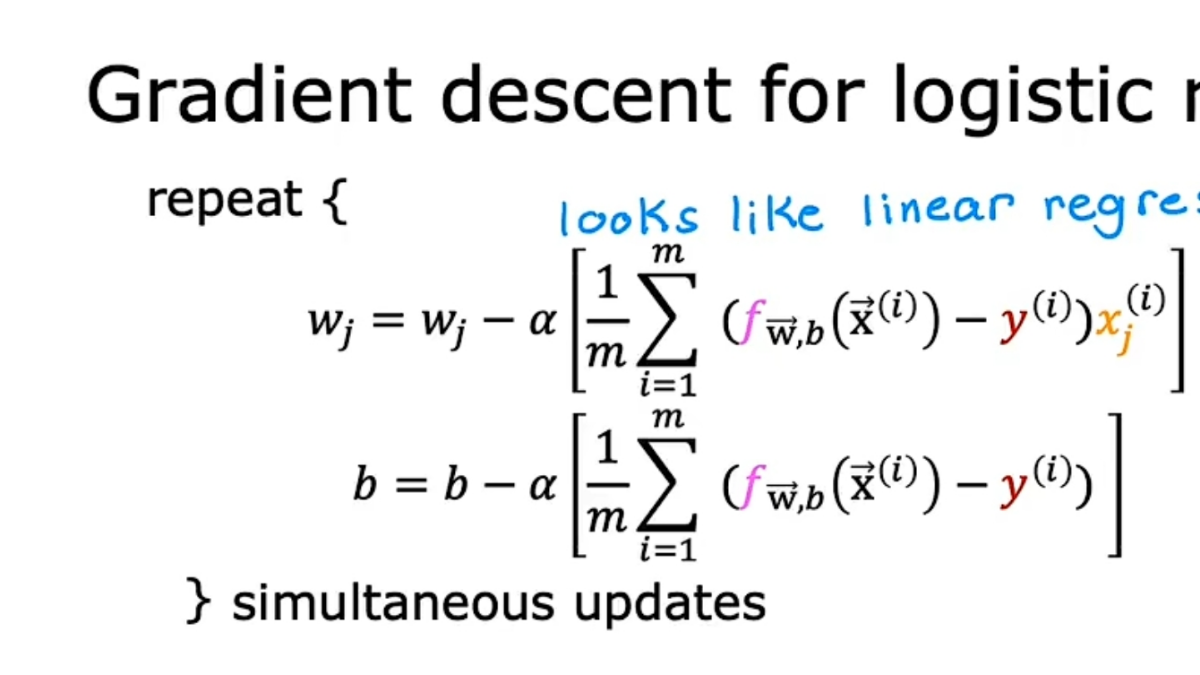

逻辑回归的梯度下降

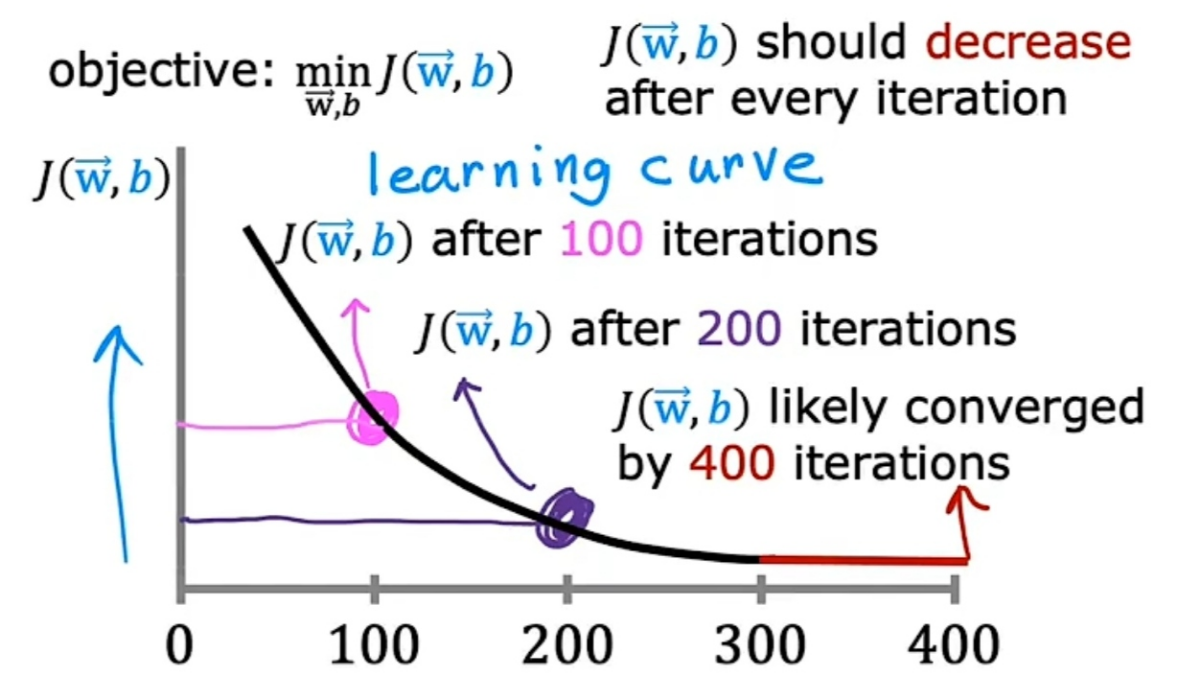

画学习曲线图x轴是梯度下降算法的迭代次数,y轴是成本函数J的值梯度下降算法的目的是:找到一组w和b,让成本函数J最小学习曲线图可以帮助我们查看成本函数J如何变化。如果梯度下降算法工作正常,那么成本函数J在每次迭代后都会减少。如果成本函数J在一次迭代后增加,那意味着学习率α可能选的太大,或代码有bug。学习曲线图还可以帮助我们判断,梯度下降算法是否收敛。当学习曲线平坦时,梯度下降算法收敛。自动收敛测