简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

用户规模与需求个人开发者或小型团队,优先选择 Windows 10 的灵活性和易用性。大型企业或需要集中化管理时,Windows Server 的 Active Directory 和组策略不可或缺。交互方式依赖依赖图形界面、触控操作或消费级软件(如游戏、设计工具),Windows 10 是唯一选择。仅需命令行管理或自动化运维,Windows Server 的轻量化设计更高效。成本与授权模型Win

模型介绍通义万相(Wan)2.1 是阿里云通义实验室推出的开源多模态生成模型,支持文 / 图生视频、视频编辑及音视频生成。它包含 140 亿参数专业版和 13 亿参数极速版,基于自研 3D VAE 与 DiT 技术,可实现中英动态文字生成及 1080P 长视频编解码,适用于影视、广告及短视频创作等领域。

近年来,AI已然成为各行各业的热门话题——从预测分析到内容创作,从设计辅助到决策支持,似乎没有AI不能涉足的领域。它正迅速成为数字时代的“新万金油”。在教育、医疗、金融、法律等专业领域,越来越多的人坚信AI能够打造更高效、更公平、更智能的系统。但普林斯顿大学信息技术政策中心主任阿尔文德·纳拉亚南与其博士生萨亚什·卡普尔在合著的《AI万金油:商业幻想与科技狂潮》中尖锐指出,每一次技术热潮都伴随着相应

VideoLingo的主要区别在于它提供的是单行字幕,并且拥有最佳的翻译质量和无缝的配音体验。此外,VideoLingo还支持多种语言的输入和翻译,并且配音语言取决于所选择的TTS方法。应运而生,成为一款集视频翻译、本地化与配音于一体的前沿工具。该模型以生成媲美Netflix级别的高质量字幕与配音为目标,致力于消除传统机器翻译的生硬感,推动知识无障碍共享。基于NLP技术实现精准字幕分割与翻译,支持

Atlas最具特色的功能之一是智能侧边栏。传统使用AI处理网页内容需要多步骤操作:复制内容、切换标签页、粘贴内容、输入指令。而Atlas通过侧边栏实现了与当前浏览页面的无缝交互。当用户浏览网页时,只需点击侧边栏的ChatGPT图标,即可就当前页面内容直接提问。这种设计省去了繁琐的复制粘贴步骤,让信息获取变得更加流畅自然。实际测试中,该功能在处理长文摘要、多页面数据对比等场景中表现优异,体验远超“传

云渲染技术正在影视动画、建筑可视化等领域快速崛起,其五大核心优势推动行业变革:高效分布式渲染将传统10小时任务缩短至1小时;弹性付费模式节省85%硬件投入;解放本地算力实现多任务并行;7×24小时专业保障提升70%故障解决效率;支持远程协同打破空间限制。渲酷云平台凭借单帧多机超频渲染、全流程数据安全和广泛软件兼容性脱颖而出,助力某建筑工作室季度出图量提升233%。随着5G发展,实时交互式云渲染将成

在理解复杂场景语义方面表现卓越,能精准还原用户的创意意图,实现多对象的准确生成。该模型采用了创新的 MoE(Mixture of Experts)架构,整合了高噪与低噪专家模型,并能够根据去噪时间步智能选择专家,从而显著提升生成视频的质量。此外,其 5B 版本采用了高压缩比 VAE 技术,有效优化了显存占用,并支持混合训练,进一步提升了模型的效率和应用潜力。因为俩个14b的生成视频工作流具有俩个采

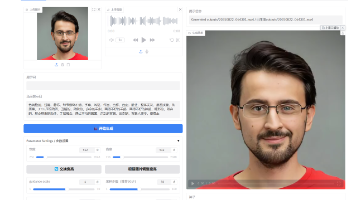

StableAvatar 是由复旦大学联合微软亚洲研究院、西安交通大学及腾讯混元团队共同研发的一项突破性AI视频生成技术。该技术于2025年8月首次实现了的高质量生成,显著解决了以往技术在生成长视频时频繁出现的面部扭曲、身体变形、音画不同步等关键问题,推动了AI数字人技术在实际应用中的可用性与自然度。

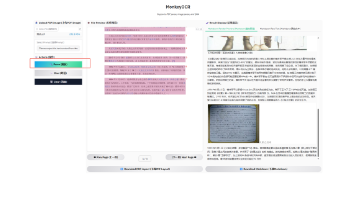

MonkeyOCR 是一款开源的文档解析 AI 工具。这种方法旨在简化传统模块化方法(需要多个工具串联)的复杂性,同时避免使用大型多模态模型处理整页文档时常见的效率低下问题。2、处理速度快: 多页文档解析速度达 0.84 页/秒,快于 MinerU (0.65 页/秒) 和 Qwen2.5 VL - 7B (0.12 页/秒)。星海智算平台已经为大家部署好这个镜像,开箱即用,下面为大家介绍一下,如

星海智算平台已经为大家部署好这个镜像,开箱即用,下面为大家介绍一下,如何在星海智算平台上使用。由于庞大的模型规模(20B参数)和对高分辨率细节生成的追求,Qwen-Image 对。等多种语言的高精度、高一致性渲染,为全球化设计、多语言内容创作打开了新大门。对于显存紧张的设备,可能需要考虑模型量化或调整生成分辨率等优化手段。,开发者与研究者们得以自由探索这一强大的视觉内容生成引擎。呈现,精准还原字体