简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

基于 Transformer 的大语言模型(LLMs)正呈现出明显的规模扩张趋势,这导致了训练和推理阶段的成本大幅上升。然而,现有的方法如模型量化、知识蒸馏和模型剪枝各自存在限制,包括硬件支持受限、对大量训练的依赖以及对模型内部结构的修改等问题。本文提出了一种简洁的逐层结构化剪枝方法,称为层折叠(Layer Collapse, LaCo)。该方法通过将模型的后续层“折叠”进前面的某一层,实现了在保

大型语言模型(Large Language Models, LLMs)已成为自然语言处理的基石,但其使用伴随着在计算和内存资源方面的高昂代价。稀疏化(sparsification)提供了一种缓解这些资源限制的解决方案,近期的研究表明,训练好的模型可以在训练后进行稀疏化。然而,现有的稀疏化技术面临一些挑战:它们通常需要额外的数据结构,并且在现有硬件上只能带来有限的加速效果。在本文中,我们提出了一种新

本研究首次证明,大规模生成式预训练变换器(GPT)家族模型可通过单次剪枝实现至少50%的稀疏度,且无需任何重训练过程,精度损失极低。这一突破源于我们提出的新型剪枝方法SparseGPT——专为海量GPT类模型设计的高效精准剪枝方案。实验表明,SparseGPT可在4.5小时内完成当前最大开源模型OPT-175B和BLOOM-176B的剪枝处理,实现60%非结构化稀疏度的同时困惑度几乎无增长:这意味

鉴于大型预训练语言模型在情境学习方面取得的成功,我们提出情境学习蒸馏方法,将大模型的少样本情境学习能力迁移至小模型。该方法通过结合情境学习目标与语言建模目标,使小模型既能理解上下文示例又能掌握任务知识。我们在两种少样本学习范式下实施蒸馏:元情境微调(Meta-ICT)和多任务情境微调(Multitask-ICT)。实验表明,Multitask-ICT在多任务少样本学习中表现更优,但计算开销大于Me

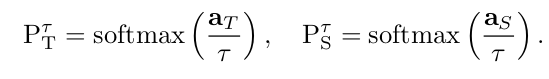

尽管增加网络深度通常能提升性能,但更深层的网络往往非线性更强,这使得基于梯度的训练变得更加困难。近期提出的知识蒸馏(knowledge distillation)方法旨在获得更小、执行更快的模型,其研究表明,学生网络可以模仿大型教师网络或集成网络的软输出(soft output)。本文中,我们扩展了这一思想:不仅使用教师网络的输出,还利用其学习到的中间表征(intermediate represe