简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

ollama服务默认以ollama用户启动运行在后台直接使用ollama pull 下载模型时,它会存于下,执行:20K/usr/share/ollama/.ollama/models/manifests 4 .4G/usr/share/ollama/.ollama/models/blobs 4 .4G/usr/share/ollama/.ollama/models/第一种方式:第二种方式:在执行

【代码】Linux离线安装ollama及注册模型。

如果网速太慢,下载老断,可直接下载zip。

虽然可以通过手动编写 Dockerfile 构建镜像,但过程繁琐(需要配置 VNC、桌面环境等)。更推荐使用现成方案如 KasmWeb,它提供开箱即用的 Ubuntu 桌面镜像,支持:一键部署和网页直接访问,这种方案既保留了容器的轻量化优势,又提供了完整的图形化体验,是开发、测试的理想选择。

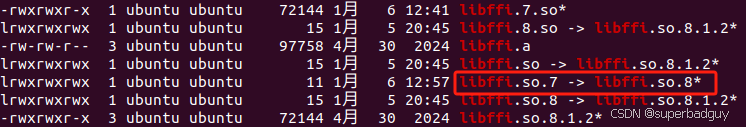

但我还遇到另一个大坑:运行时仍然报错!折腾了我好久,原来是c++的opnecv版本跟python的opencv-python不一致导致的,解决就是尽量。的操作,解决了编译问题。

ollama服务默认以ollama用户启动运行在后台直接使用ollama pull 下载模型时,它会存于下,执行:20K/usr/share/ollama/.ollama/models/manifests 4 .4G/usr/share/ollama/.ollama/models/blobs 4 .4G/usr/share/ollama/.ollama/models/第一种方式:第二种方式:在执行

【代码】Linux离线安装ollama及注册模型。

【代码】Linux离线安装ollama及注册模型。

ollama服务默认以ollama用户启动运行在后台直接使用ollama pull 下载模型时,它会存于下,执行:20K/usr/share/ollama/.ollama/models/manifests 4 .4G/usr/share/ollama/.ollama/models/blobs 4 .4G/usr/share/ollama/.ollama/models/第一种方式:第二种方式:在执行