简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

AIGC元年达到了学术-商业共振,本文介绍现有AI绘画、AI作画背后的相应基本原理、应用、以及论文参考文献。

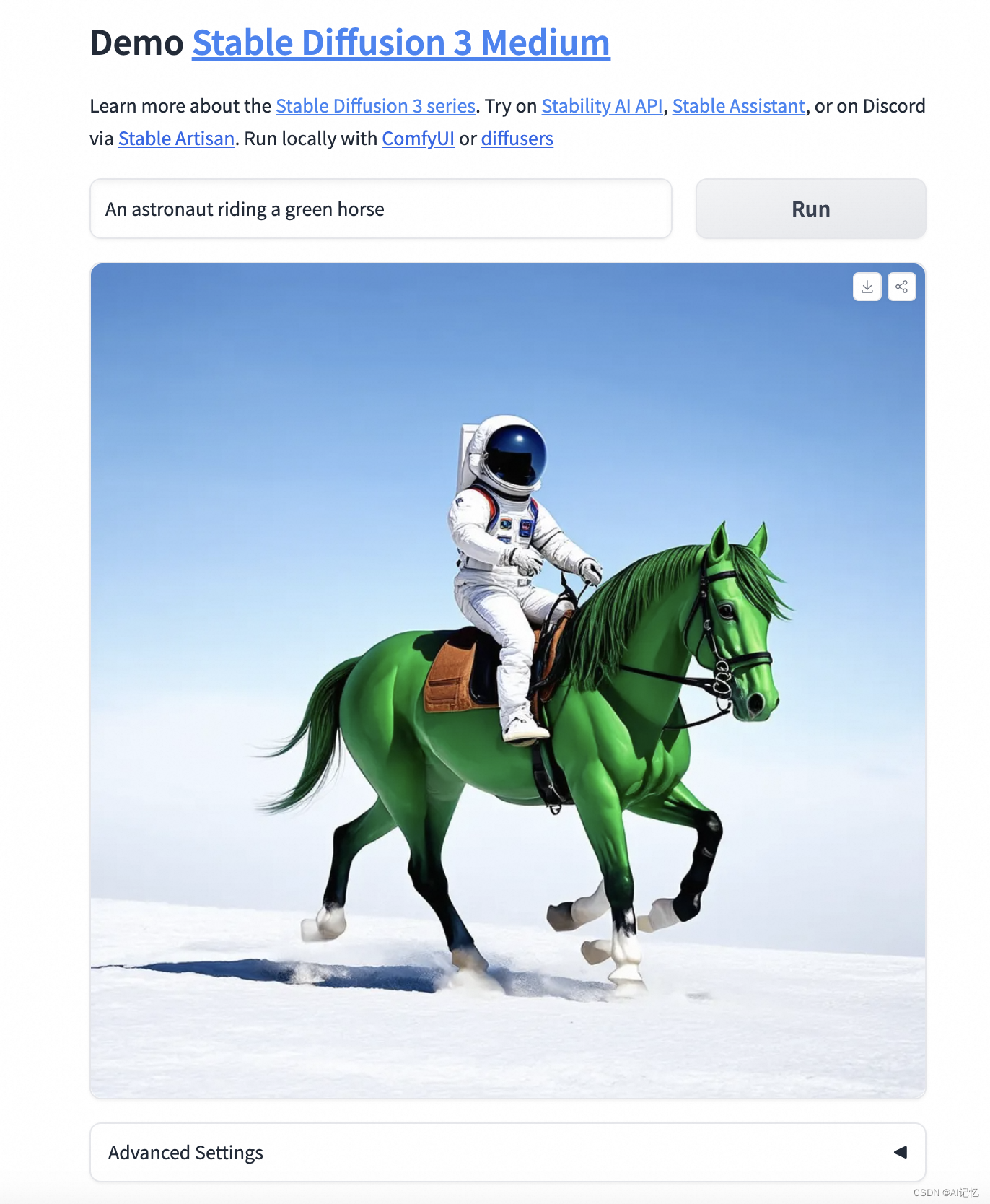

在数字艺术与AI的交汇处,Stable Diffusion 3(SD3)Medium版本的开源标志着技术革新的新篇章。继3月份我在CSDN上发表的SD3技术博文后,这一新里程碑的实现,展示了AI在图像生成领域的显著进步。通过Hugging Face平台的开源,SD3 Medium不仅为艺术创作提供了新土壤,也推动了文生图社区的发展。尽管存在挑战,社区的协作和技术创新将不断解锁创造潜力,引领我们进入

vgg和googlenet是2014年imagenet竞赛的双雄,这两类模型结构有一个共同特点是go deeper。跟googlenet不同的是,vgg继承了lenet以及alexnet的一些框架,尤其是跟alexnet框架非常像,vgg也是5个group的卷积、2层fc图像特征、一层fc分类特征,可以看做和alexnet一样总共8个part。根据前5个卷积group,每个group中的不同配置,

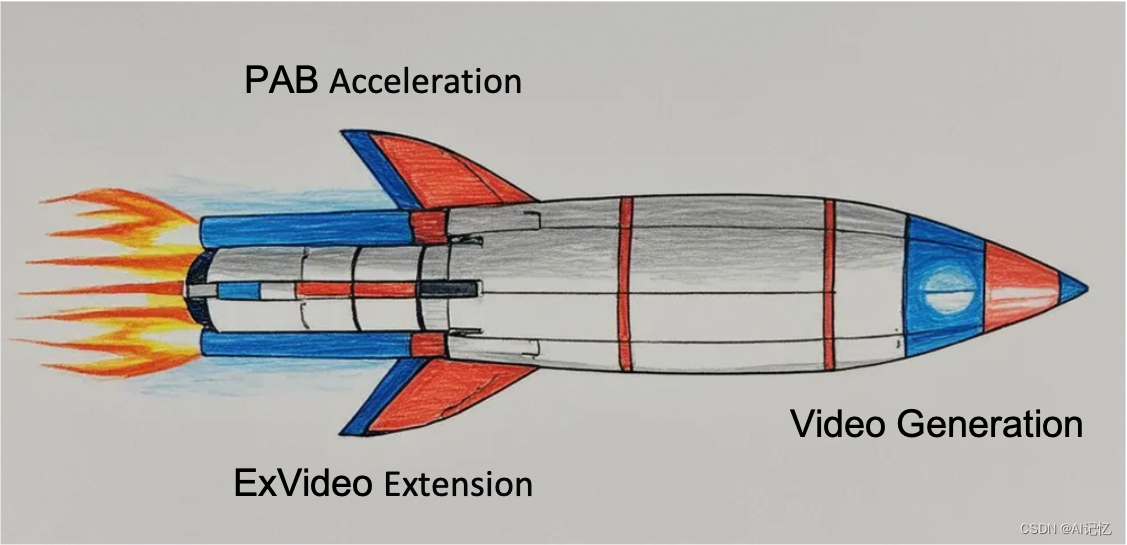

随着人工智能技术的不断进步,视频合成领域正迎来前所未有的发展机遇。本文介绍近期两项视频生成方向的创新技术:PAB(Pyramid Attention Broadcast)和ExVideo。这两篇文章合在一起主要介绍如何提升视频生成的速度与长度(当前视频生成主要瓶颈方向之一),从而实现更加高效和多样化的视频内容创作。

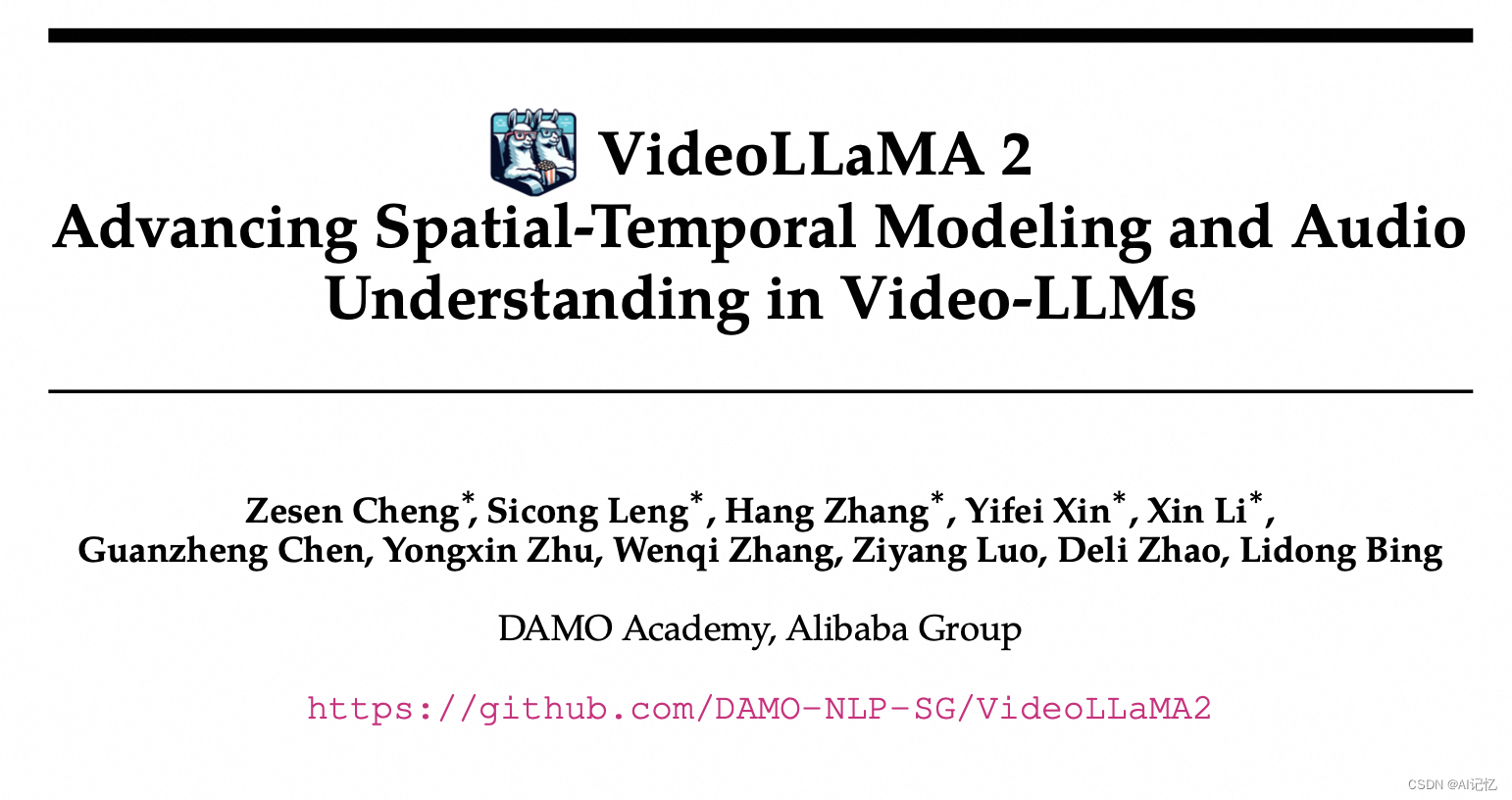

VideoLLaMA 2是阿里巴巴DAMO Academy团队开发的视频大型语言模型,专注于提升视频和音频任务的空间-时间建模与音频理解。该模型引入了新的时空卷积连接器,强化了对视频时空动态的捕捉能力,并通过联合训练集成音频分支,增强了多模态理解。在MC-VQA、OE-VQA和VC任务中,VideoLLaMA 2展现了与顶尖开源模型相媲美的性能,接近一些专有模型。

FaceChain-FACT:开源10秒写真生成,复用海量LoRa风格,基模友好型写真应用。FaceChain-FACT的代码和模型目前已经在github和modelscope创空间上同步开源。FaceChain-FACT具有简单的交互式界面设计,只需一张人物形象图片和简短的操作,即可实现无限风格写真和固定模板写真的生成。同时,FaceChain-FACT还支持包括指定人物姿态、自定义风格LoRA

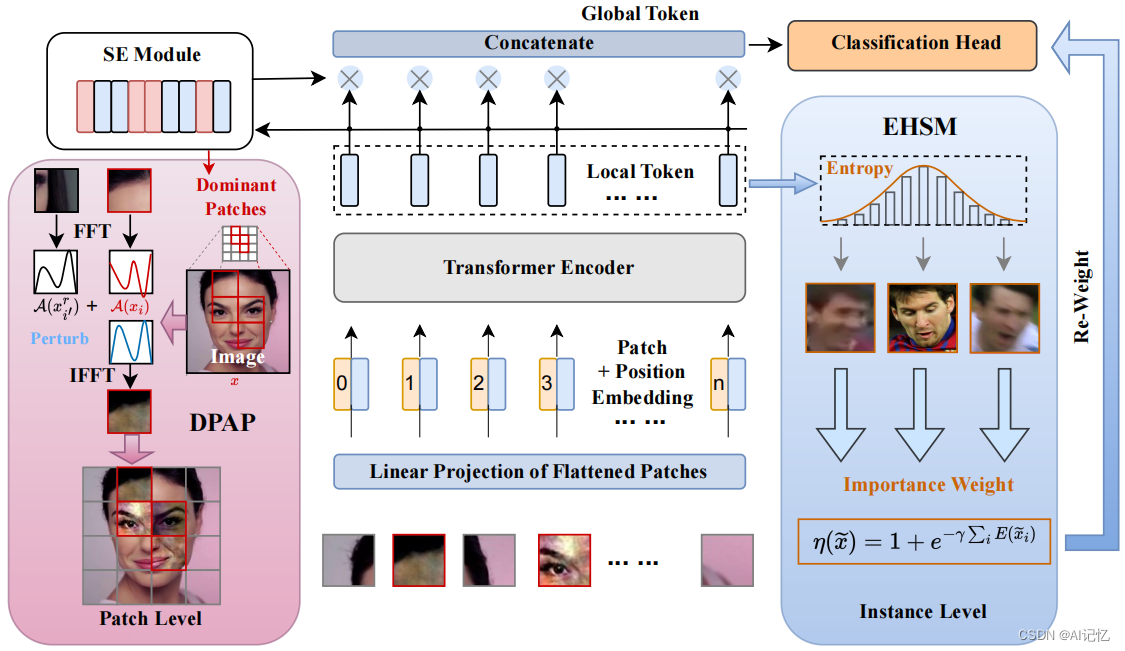

本文介绍由FaceChain团队出品的AIGC时代下的SOTA人脸表征提取器TransFace,可广泛应用于人物写真、人物视频等人物类数字孪生的应用研究中。

本文旨在解决离线强化学习中的互模拟缺陷。强化学习中的表征学习对于控制任务而言至关重要,将来的一个重要研究方向是将大模型为基础的文本或图像信息与控制任务对应的状态表征做进一步对齐。这里,互模拟为基础的表征算法可能是一个重要的未来研究方向,可能对多模态数据与控制任务的对齐起到关键性作用。

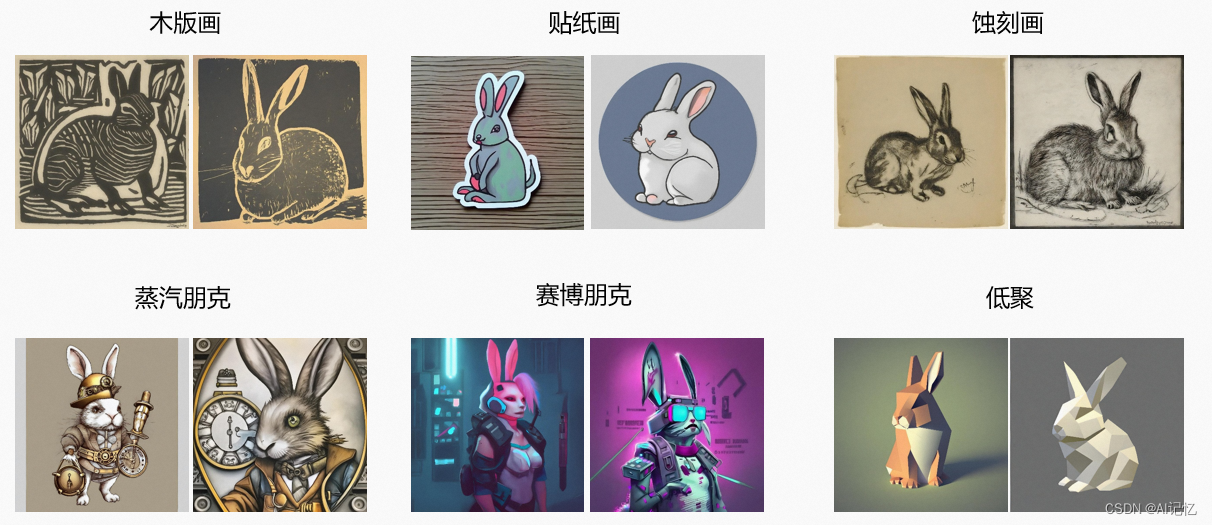

本文主要介绍AIGC体验方法,up主们纷纷使用AIGC进行短视频内容创作,能绘画天马行空的场景、栩栩如生的人物。如此精细的ai绘画和去年Stable Diffusion、MidJourney、DALL-E 2的横空出世息息相关,技术革新带来了令人震撼的效果。这些新技术可以提高创意的效率,缩短创意到实现的周期,并且能够在艺术设计、电影、游戏等领域产生巨大的影响。对于普通人来说,这些新技术可以提供更好

本文介绍开源图像上色一键体验,它是指对黑白图像添加色彩,使其变成彩色图像。更具体的说,我们常见的彩色图像通常是三通道图像,而黑白图像只有一个灰度通道,因此,图像上色旨在利用单一灰度通道恢复图像的两个彩色通道。随着摄影技术的演进,彩色照片在现在已经非常普及,但仍然有大量历史黑白照片遗留。图像上色可以对这些宝贵的旧时代遗产进行修复,令老照片重获新生。