简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

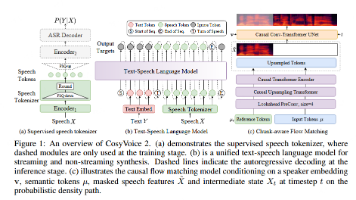

本文介绍了CosyVoice,这是一种可扩展的多语言零样本文本转语音合成器,其核心创新在于采用监督语义令牌(S³ tokens),该令牌通过在多语言语音识别模型编码器中插入矢量量化获得,相比现有无监督令牌,在零样本语音克隆的内容一致性和说话人相似度上表现更优。CosyVoice 由文本到令牌的大语言模型(LLM) 和令牌到语音的条件流匹配模型组成,无需额外的音素化器和强制对齐器,且利用大规模数据能

仓库地址:https://github.com/m-bain/whisperX。

Attention机制是一种动态加权融合信息的机制,广泛应用于深度学习模型中。Self-Attention和Cross-Attention是两种常见的注意力机制。Self-Attention的输入是同一个序列,通过计算序列内部元素之间的相关性来加权融合信息。Cross-Attention则处理两个不同的序列,通常用于序列间的信息交互,如文本到图像的生成任务。两者的核心步骤相似,包括线性变换、计算注

这篇论文提出了流式语音合成模型CosyVoice 2,其核心创新围绕高效流式合成、高质量语音生成及多场景适配展开,结合大型语言模型(LLMs)与流匹配技术,实现了接近人类水平的自然度和极低延迟。以下是核心创新及原理细节的总结

看了一篇 《人工智障 2 : 你看到的AI与智能无关》觉得文章写得很棒,对几个戳中的核心观点进行简单记录:① 当前对话系统的本质:填表(当然,我认为填表其实就是关键信息的提取,但是作为灵活对话,就会比较僵硬和局限)② 对话的最终目的是为了同步思维③ 对话是思想从高维度向低维的投影④ 当人接收到低维的语言之后,会结合引用常识、自身的世界模型(后详),来重新构建一个思维中的模型,对应这个语...

一文综述详尽图像数据增强方法

记录:https://blog.csdn.net/weixin_43357695/article/details/126063091。

使用 -ss 选项指定需要截取的开始时间,结合 -to 或者 -t。

记录一下:深度学习模型参数量以及FLOPs计算工具大模型训练需要花费多长时间:FLOPs的简单计算方法及calflop开源实现