简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文验证了在容器中运行 QEMU/KVM 虚拟机是可行的, 可以正常使用 Linux 内核的 KVM 硬件加速. podman 可以普通用户运行, 无需 root 权限, 所以普通用户也可以运行 QEMU/KVM 虚拟机.

由于本文太长, 分开发布, 方便阅读.

使用 llama-factory 工具可以对 AI 语言模型 (LLM) 进行微调 (LoRA SFT), 只需准备数据集即可.可以看到, AI 具有一定的泛化能力, 也就是训练数据集中没有的问题, 模型也可以给出比较合理的回答.此处使用的丹炉不好, 炼不了上品仙丹, 只能用个小模型意思意思. 但原理和操作步骤都是一样的, 只要换上更好的硬件, 准备更多数据, 就能炼制更好更大的仙丹啦 ~AI 并

通过自制 fish-speech 容器镜像, 并添加参考音频数据, 窝们成功获得了一只封装好的派蒙罐头 (真·应急食品). 随便放在哪里都可以直接运行, 无需网络, 很是方便好用.CPU 推理确实很慢, 后续计划寻找无需 N 卡条件下, 更快运行大模型的方法.本文使用 CC-BY-SA 4.0 许可发布.

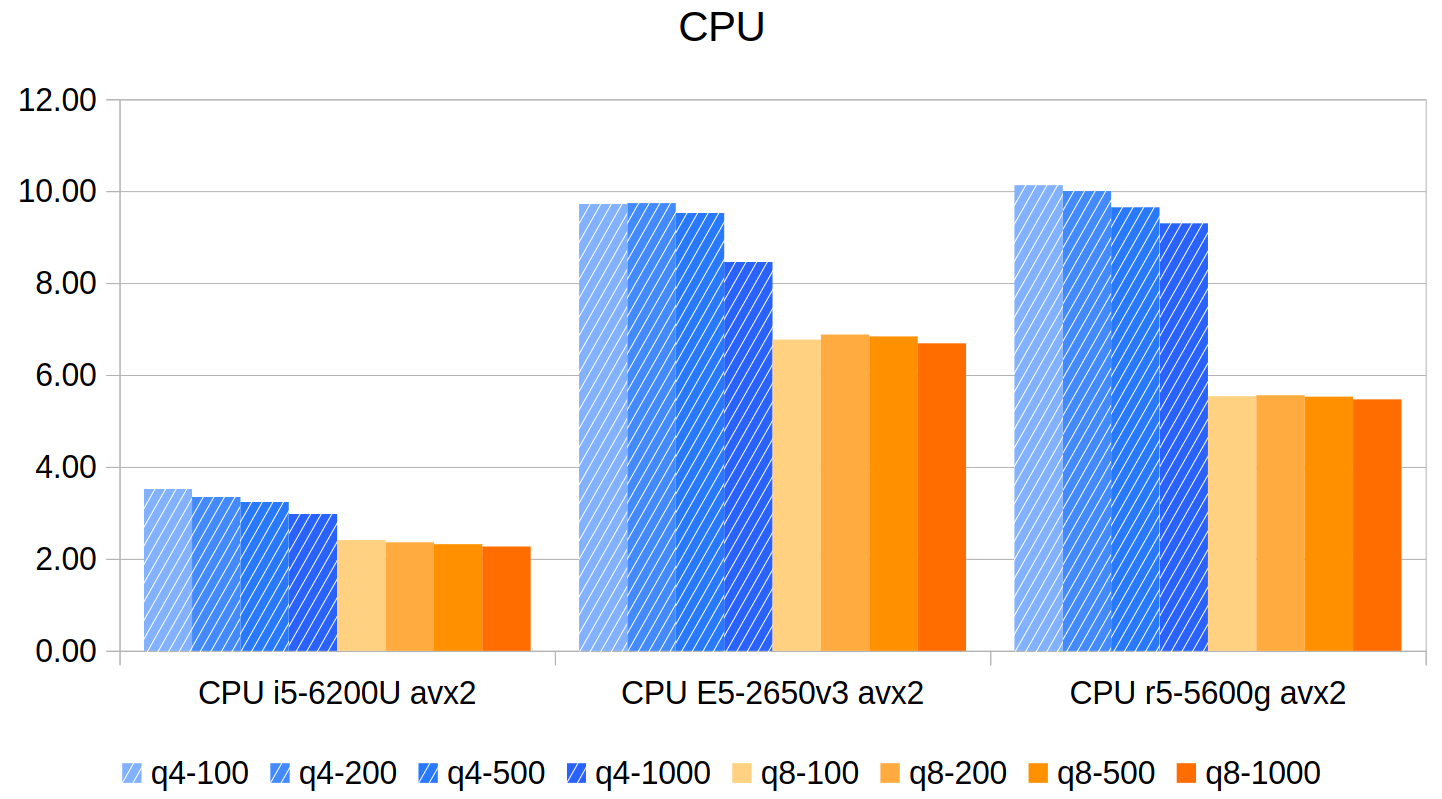

通过llama.cpp运行 7B.q4 (4bit 量化), 7B.q8 (8bit 量化) 模型, 测量了生成式 AI 语言模型在多种硬件上的运行 (推理) 速度.根据上述测量结果, 可以得到以下初步结论:(1)显存 (内存) 大就是正义!大, 就是正义!!限制能够运行的模型规模的最主要因素, 就是显存的大小.目前的大部分显卡 (除了高端的比如 4090), 显存都不超过 16GB.

随着 AI 语言大模型越来越强, 在 AI 的辅助下写小说就越来越容易啦 ~相比被动的阅读别人写好的小说, 写出自己的小说, 是一种更快乐的娱乐方式. 加油!本文只使用了 epub 最简单的功能 (章节标题), epub 还有很多功能可以继续深入挖掘.

时代:22世纪,资本主义晚期社会主角:苏棠(54岁离婚富婆)、顾尘(22岁绘画临时工)核心情节:苏棠离婚后收购“备用肉身虫”初创团队,将最初用于小鼠的技术发展为可制造全新人体(不含大脑)的系统。她以54岁高龄通过该技术获得20岁外观的年轻身体,与作为“实验样本”的底层青年顾尘在末日堡垒“琥珀居”相爱,生下女儿顾雪,完成肉身虫技术的终极验证。主题:科技重构身体与爱情、年龄与阶级的跨越、人类对衰老的挑

随着 AI 语言大模型越来越强, 在 AI 的辅助下写小说就越来越容易啦 ~相比被动的阅读别人写好的小说, 写出自己的小说, 是一种更快乐的娱乐方式. 加油!本文只使用了 epub 最简单的功能 (章节标题), epub 还有很多功能可以继续深入挖掘.

该续作计划世界观完整、设定硬核、人物立体,既紧密承接前作的人物与科幻核心,又通过“核战后”“星际移民”的设定实现格局升级,将“技术、爱情、权力、文明”四大元素深度绑定,兼具科幻感与人文深度。核心优势在于“科幻设定服务剧情”“人物特质贴合时代背景”,潜在突破点在于挖掘独裁统治、记忆丢失、星际旅行中的冲突,让“人类从末日走向星际”的主线更具张力。需要我帮你基于这份分析,提炼10个核心剧情冲突点(适配长

近些年, 国际形势变化很快, 各种不确定因素越来越多. 所以,任何单个平台都是不可靠的, 随时可能出现各种各样奇奇怪怪的问题.因此, 重要数据一定要多备份!!本文是 《git 免费开源平台推荐 4+7 个》 的更新版本:本文使用 CC-BY-SA 4.0 许可发布.