简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Transformer层剪枝的核心思想是评估每个层、注意力头或权重对模型性能的重要性,然后根据评估结果去掉那些对模型性能贡献较小的部分。Transformer层剪枝是一种针对Transformer模型(如BERT、GPT等)中的自注意力模块和前馈网络进行剪枝的方法,旨在减少模型的参数量和计算开销。在这种方法中,模型的剪枝对象通常是具有特定结构的部分,例如卷积神经网络中的整个滤波器或通道,而不是单个

量化(Quantization)是一种在计算机科学和深度学习中广泛应用的技术,其基本目标是通过减少模型中数值表示的位宽来降低计算和存储成本。简单来说,量化就是将高精度(通常是浮点数)转换为低精度(通常是定点数)表示,同时尽量保持模型的性能和准确性。量化通常用于深度学习模型(尤其是大模型)中,以减小模型的存储空间和提高推理速度。量化不仅可以减少模型的内存占用,还能提高硬件的计算效率,尤其是在低功耗设

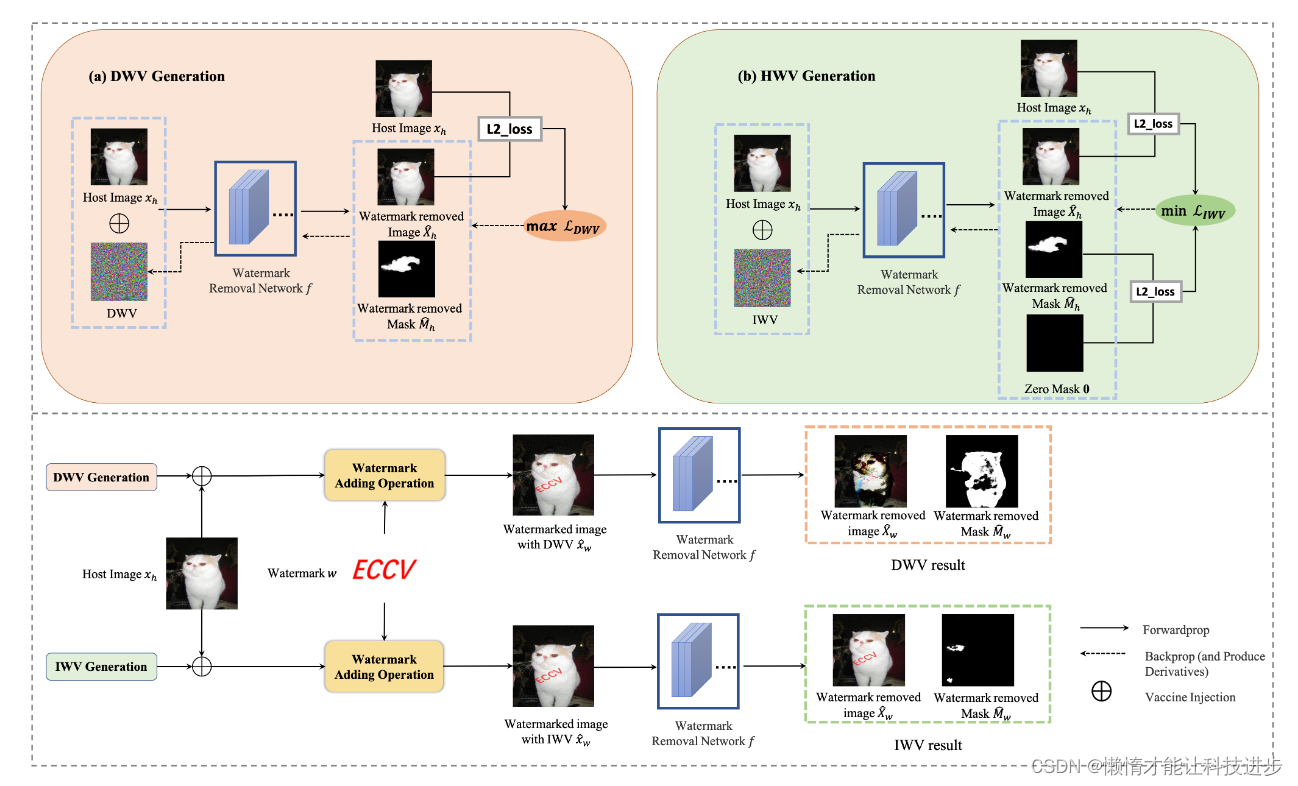

论文方法的局限性水印尺寸和透明度:实验表明,水印尺寸变大或水印的透明度参数α\alphaα变大时,DWV和IWV的保护效果会下降。这意味着水印疫苗的性能在一定程度上取决于水印变化∥w∥∥w∥的大小,更好的保护效果依赖于较小的∥w∥∥w∥变化。版权所有者的挑战:版权所有者需要在水印的大小和透明度之间做出选择,以便既便于版权识别又能有效保护水印。大尺寸和低透明度水印有助于版权识别,而小尺寸和高透明度水

在大规模语言模型的实际应用中,微调需要耗费巨大的计算资源和内存,因为要微调整个模型的参数(通常有数十亿甚至数千亿个参数)。**LoRA通过只训练新增的低秩矩阵,使得训练过程变得更加轻量**,同时减少了存储需求。这在许多硬件资源受限的场景中尤为有用。

P-Tuning是一种参数高效的微调方法,旨在通过引入可学习的提示(Prompt)来改进预训练语言模型在特定任务中的表现。与传统的全参数微调相比,P-Tuning 只需要微调少量的额外参数,使得模型在执行任务时更加高效,并且能够适应多种下游任务。在 P-Tuning 中,提示(Prompt)是一些附加到输入上的可学习向量,这些向量作为模型的输入,帮助调整模型的行为。通过对这些可学习提示进行训练,模

LoRA(Low-Rank Adaptation)是一种参数高效的微调技术,旨在降低微调大规模预训练模型的存储和计算成本。**其核心思想是通过对模型的特定参数进行低秩分解,仅对少量附加参数进行训练,从而完成任务适应,而无需更新整个模型的权重。**这种方法通过引入额外的低秩矩阵来适应新的任务,保持了预训练模型的核心知识,使其更具灵活性和高效性。

在 Llama 2 的监督微调(Supervised Fine-Tuning, SFT)阶段,研究团队对模型进行了进一步的调优,以提升其生成对话和其他任务的表现。以下是 SFT 过程的详细讲解:

KDEP(Knowledge Distillation as Efficient Pre-training)在论文 “Knowledge Distillation as Efficient Pre-training” 中提出,主要聚焦于通过知识蒸馏实现高效的模型预训练。

P-Tuning是一种参数高效的微调方法,旨在通过引入可学习的提示(Prompt)来改进预训练语言模型在特定任务中的表现。与传统的全参数微调相比,P-Tuning 只需要微调少量的额外参数,使得模型在执行任务时更加高效,并且能够适应多种下游任务。在 P-Tuning 中,提示(Prompt)是一些附加到输入上的可学习向量,这些向量作为模型的输入,帮助调整模型的行为。通过对这些可学习提示进行训练,模

量化(Quantization)是一种在计算机科学和深度学习中广泛应用的技术,其基本目标是通过减少模型中数值表示的位宽来降低计算和存储成本。简单来说,量化就是将高精度(通常是浮点数)转换为低精度(通常是定点数)表示,同时尽量保持模型的性能和准确性。量化通常用于深度学习模型(尤其是大模型)中,以减小模型的存储空间和提高推理速度。量化不仅可以减少模型的内存占用,还能提高硬件的计算效率,尤其是在低功耗设