简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

LeNet是一种经典的卷积神经网络架构,于1998年由Yann LeCun等人提出,被广泛应用于手写数字识别任务。它是深度学习中的里程碑之一,为后来的卷积神经网络的发展奠定了基础。LeNet的设计灵感来自于人类视觉系统的结构。它由一系列的卷积层、池化层和全连接层组成,用于从输入图像中提取特征并进行分类。其中最为典型的就是。

LeNet是一种经典的卷积神经网络架构,于1998年由Yann LeCun等人提出,被广泛应用于手写数字识别任务。它是深度学习中的里程碑之一,为后来的卷积神经网络的发展奠定了基础。LeNet的设计灵感来自于人类视觉系统的结构。它由一系列的卷积层、池化层和全连接层组成,用于从输入图像中提取特征并进行分类。其中最为典型的就是。

卷积神经网络(Convolutional Neural Networks,简称CNN)是一种具有局部连接、权值共享等特点的深层前馈神经网络(Feedforward Neural Networks),是深度学习(deep learning)的代表算法之一,擅长处理图像特别是图像识别等相关机器学习问题,比如图像分类、目标检测、图像分割等各种视觉任务中都有显著的提升效果,是目前应用最广泛的模型之一。卷积

(Prime number),又称,指在大于的中,除了1和该数自身外,无法被其他自然数的数(也可定义为只有1与该数本身两个正因数的数)。大于1的自然数若不是素数,则称之为(也称为合成数)。例如,是个素数,因为其正约数只有1与5。7是个素数,因为其正约数只有1与7。而4则是个合数,因为除了1与4外,2也是其正约数。6也是个合数,因为除了1与6外,2与3也是其正约数。确立了素数于里的核心地位:任何大于

VGG16是一种深度卷积神经网络模型,用于图像分类和识别任务。它是由牛津大学的研究团队开发的,命名为Visual Geometry Group(VGG),并在2014年的ImageNet图像识别挑战中取得了很好的成绩。VGG16模型具有13个卷积层和3个全连接层,总共有约138百万个可训练参数。该模型的核心思想是通过堆叠多个小尺寸的卷积核和池化层来增加网络的深度,从而提高图像特征的表示能力。它采用

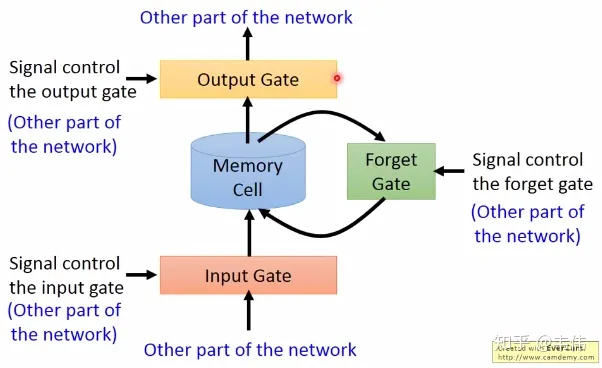

首先解释一下,经过这个sigmod激活函数后,得到的都是在0到1之间的数值,1表示该门完全打开,0表示该门完全关闭,其中是最为普通的输入,可以从上图中看到,是通过该时刻的输入和上一时刻存在memory cell里的隐藏层信息向量拼接,再与权重参数向量点积,得到的值经过激活函数tanh最终会得到一个数值,也就是,注意只有的激活函数是tanh,因为是真正作为输入的,其他三个都是门控装置。再来看,inp

ST-GCN应当具备能够从时空维度提取特征的能力,其在GCN中的表现就是能够同时聚合时空维度的信息,如下图所示。其具体网络层如图所示:步骤1:引入一个可学习的权重矩阵(与邻接矩阵等大小)与邻接矩阵按位相乘。该权重矩阵叫做“Learnable edge importance weight”,用来赋予邻接矩阵中重要边(节点)较大的权重且抑制非重要边(节点)的权重。步骤2:将加权后的邻接矩阵与输入送至G

ST-GCN应当具备能够从时空维度提取特征的能力,其在GCN中的表现就是能够同时聚合时空维度的信息,如下图所示。其具体网络层如图所示:步骤1:引入一个可学习的权重矩阵(与邻接矩阵等大小)与邻接矩阵按位相乘。该权重矩阵叫做“Learnable edge importance weight”,用来赋予邻接矩阵中重要边(节点)较大的权重且抑制非重要边(节点)的权重。步骤2:将加权后的邻接矩阵与输入送至G

首先解释一下,经过这个sigmod激活函数后,得到的都是在0到1之间的数值,1表示该门完全打开,0表示该门完全关闭,其中是最为普通的输入,可以从上图中看到,是通过该时刻的输入和上一时刻存在memory cell里的隐藏层信息向量拼接,再与权重参数向量点积,得到的值经过激活函数tanh最终会得到一个数值,也就是,注意只有的激活函数是tanh,因为是真正作为输入的,其他三个都是门控装置。再来看,inp