简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

【代码】PyTorch常用命令(可快速上手PyTorch的核心功能,涵盖从数据预处理到模型训练的全流程)

摘要:VLA(视觉-语言-动作)与WA(世界行为)是智能驾驶领域的两种核心技术范式。VLA通过语言中枢实现认知推理,擅长复杂任务理解和泛化;WA则直接建模物理世界,在空间感知和实时控制方面表现优异。二者各具优势:VLA具有更好的可解释性和任务统一性,WA则在运动精确性和实时性上更突出。当前行业呈现分立发展态势,但未来趋势指向二者的深度融合,通过结合认知推理与物理建模,推动智能系统向更高层次的通用智

总结:在终端运行时,显示找不到某文件或程序(但是此文件就在当前执行程序的目录下,如上图中的mmdetection3d目录下),也可以在终端执行次命令,来设置临时环境变量,代表此临时环境变量为mmdetection3d目录下均是。

安装打包下载好的环境;把不好安装的库放入环境中

1、使用pip,先安装d2l(保证d2l可以正常安装的前提下,再用pip自动去匹配合适的其他库)、再安装torch、torchvision。(3)安装torch,torchvision(不指定版本,让pip自动去匹配)(1)创建环境d2l-zh。

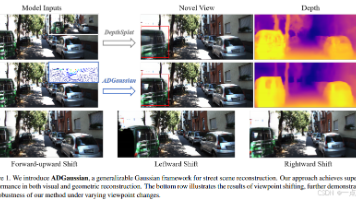

《ADGaussian:基于多模态输入的自动驾驶通用高斯泼溅方法》提出了一种创新的街道场景重建框架。该研究通过融合单目图像和稀疏LiDAR深度数据,构建多模态联合优化模型,解决了传统方法泛化性差和多模态融合不足的问题。核心创新包括:1)多模态特征匹配机制,利用Siamese编码器和交叉注意力实现深度-图像特征交互;2)深度引导位置嵌入增强3D空间感知;3)多尺度高斯解码器实现几何与外观解耦预测。在

如果此文章对您有所帮助,那就请点个赞吧,收藏+关注 那就更棒啦,十分感谢!!!

PyTorch 凭借其灵活性、易用性和强大的社区支持,已成为深度学习领域的“科研标准”,并逐步渗透到工业场景。其发展史反映了从研究到生产的平衡艺术,未来将继续推动 AI 技术的边界。Torch 以其灵活的神经网络设计和高效的 GPU 加速闻名,但受限于 Lua 的小众性和陡峭的学习曲线,始终未成为主流。官方库覆盖 CV(TorchVision)、NLP(TorchText)、音频(TorchAud

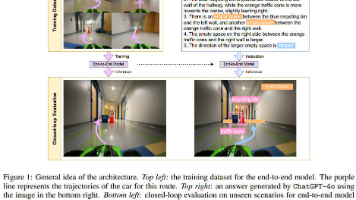

2024年12月,纽约Stony Brook大学、UIC和桑瑞思公司联合发表了一篇关于自动驾驶的论文,提出了一种新型架构,将多模态大型语言模型(LLM)集成到端到端自动驾驶模型中,以增强其在现实环境中的泛化能力。传统自动驾驶方法采用模块化设计,存在误差累积问题,而端到端方法直接从传感器数据输出动作,但需要大量训练数据。本文提出的架构通过LLM定期生成高级驾驶指令,指导端到端模型,降低了对数据的需求

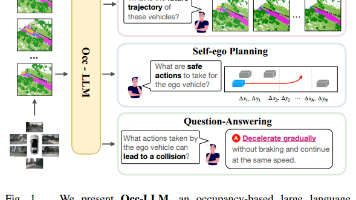

大型语言模型(LLMs)在机器人和自动驾驶领域取得了长足的进步。本研究提出了第一个基于占用的大型语言模型(Occ LLM),它代表了将LLM与重要表示相结合的开创性努力。为了有效地将占用率编码为LLM的输入,并解决与占用率相关的类别不平衡问题,我们提出了运动分离变分自编码器(MS-VAE)。这种创新方法利用先验知识在将动态对象输入到定制的变分自动编码器(VAE)之前将其与静态场景区分开来。这