简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要:机器学习和深度学习是AI领域的核心概念。机器学习是更广泛的范畴,依赖人工特征提取;深度学习作为其子集,通过神经网络自动学习特征。关键区别在于:机器学习适合小数据、解释性强的场景(如银行风控),只需CPU运算;深度学习需要海量数据和GPU支持,擅长处理图像/语音等复杂任务(如人脸识别),但解释性差。选型需综合考虑数据量、任务复杂度及计算资源,结构化数据常用机器学习,非结构化数据多用深度学习。

摘要:本文用"超级厨房"比喻解析AI硬件分工:CPU是统筹主厨,GPU是并行切菜团,显存则是关键灶台案板。以7B大模型为例,显存容量决定能否运行(门槛),GPU核心数影响速度(TFLOPS),CPU处理数据供给(防短板),而显存带宽(如HBM)对大规模训练尤为关键。完整流程展示了数据从CPU预处理到GPU计算的流转过程,指出硬件配置需平衡各环节,避免因显存不足或CPU瓶颈导致G

摘要:本文用"超级厨房"比喻解析AI硬件分工:CPU是统筹主厨,GPU是并行切菜团,显存则是关键灶台案板。以7B大模型为例,显存容量决定能否运行(门槛),GPU核心数影响速度(TFLOPS),CPU处理数据供给(防短板),而显存带宽(如HBM)对大规模训练尤为关键。完整流程展示了数据从CPU预处理到GPU计算的流转过程,指出硬件配置需平衡各环节,避免因显存不足或CPU瓶颈导致G

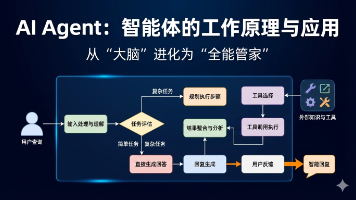

文章摘要: AIAgent(智能体)实现了从"缸中之脑"到"全能管家"的进化,为LLM配备了感知、工具和规划能力。其核心采用"双轨制"逻辑:先评估任务复杂度,再分流执行简单对话或复杂任务。对于复杂任务,Agent能自主拆解目标、调用工具并整合结果,具备自我纠错能力。这种架构如同操作系统,将LLM的推理能力转化为实际执行力,突破了数字与物理

摘要:RAG(检索增强生成)技术通过"开卷考试"模式解决大模型的时效性和幻觉问题。其核心流程分为三阶段:1)索引阶段将文档切片并向量化存储;2)检索阶段计算用户问题与文档片段的相似度;3)生成阶段结合检索结果输出答案。RAG具有四大优势:避免幻觉、保持时效性、保护数据隐私、确保答案可溯源。该技术作为用户与大模型间的中间层,通过检索外部知识库增强提示词,约束模型仅基于最新资料作答

摘要:NLP领域的关键路线之争是BERT的双向理解(MLM)与GPT的单向生成(CLM)。BERT通过完形填空任务训练,能双向分析但生成能力弱;GPT通过文字接龙任务训练,专注单向生成但通用性更强。GPT胜出的三大原因:1)生成任务兼容理解任务;2)数据利用率更高;3)训练与推理场景一致。最终,当模型规模足够大时,GPT不仅保持生成优势,理解能力也超越BERT,使CLM路线成为大模型时代的主流选择

摘要:DeepSeek的MLA和LoRA技术通过低秩分解实现高效参数压缩,将高维特征向量压缩为少量"精华数字"存储,使用时再还原。这一过程利用压缩器和生成器矩阵:前者提取核心特征(如从4维压至2维),后者恢复完整维度。该技术基于"低秩假设",在节省50%显存的同时保持计算效率,使大模型兼具轻量化和高性能特性。典型场景下,输入向量经过降维-升维处理后,能完整保

未来的两个风口?论如何将大模型与车联网结合!