简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

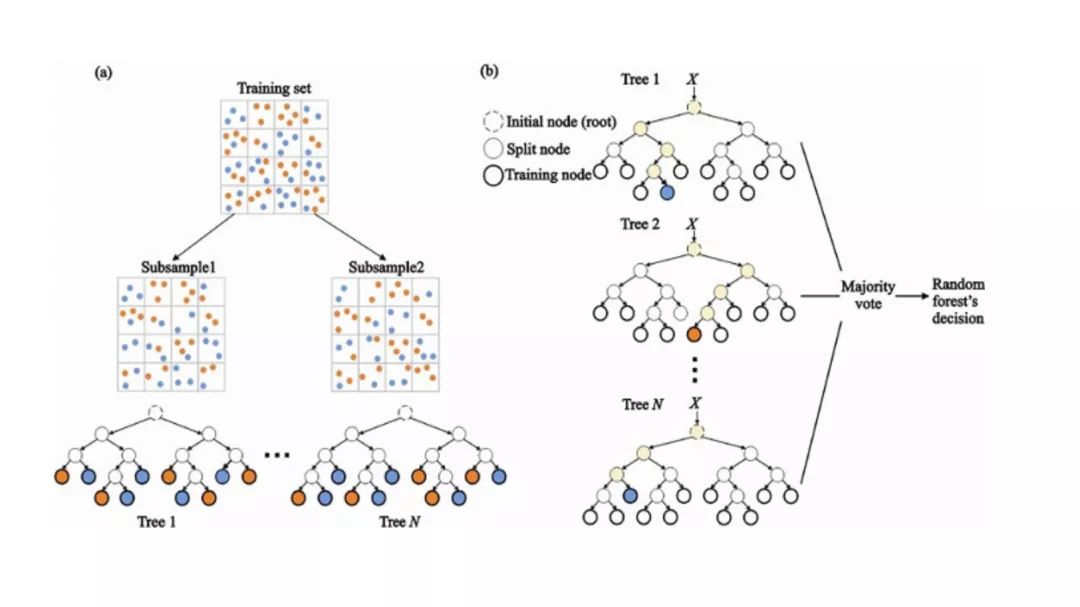

人工智能已经存在于我们生活中很久了。但对很多人来讲,人工智能还是一个较为“高深”的技术,然而再高深的技术,也是从基础原理开始的。人工智能领域中就流传着10大算法,它们的原理浅显,很早就被发现、应用,甚至你在中学时就学过,在生活中也都极为常见。

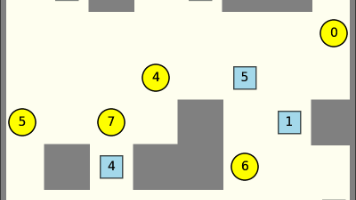

本文详细介绍了多智能体路径规划(MAPF)中的经典算法CBS(Conflict-Based Search)。CBS采用两层搜索结构:高层在约束树上检测冲突并添加约束(禁止某智能体在特定时间占据特定位置/边),低层则对受影响智能体重新运行A*算法规划路径。文章通过伪代码和Python实例演示了CBS的实现,并重点澄清了"为何不能简单用等待动作解决冲突"的常见误区——等待可能导致连

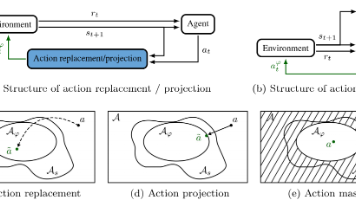

本文系统介绍了安全强化学习(SafeRL)的发展与应用,重点阐述了可证明安全强化学习(ProvablySafeRL)的三种核心技术:动作替换、动作投影和动作掩码。文章梳理了该领域从早期探索到深度安全强化学习的发展历程,并分析了各类方法的优缺点与适用场景。研究通过倒立摆、无人机悬停等实验验证了这些技术的安全性,其中动作替换表现最佳。当前挑战包括高维状态验证、Sim2Real安全差距和多智能体协同等问

随机网络蒸馏(RND)是一种自监督学习方法,旨在提高强化学习中的探索效率。该算法由 Chesney et al. 在论文《Random Network Distillation as a Method for Intrinsic Motivation》提出,RND 利用随机神经网络的输出与环境状态的真实特征之间的差异来生成内在奖励,鼓励智能体探索未见过的状态。这种方法尤其适用于外部奖励稀疏的环境。

解耦表示学习,Decoupled Representation Learning (DRL) 是一种用于在自监督强化学习(Self-Supervised Reinforcement Learning, SSRL)中学习解耦表示的算法。DRL旨在通过将表示学习和策略学习过程分离,以实现更高效的学习。该算法适用于许多强化学习场景,特别是在高维观测(如图像、视频等)中,有效提取低维、独立的状态表示,帮助

多智能体强化学习(Multi-Agent Reinforcement Learning, MARL)在许多应用场景中面临巨大挑战,如智能体之间的协作、竞争以及在复杂环境中的策略优化。在多智能体系统中,如何让各个智能体有效协作、合理分工,最大化整体性能是一个核心问题。面向角色的多智能体强化学习(Role-Oriented Multi-Agent Reinforcement Learning, ROM

REINFORCE 是一种策略梯度算法,用于强化学习中的策略优化问题。它的核心思想是直接优化策略,通过采样环境中的轨迹来估计梯度并更新策略。PG(Policy Gradient)算法是一个更大的算法框架,而 REINFORCE 是 PG 算法的一种具体实现。因此,比较两者的关键在于 PG 的普适性和 REINFORCE 的具体特性。

强化学习中的深度Q网络(DQN)是一种将深度学习与Q学习结合的算法,它通过神经网络逼近Q函数以解决复杂的高维状态问题。然而,DQN存在过估计问题(Overestimation Bias),即在更新Q值时,由于同时使用同一个网络选择动作和计算目标Q值,可能导致Q值的估计偏高。Double DQN(DDQN)引入了“双网络”机制来缓解这个问题,从而提高了算法的稳定性和收敛性。

Sarsa算法是一种强化学习(Reinforcement Learning, RL)的经典算法,属于时序差分(Temporal Difference, TD)方法。它是一种基于策略的学习算法,用于解决马尔可夫决策过程(Markov Decision Process, MDP)中的问题。简单来说,Sarsa的目标是通过不断地交互,学习如何从当前状态选择最优动作,从而获得最大的累积奖励。

在强化学习(Reinforcement Learning, RL)中,智能体通过与环境的交互来学习一个策略,以最大化长期累积回报。然而,传统的强化学习算法在优化回报时往往不考虑智能体行为的安全性,导致在训练或部署过程中可能出现不安全的行为。**安全强化学习(Safe Reinforcement Learning,Safe RL)**正是在此背景下提出的,它旨在在优化回报的同时确保智能体的行为符合某