简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

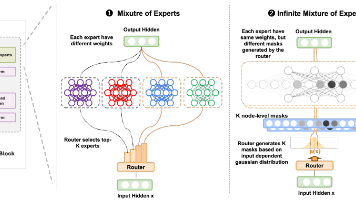

本文提出 ∞-MoE,它将 MoE 从有限的专家集合扩展到连续(实际上无限)的专家空间。它仅为每个 token 激活少数几个采样专家,保持了类似 MoE 的效率,同时提高了准确性。在 GPT-2 Small 和 Medium 上,∞-MoE 优于 Switch Transformer 和标准 MoE。

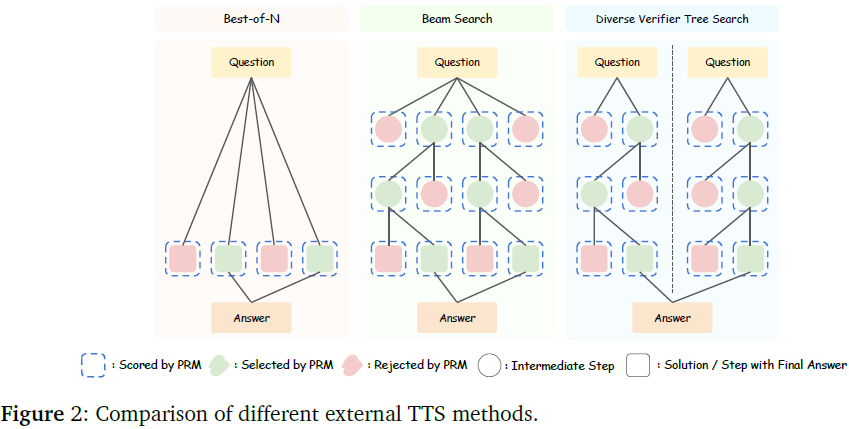

本文探讨了测试时扩展(TTS)如何通过推理阶段的额外计算提升大型语言模型(LLM)的性能,尤其分析了 策略模型、过程奖励模型(PRMs)及 问题难度 对 TTS 策略的影响。

L2D 通过结合扩散模型的推理增强能力,使大语言模型能够更高效地利用计算资源,提高复杂任务的推理能力。这项研究为未来的大语言模型微调提供了一条新的方向,通过引入扩散计算框架,使模型能够智能调整计算资源,提高推理质量

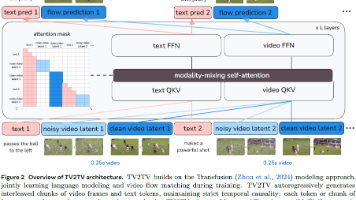

本文介绍了 TV2TV,一个将视频生成分解为交错式文本和视频生成过程的统一建模框架。通过以交错方式生成文本和视频,可将视频生成的大部分语义复杂性卸载到模型的文本生成组件,并实现了生成过程中更灵活有效的用户控制。

本文提出 NSA(原生稀疏注意力),它通过算法创新和硬件优化相结合,实现高效的长文本建模。NSA 采用动态分层稀疏策略,结合粗粒度的 token 压缩和精细粒度的 token 选择,在保留全局上下文感知的同时确保局部精度。

Kimi-VL 是一款在多模态与纯文本预训练/微调之间实现平衡的视觉语言模型,基于 MoE 架构,兼具扩展性与效率。Kimi-VL 在多模态、长上下文和高分辨率任务中表现出强大的适应性与效率,具有良好的研究与产业应用前景。

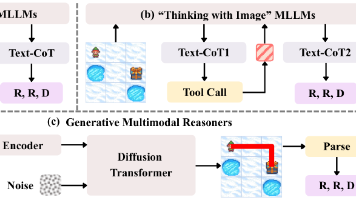

DiffThinker 是一种生成式多模态推理范式。通过运用扩散模型,将多模态推理从传统的以文本为中心的符号映射重构为原生的生成式图像到图像任务,使模型能够在视觉空间中进行推理,获得更优越的逻辑一致性与空间精确度。

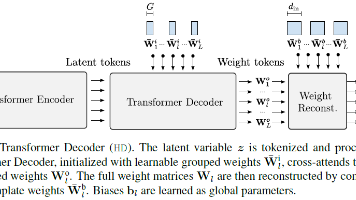

本文提出 LDMI,结合了 INR 的表达力与 LDM 的生成能力。HD 解码器使用 Transformer 架构支持概率建模,克服了 MLP 超网络的扩展性与确定性局限。LDMI 可灵活迁移已有模型至函数生成任务,适用于图像、3D、气候等多模态数据,支持高分辨率重建与生成

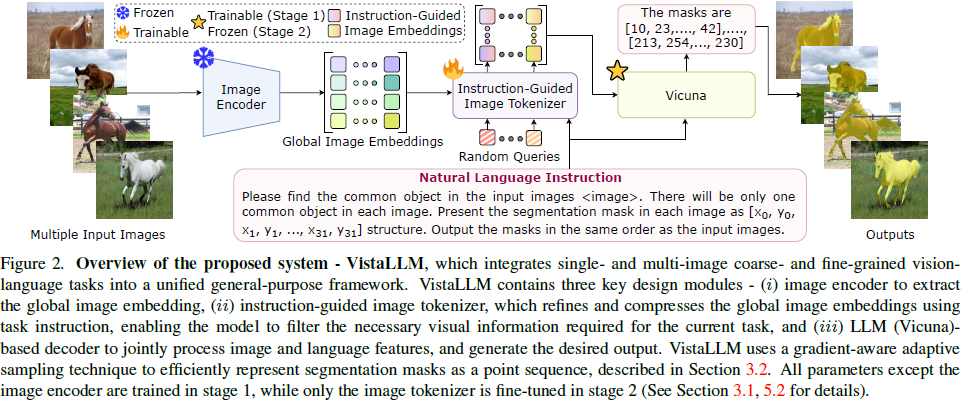

本文提出 VistaLLM,一个通用视觉系统,能够在单图像和多图像输入的情况下,同时处理 粗粒度和细粒度的视觉-语言任务。该模型利用指令引导的图像编码器和梯度感知自适应采样技术来优化输入处理,并使用新构建的数据集(CoinIt) 进行训练

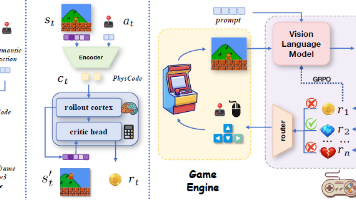

IPR 是一种通过将以物理为中心的潜在动作空间与预测引导的 VLM 优化相结合来用预测强化物理推理的范式,使得物理和因果规律直接从交互后果中提炼,而非来自静态语料库。IPR 相较于基于 VLM、基于预测和基于强化学习的基线都产生了稳健的增益,并显示出对未见游戏的强大零样本迁移能力。