简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

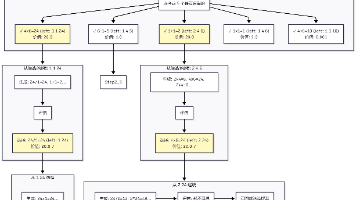

HiRAG是一种基于层次化知识增强的检索生成方法,通过构建多层级知识图谱提升问答效果。其核心流程包括:1)知识图谱构建,通过实体抽取、关系抽取形成基础图谱;2)实体层级聚类,使用高斯混合模型逐层聚合实体,以稀疏度(衡量聚类分散程度)作为停止条件;3)社区发现,采用Leiden算法检测知识社区。该方法创新性地融合了图拓扑层次和语义抽象层次,其中高层级的抽象实体(稀疏度≥98%)不参与检索但丰富了知识

本文介绍了基于聊天记录的问答系统实现方案,主要采用GraphRAG和Text2SQL两种技术相结合的方法。GraphRAG擅长处理全局性问题(如人物特征分析、话题检索等),而Text2SQL则适用于精确查询(如特定时间段的聊天记录查询)。文章详细阐述了两种技术的实现策略:GraphRAG通过实体关系抽取和合并来实现全局性回答,采用昵称映射解决特殊字符和复读问题;Text2SQL通过路径向量化和LL

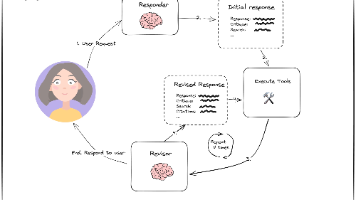

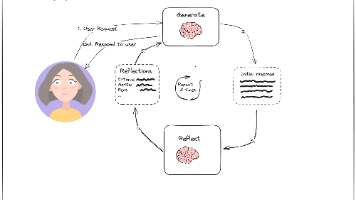

本文探讨了LangChain框架中Reflexion模块的实现与论文原版的差异。LangChain版本主要通过Revisor组件实现答案迭代优化,包含生成反思、搜索查询和修订答案的循环过程。而原论文Reflexion架构更强调记忆系统,包含短期记忆(记录历史优化轨迹)和长期记忆(存储优化经验)两个核心模块。实验代码可见于GitHub项目llm-reasoners,展示了基于语言模型的强化学习在智能

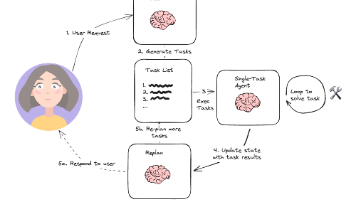

本文实验代码熟悉ReWOO的同学会发现,Plan-and-Solve怎么和ReWOO怎么那么像,实际上,本文要分享的是Plan-and-Execute。阅读本文之前,建议看看Agent之ReWOOPlan-and-Solve原文,实际只是对提示词的改进而已,主要是对原先的 “Let’s think step by step” 进行了一些细化。这里直接贴一下AI的理解:Plan-and-Solve核

文章摘要:本文介绍了大语言模型中的Reflection(反思)设计模式,通过让模型自我评估和迭代改进来提升输出质量。作者以作文写作为例,展示了如何让模型生成初稿后,再扮演教师角色进行评价,最后基于反馈重新生成改进版本。文章提供了两种实现方式:基础代码示例展示了单次反思流程,而LangGraph版本则实现了多轮迭代的自动化循环。该方法体现了"左右互搏"的模型自我优化思想,适用于需

本文对比了LeanRAG与HiRAG在图谱构建和推理过程上的差异。LeanRAG作为HiRAG的优化版本,简化了图谱构建过程,仅使用实体embedding的层级聚类,并采用最低共同祖先(LCA)路径搜索构建推理路径。核心算法包括:1)生成实体对组合;2)查找实体到根节点的路径;3)计算最短路径;4)收集关系信息。与HiRAG相比,LeanRAG通过LCA策略实现更紧凑的路径连接,减少上下文冗余,而

摘要:Tree of Thoughts (ToT)是一种新型的大语言模型推理框架,通过构建解决方案树实现多步推理。论文以Game24游戏为例,展示了ToT如何通过生成-评估-选择的三步循环进行智能搜索:首先生成多个候选操作(如1+1=2),然后评估每个候选的前景(sure/likely/impossible),最后选择最优路径继续探索。相比传统方法,ToT能同时考虑多种可能性,支持回溯修正,显著提

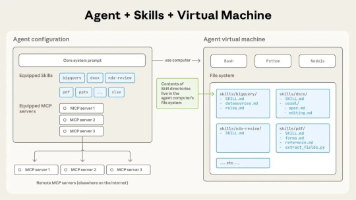

Agent Skills是一种模块化解决方案,通过标准化目录结构(包含SOP、工具和资源)为智能体提供特定任务能力。其核心优势在于分层加载机制:仅预加载技能名称和描述(约100 tokens),需要时才加载详细内容和资源,相比传统方式可节省90% token消耗。每个技能由SKILL.md文件定义,采用渐进式披露设计,包含YAML元数据和执行指南。技能还能捆绑确定性代码工具,提升执行效率。这种设计

本文探讨了如何让大语言模型(LLM)生成图文混排内容的方法。针对产品手册等知识库问答场景,提出了两个关键解决方案:1)通过调整提示词(Prompt),明确要求LLM保留并输出原始图片URL;2)针对长URL容易出错的问题,采用"短键映射"策略,先用唯一短键替换长URL,待LLM输出后再映射回原链接。文章还展示了实现代码片段,包括图片URL提取、短键生成和图片描述自动生成等关键步

前段时间想玩玩昇腾,发现华为云上租地GPU服务器,没有最新地cann8.0的镜像,自己折腾了许久,根本无法替换自己的镜像上去,此处省略一万字关于华为云的吐槽。启智社区提供了不少国产厂家的免费算力,接下来,话不多说,开整。