简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

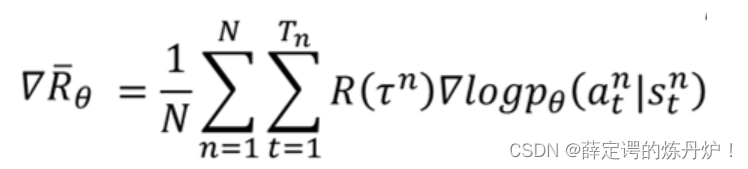

1、介绍了actor、environment、reward function2、在深度强化学习中,policy可以看成是参数为的网络,输入state,输出采取各种action的概率3、一轮游戏叫做episode4、trajectory={s1,a1,s2,a2,……},在给定policy的参数的情况下,可以计算每一个存在的概率。5、总的expected reward=6、使用policy grad

原文链接:https://zhuanlan.zhihu.com/p/86525700我有一个疑问,就是在推导过程中,状态s不是变量,st 是t阶段的状态相当于是一个常数,那么为什么st=s,常数在等号的左边,变量在等号的右边?这里的st表示的是t时刻对应的状态,状态可能有多种,但是这里设t时刻的状态为s,所以st=s。比如说放学回家,你一共有三种状态,写作业、看电视、打游戏,在某一时刻(这里可以对

原文链接:https://blog.csdn.net/ACL_lihan/article/details/104076938【李宏毅深度强化学习笔记】1、策略梯度方法(Policy Gradient)【李宏毅深度强化学习笔记】2、Proximal Policy Optimization (PPO) 算法【李宏毅深度强化学习笔记】3、Q-learning(Basic Idea)【李宏毅深度强化学习笔

RND算法流程原文链接:https://www.cnblogs.com/blog-hfg/articles/10452552.html总结:1.采用随机生成的固定网络作为目标网络,另一网络不断最小化与其的误差,从而达到评估观察的新颖性。2.介绍了一种灵活地结合内在和外在奖励的方法。abstract我们为深度强化学习方法引入了一个探索方法,该方法易于实现,并且为执行的计算增加了最小的开销。奖励是神经

原文链接:https://zhuanlan.zhihu.com/p/146309991EXPLORATION BY RANDOM NETWORK DISTILLATIONRND这类文章是基于强化学习在解决Atari游戏中蒙德祖玛的复仇的困境提出的。由于在这类游戏中存在非常稀疏的奖励,Agent在探索利用上存在很大的问题。RND也是第一个使用与人类平等的RL算法在蒙特祖玛的复仇上获得人类水平成绩的算

原文链接:https://blog.csdn.net/weixin_37895339/article/details/82863379前文是一些针对IRL,IL综述性的解释,后文是针对《Generative adversarial imitation learning》文章的理解及公式的推导。通过深度强化学习,我们能够让机器人针对一个任务实现从0到1的学习,但是需要我们定义出reward函数,在很

原文链接:https://blog.csdn.net/ACL_lihan/article/details/103989581补充:问题:PPO2的损失函数,也就是奖励的平均值函数是怎么通过约束重要性权重让θ和θk的输出分布不至于差距很大的?也就是让其不至于差太多,导致off-policy失效理解:当A>0时候,根据损失函数(奖励函数平均值),此时会提高pθ(s,a)的概率,所以设置上限,不让pθ(

原文链接:https://blog.csdn.net/xys430381_1/article/details/88370733?utm_medium=distribute.pc_relevant.none-task-blog-BlogCommendFromMachineLearnPai2-4.edu_weight&depth_1-utm_source=distribute.pc_relev

原文链接:https://blog.csdn.net/sinat_37422398/article/details/113085165\quad</span><span class="katex-html"><span class

【李宏毅G表示在采取一直玩到游戏结束所得到的cumulated reward。这个值是不稳定的,因为在某一个state采取同一个action,最后的结果不一定相同。因为state的变化也是有随机性的。虽然经过多次实验后,可能会发现G最后会变成一个比较稳定的分布,那么理论上收集足够多的数据就能解决这一问题。但是因为policy gradient是一个on policy的方法,每次更新参数后又要重新收