简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

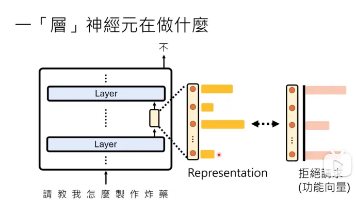

摘要:本文系统探讨了大语言模型的可解释性问题,从神经元、网络层到整体模型三个层面展开分析。研究发现:1)单个神经元具有多任务性,通过激活程度可识别其功能;2)网络层中存在可提取的"功能向量"(如拒绝、诚实等),通过SAE方法可解构3400万种功能向量;3)模型思维具有透明性,LogitLens技术显示答案形成过程,PatchScopes则揭示多步推理机制。研究表明大语言模型通过

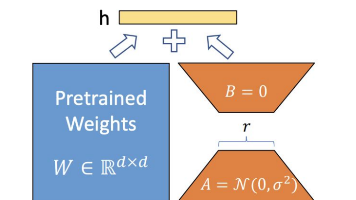

本文说明了LoRA的原理,并解释了为何LoRA在大模型后训练中可以显著减少需要训练的参数。同时本文详细解释了LoRA涉及的两个核心参数,并附有代码,详细说明了其中一个参数(LoRA-Rank)不同大小,对后训练模型参数量的影响

OpenAI近日公布AGI发展的五个阶段规划:从L1聊天机器人到L5组织者,逐步实现从基础对话到组织管理的跨越。其模型发展路线图显示,2024年将推出全模态GPT-4o和专注推理的o1系列,2025年计划发布具备超长上下文的GPT-4.1和支持复杂任务处理的o3等模型。GPT系列侧重语言处理,o系列专注推理能力,两者形成互补。该规划揭示了AI向更复杂决策和自主创新方向发展的趋势。(信息来源:Dee

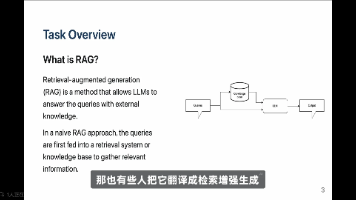

摘要:本视频介绍了检索增强生成(RAG)技术及其应用。RAG通过让大语言模型访问外部知识库来提升回答质量,解决了模型知识陈旧、训练成本高的问题,尤其适用于企业知识管理。视频还解释了Agent系统如何协同工作完成复杂任务:将用户问题分配给特定领域专家(如历史专家),并通过事实核查确保准确性。代码链接已提供,帮助理解RAG与Agent系统的实际应用。

本文可用于模型选型,梳理了通义千问与万相的区别,并整理了2025年1月-9月,Qwen、Wan发布的模型,解读模型名称含义,说明模型特征,使用场景。

本文参考书籍《深度学习革命》

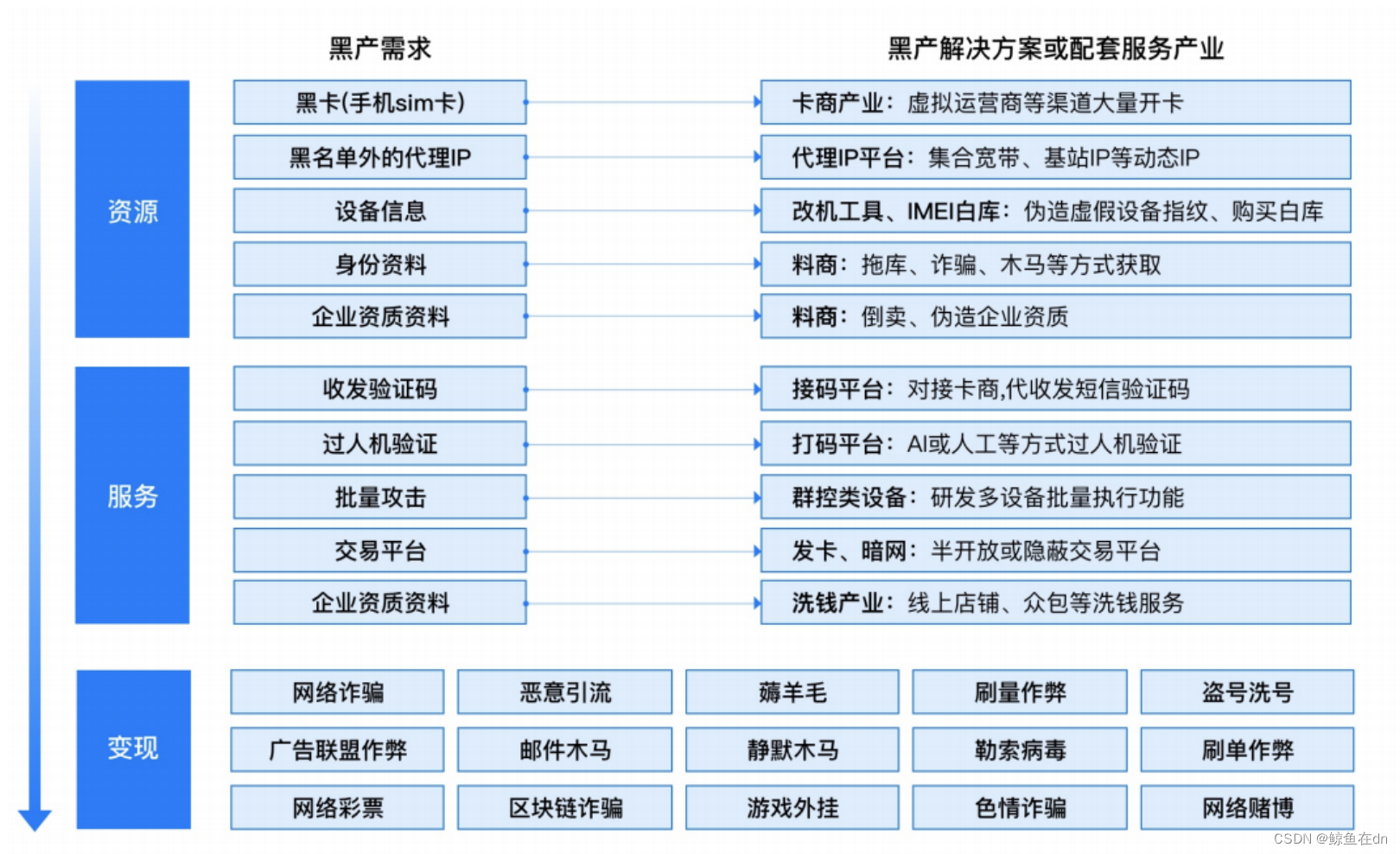

目前络产的产业链较成熟,作弊逃不开的两大要素——账号和设备,其背后都有完整的资源和服务链条,见图1。同时,由于广告投放还存在归因的步骤,因此,还有一种作弊手段为,媒体获得大量设备id发给广告主,抢夺归因的作弊手段,同见表1。(注意,根据国家的法律要求,设备指纹在生成ID的过程中,不可以使用用户的个人隐私信息,如通讯录、手机号码、短信等)[2]。注1:设备的指纹不是成不变的,会随着时代的发展,不断更

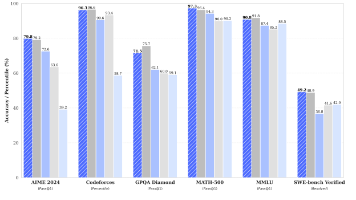

本节课主要探讨了“如何科学评估大型语言模型的推理能力”,指出当前模型可能依赖记忆而非真正推理,介绍了 ARC-AGI 和 Chatbot Arena 等评估平台,并提醒人们注意评估指标的局限性和误导性。

自定义函数(UDF)可以用 JVM 语言(例如 Java 或 Scala)或 Python 实现,实现者可以在 UDF 中使用任意第三方库,本文聚焦于使用 JVM 语言开发自定义函数。原文档:https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/dev/table/functions/udfs/

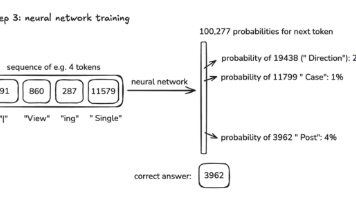

本文总结了安德鲁·卡帕西关于大语言模型的核心观点。大模型训练分为三个阶段:预训练(学习语料)、监督微调(学习对话)和强化学习(优化输出)。预训练包括数据处理、token化和神经网络参数调整;监督微调通过对话数据集教会模型应答;强化学习则让模型自主优化答案质量。文章还探讨了模型特性(如幻觉、记忆方式)和发展方向(多模态、任务代理等),并提供了相关资源链接。这种分阶段训练方法使大模型能逐步掌握从知识积