简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

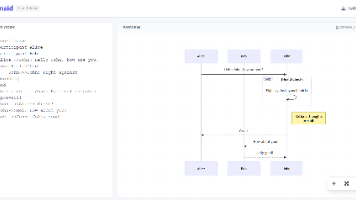

本文介绍了基于Mermaid.js的实时流程图编辑器交互功能优化方案。通过引入svg-pan-zoom专业库替代原生CSS变换,实现了更流畅的SVG交互体验。主要功能包括:鼠标滚轮缩放、左键拖拽平移流程图,并确保代码修改后视图自动重置。编辑器界面采用双栏设计(左侧代码编辑/右侧可视化预览),支持SVG导出功能,右下角提供缩放控制按钮。技术栈整合了Tailwind CSS、FontAwesome和M

《Python异步编程学习手册》摘要:本手册系统讲解Python异步编程核心概念,涵盖同步与异步模型对比、async/await语法、协程原理、事件循环机制、任务并发处理等关键知识点。通过标准库asyncio的实战示例,详细介绍异步I/O操作、上下文管理、异常处理、并发原语(锁/信号量/队列)及线程池交互等高级用法。特别说明协程函数与协程对象的区别,强调await关键字的正确使用场景。手册适合从入

本文介绍了一个文本分块工具Chunker的实现,支持三种分块策略:语义分块(semantic)、固定长度分块(fixed)和句子分块(sentences)。该工具通过指定pip包版本(transformers 4.43.4、torch 2.4.0等)确保环境兼容性。语义分块使用HuggingFaceEmbedding和SemanticSplitterNodeParser进行语义分析;固定长度分块按

本文详细解析了三种注意力机制:多头注意力(MHA)、多查询注意力(MQA)和分组查询注意力(GQA)。核心区别在于如何分配注意力头数量,主要解决Transformer模型在推理阶段的显存占用和带宽瓶颈问题。MHA表达能力最强但显存占用高;MQA显存占用最小但性能损失较大;GQA作为折中方案,在保持接近MHA性能的同时大幅降低显存需求。现代大模型(如LLaMA-2/3)普遍采用GQA,因其能平衡推理

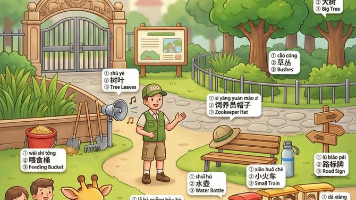

【代码】【banana pro prompt 儿童英语学习小报生成】

本文展示了使用火山引擎视觉API进行图像超分辨率处理的Python实现。代码包含两个核心部分:一是基于HMAC-SHA256的V4签名认证体系实现,通过signV4Request函数处理请求签名和API调用;二是具体业务实现,通过img2b64函数转换图片为Base64格式,并构造包含模型质量、输出格式等参数的请求体。示例使用6.jpg作为输入,指定中等质量(MQ)和PNG格式输出,最终返回的超分

本文档描述了一款清新手绘风格的竖版日历插画设计规范。插画以可爱时尚的年轻女性为主角,采用夸张配饰和明亮色彩,配合季节/节日特色造型。日历布局包含醒目的公历日期、英文月份、星期及农历信息,左侧竖向排列"宜事项"与励志短句。设计强调极简留白,可根据用户位置融入地域元素,整体呈现俏皮治愈的视觉风格。所有文字信息需根据用户输入自动生成,确保清晰易读的版式设计。

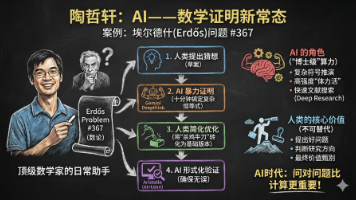

AI与数学家协作解决Er德ős问题 关键流程: 人类猜想:Wouter van Doorn提出反例草案 AI证明:Gemini用p-adic数论完成复杂验证(10分钟) 人类优化:陶哲轩简化证明(30分钟) AI验证:Aristotle工具完成形式化检验 核心启示: AI角色:处理符号推演/计算密集型任务(博士生水平) 人类优势:问题选择、方法简化、结果甄别 协作范式:人类主导方向,AI执行&qu

【代码】【T2Retrieval C_METB数据集 RAG召回测试数据集】

本文介绍了PaddleOCRVL的安装与使用方法。安装需通过pip安装指定版本的paddlepaddle-gpu、paddleocr和safetensors包。使用时可选择是否启用文档方向分类、文本矫正和版面检测功能,通过predict方法处理图像后,可输出结构化结果或保存为json/markdown格式。此外还提到可通过vllm/sglang进行docker和cli两种部署方案,但未展开具体内容