简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Hugging Face Transformers库中的Pipeline是一个高级API,封装了NLP任务的完整流程。它支持30多种任务类型,包括文本分类、问答、生成、多模态处理等。Pipeline的工作流程分为四个阶段:初始化(加载模型和分词器)、预处理(文本分词和数值化)、推理(模型预测)和后处理(结果解码和格式化)。关键参数包括任务类型、模型路径、设备选择(CPU/GPU)、序列长度控制等。

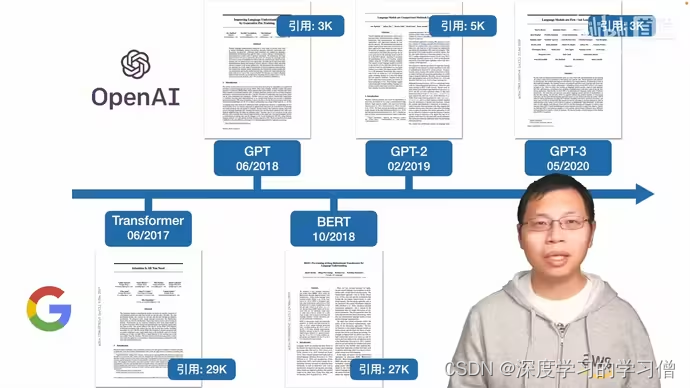

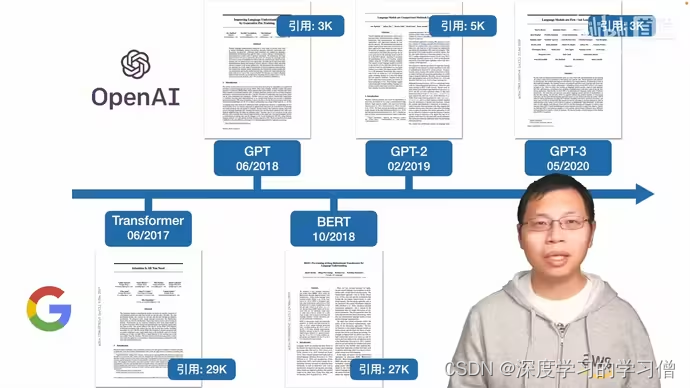

GPT是由OpenAI于2018年发布的模型。它采用了Transformer的编码器架构,通过自回归语言模型的方式进行预训练。

BERT 模型是一种双向变换器,使用掩码语言建模目标和对包含多伦多图书语料库和维基百科的大型语料库的下一句预测的组合进行预训练。BERT 旨在通过联合调节所有层中的左右上下文来预训练未标记文本的深度双向表示。

随着人工智能技术的不断进步,自然语言处理(NLP)领域也迎来了革命性的发展。OpenAI的ChatGPT及其后续产品在全球范围内引起了广泛关注,展示了大型语言模型(LLM)的强大能力。在这一背景下,GLM(General Language Model)作为一种创新的预训练语言模型,以其独特的自编码和自回归结合的训练方法,为NLP领域带来了新的视角。

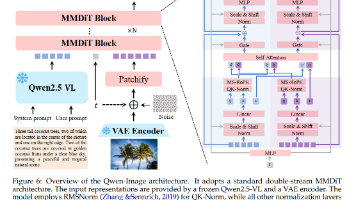

本系列活动的本质是“以读促研,以分享促深化”:通过精读论文定向提升科研硬实力,通过分享输出实现知识内化与价值传递。最终目标不仅是成为“AI论文的读者”,更希望能成为“AI领域的一名专家”和“技术创新的探索者”。这一过程既是个人科研成长的“练兵场”,也是对实现“从学习者到研究者”的转变具有重要意义。分割线近日,Qwen Team团队重磅推出Qwen系列在图像生成领域的全新力作——Qwen-Image

Tokenizer与词向量是NLP中两个核心概念:Tokenizer负责将文本切分成模型可处理的tokens(词/子词/字符),词向量则负责语义表示。传统NLP需要手动处理分词、构建词典、数字映射等步骤,预训练模型通过AutoTokenizer一键完成。主流分词算法包括BPE、WordPiece等,HuggingFace的Tokenizer API支持编码(文本→ID)、解码(ID→文本)双向转换

Hugging Face Transformers库中的Pipeline是一个高级API,封装了NLP任务的完整流程。它支持30多种任务类型,包括文本分类、问答、生成、多模态处理等。Pipeline的工作流程分为四个阶段:初始化(加载模型和分词器)、预处理(文本分词和数值化)、推理(模型预测)和后处理(结果解码和格式化)。关键参数包括任务类型、模型路径、设备选择(CPU/GPU)、序列长度控制等。

BERT 模型是一种双向变换器,使用掩码语言建模目标和对包含多伦多图书语料库和维基百科的大型语料库的下一句预测的组合进行预训练。BERT 旨在通过联合调节所有层中的左右上下文来预训练未标记文本的深度双向表示。

GPT是由OpenAI于2018年发布的模型。它采用了Transformer的编码器架构,通过自回归语言模型的方式进行预训练。

Hugging Face Transformers库中的Pipeline是一个高级API,封装了NLP任务的完整流程。它支持30多种任务类型,包括文本分类、问答、生成、多模态处理等。Pipeline的工作流程分为四个阶段:初始化(加载模型和分词器)、预处理(文本分词和数值化)、推理(模型预测)和后处理(结果解码和格式化)。关键参数包括任务类型、模型路径、设备选择(CPU/GPU)、序列长度控制等。