简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

NiFi SFTP 1.15最近的修复序很久没更新关于NiFi相关的内容了,其实NiFi现在在 cloudera 社区的热度居高不下,大量的思想火花与bug被修复。这里就谈谈关于SFTP相关的一些修复工作。auth: HadiBug众所周知,NiFi作为一个可视化低代码的开发工具,在项目里面那是一个快捷。我司就使用来作为数据接入、预处理的工作,其中大头部分就是SFTP部分,但从1.9.2升级到1.

在 set 命令第一个参数是 Bash shell 环境中设置或取消设置的标志,可以定义后面各种 shell 的运行方式,比如打印额外的信息等等。我们上述的文件运行文件结果都是直接打印在终端中,但很多时候我们是需要运行后的结果,并且保存到其他文件中。在某些字符串需要按照空格进行拆分的时候,可以直接使用 set -- STRING 就能够拆分,当然注意拆分后的变量赋值到入参中。如果我们直接进行运行的

看各类帖子都没能指出这些到底是什么意思,他们是冲突的,还是互相作用的,还是隔离的?本文讲解 `kafka` 中 `SASL`、`ACL`、`SSL` 他们分别的作用以及含义。

使用 knox 进行正向和反向代理,并且进行一些权限认证,使用起来很方便,特别是对于 NiFi 的相关权限认证(ldap),所以本章节讲下我使用 knox 代理的服务,以及相关的一些配置选项。/gateway/san在这里面的每个xml被视为一个集群,集群中可以有多个service。topologies目录下的xml文件才会被加载,如果下面有文件夹不会继续查找。默认已经帮我们把所有的配置好了,所以

Springboot版本为2.1.8.RELEASE本文包含内容,怎么使用SpringBoot-JPA进行数据查询。不定期更新。依赖<!--springboot 整合的数据连接--><dependency><groupId>org.springframework.boot</g...

Flink 定时获取HDFS 上某路径的parquet文件,并作为dim进行关联。序业务SQL 实现问题报错的时机报错详细社区回复解决序在进行Flink 开发的时候,使用的是Flink 1.13.2版本,当前版本对Flink SQL支持已经比较不错了,所以想用纯Flink SQL进行开发。业务消费Kafka 中的数据作为主表,获取HDFS路径上的某一个配置dim表进行关联然后输出到Kafka中。S

序since:2021年6月3日 19:32suth: Hadi注:由于为公司项目,所以大多数内容进行了屏蔽或删除处理,记录此只是希望大家继续学习,如果发现任何ip、人物、服务器等信息,请立即私信我进行更改,请勿走上违法犯罪道路!前言5月26号接到上级命令,协助优化Flink推送数据,现在问题有数据掉落,数据重复,数据积压,数据损坏等等,基本能遇到的数据推送的问题全都有了。所用核心数为105核(本

看各类帖子都没能指出这些到底是什么意思,他们是冲突的,还是互相作用的,还是隔离的?本文讲解 `kafka` 中 `SASL`、`ACL`、`SSL` 他们分别的作用以及含义。

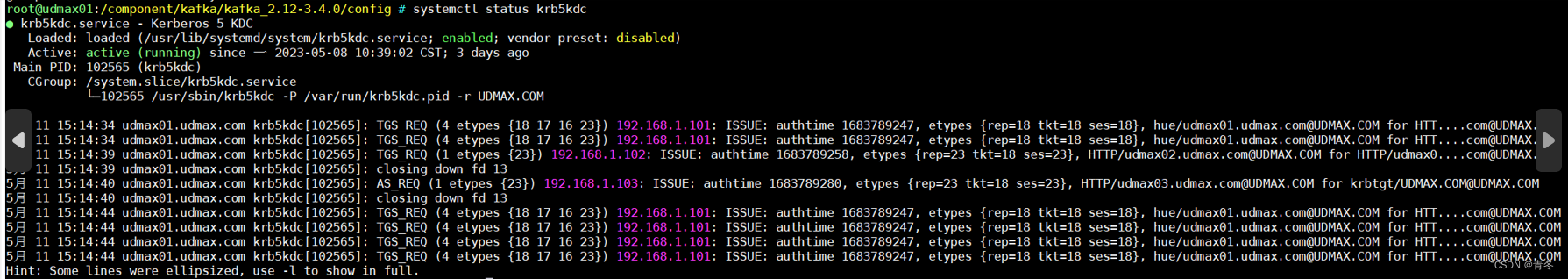

kafka sasl 搭建,以及 SSL 传输加密搭建,最新版本 kafka3.4 实操。其他节点只需要安装执行

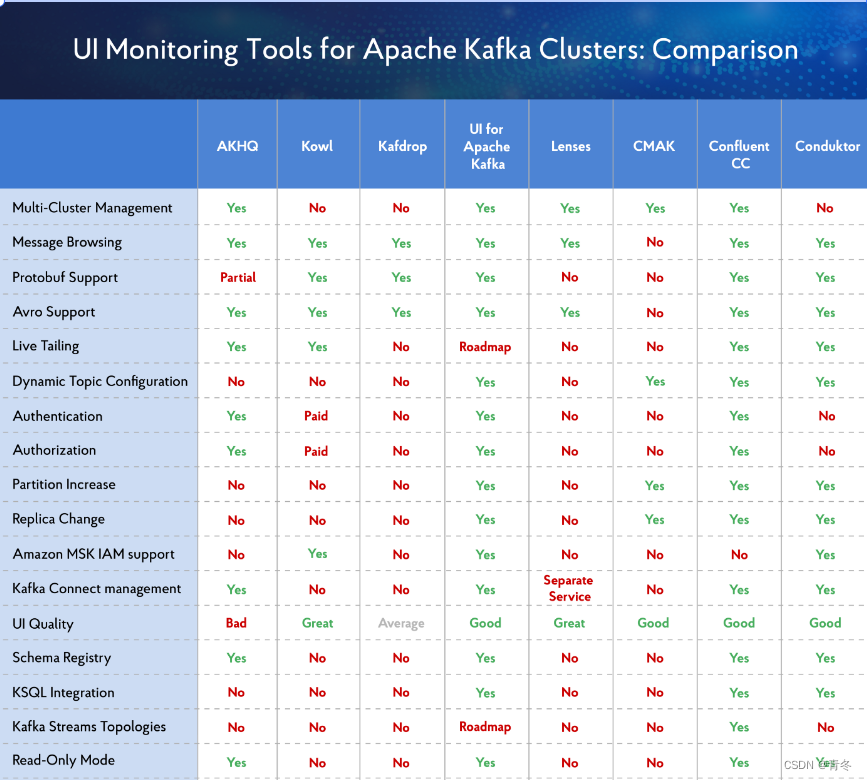

kafka 本身没有自带相关的 ui 界面,但是很多时候没有页面意味着只有使用命令行进行相关操作如创建 topic、更改 topic 信息、重置 offset 等等。但实际使用中这种效果很差劲,我们一般还是会借助其他软件,实现对 kafka 的页面管控。结合这张图与实际体验,推荐大家使用 ui for apache kafka 进行 kafka 的 ui 界面化管理。其实 kafka-ui 是没有