简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

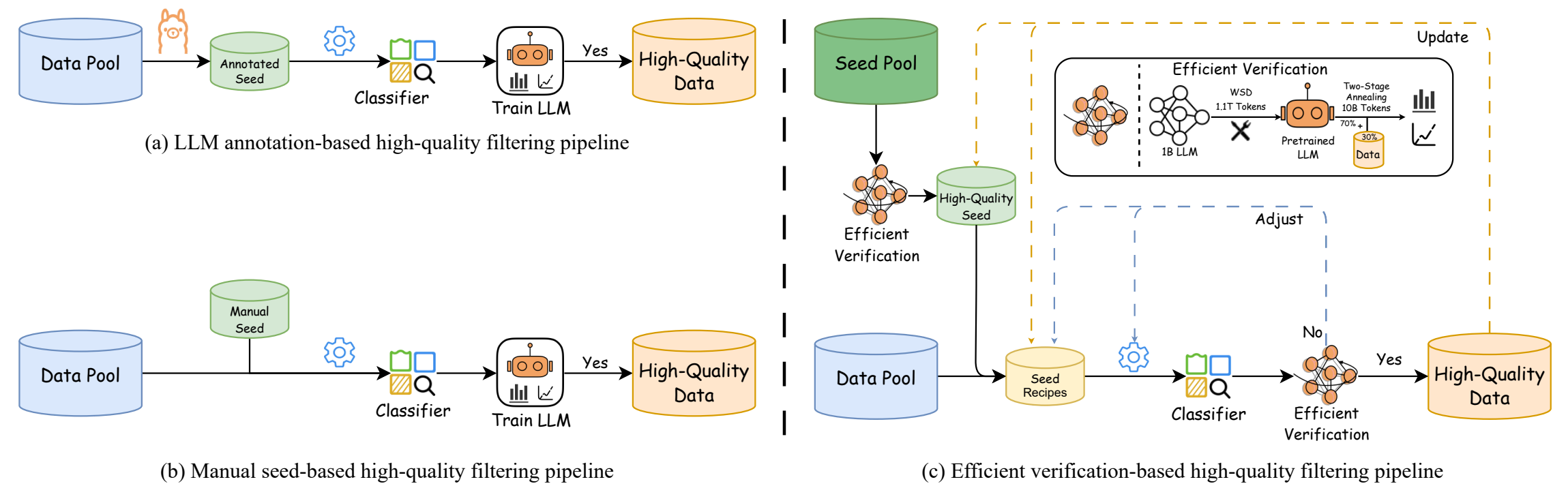

Ultra-FineWeb:高质量LLM训练数据的过滤与验证论文解读

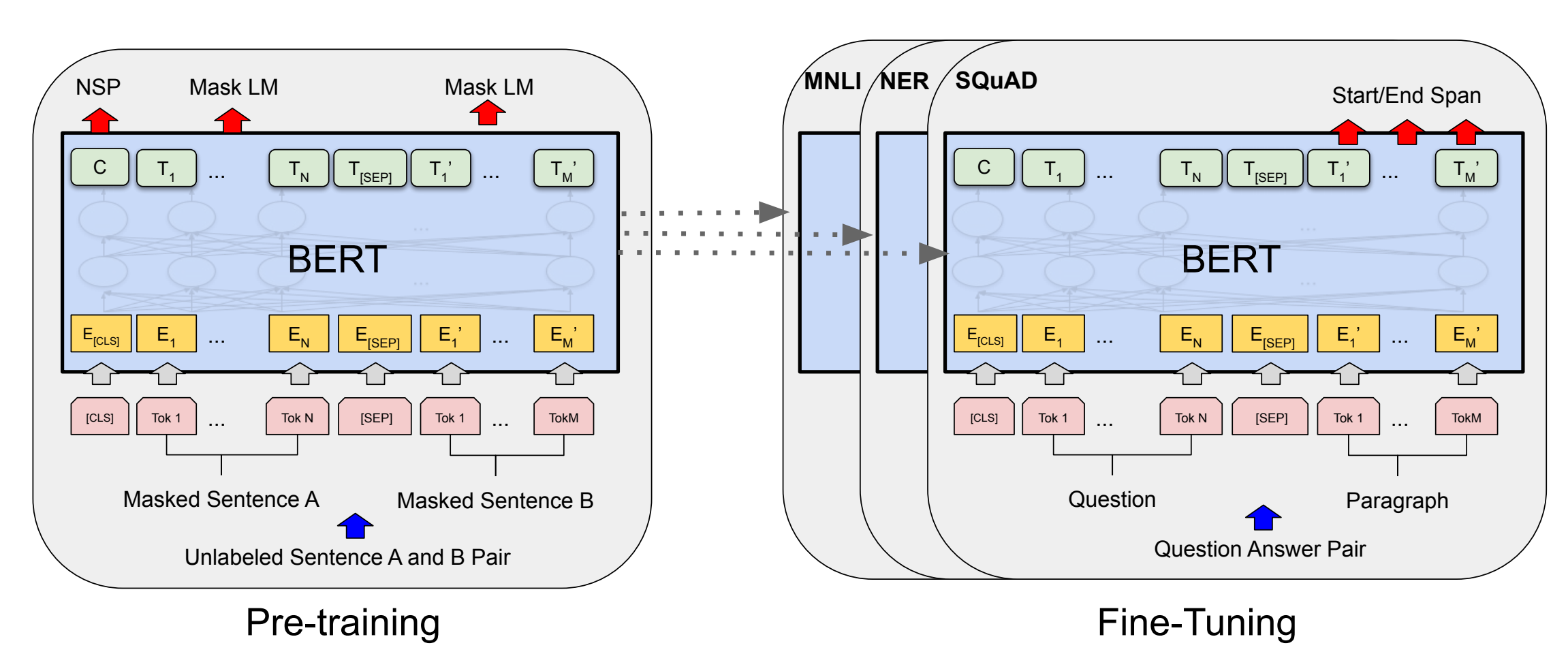

本文通过实验比较了Qwen3-0.6B和Bert在文本分类任务中的表现。实验使用AG News数据集,Bert通过添加线性层进行微调,而Qwen3-0.6B则通过构造Prompt进行SFT训练。结果显示,Bert在测试集上的F1得分为0.945,而Qwen3-0.6B的F1得分为0.944,两者表现接近。实验表明,尽管Qwen3-0.6B参数量较大,但在文本分类任务中并未显著优于Bert。实验还指

预训练是开发高性能语言模型(LM)的初步和基本步骤。尽管如此,预训练数据的设计却严重缺乏记录,而且往往是以缺乏经验支持的直觉为指导。为了解决这个问题,我们对28个1.5B参数的Decoder only模型进行了预训练,训练数据包括:(1)不同时间;(2)使用不同毒性和质量过滤器;(3) 不同领域组成的数据。首先,我们量化了预训练数据时效性的影响。评估数据和预训练数据之间的时间变化会导致性能下降,而

大语言模型(LLMs)通常需要在数十亿个tokens上进行预训练,一旦有了新数据,又要重新开始训练。更有效的解决方案是增量预训练(Continue PreTraining)这些模型,这与重新训练相比可以节省大量的计算资源。然而,新数据带来的分布偏移通常会导致在旧数据上的性能下降或者对新数据的适应性不佳。

大语言模型(LLMs)通常需要在数十亿个tokens上进行预训练,一旦有了新数据,又要重新开始训练。更有效的解决方案是增量预训练(Continue PreTraining)这些模型,这与重新训练相比可以节省大量的计算资源。然而,新数据带来的分布偏移通常会导致在旧数据上的性能下降或者对新数据的适应性不佳。

在Kaggle上使用Stable Diffusion进行AI绘图

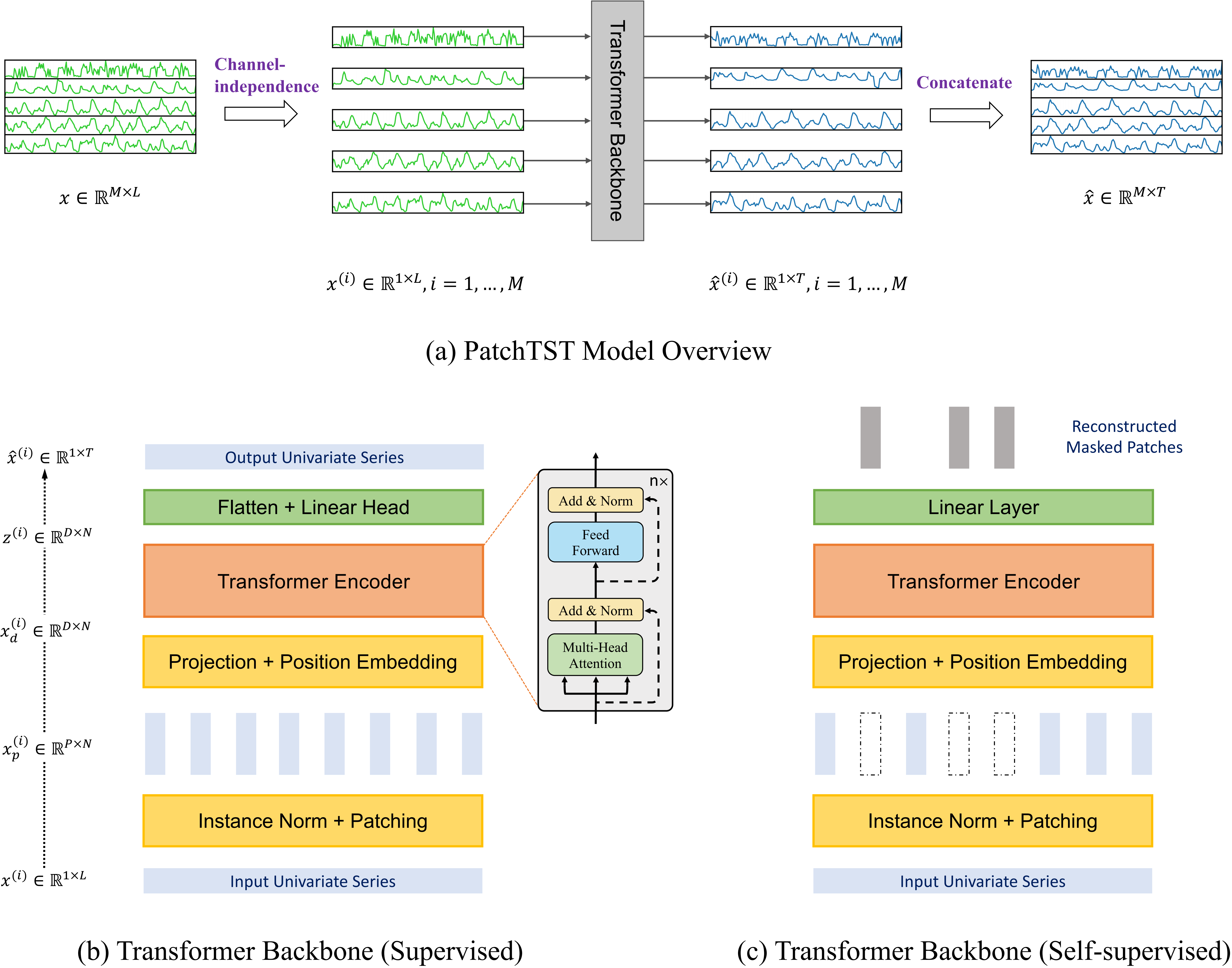

PatchTST模型代码解读

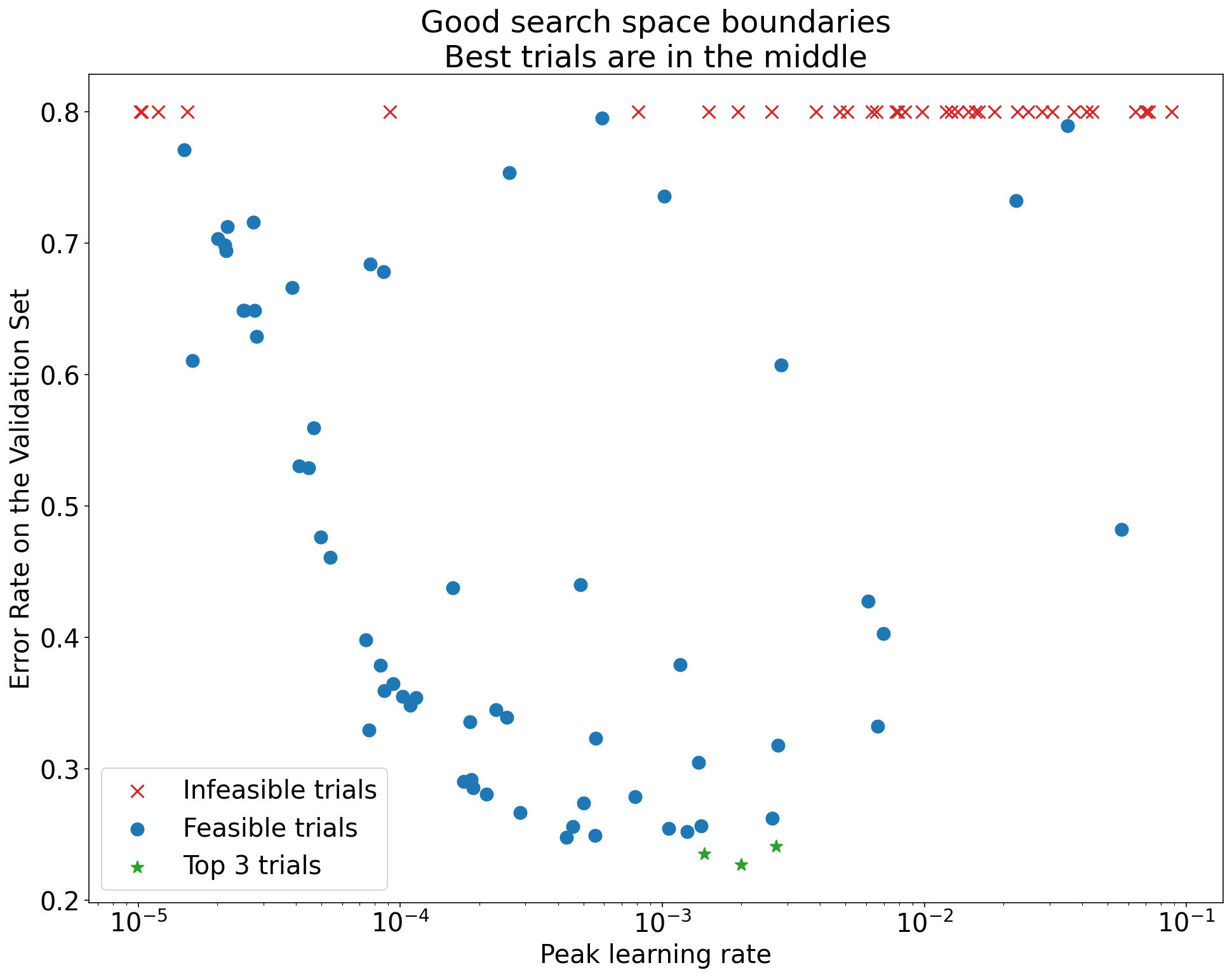

由五名研究人员和工程师组成的团队发布了《Deep Learning Tuning Playbook》,本文对手册进行了中文翻译

使用NNI框架对BERT模型进行粗剪枝、蒸馏与微调

Grad-CAM算法代码详解,并使用pytorch进行了实现